Redis 介绍与安装

1、Nosql 概述

NoSQL:Not Only SQL(不仅仅是 SQL)泛指非关系型的数据库

1、NoSQL 的特点:

- 方便扩展(数据之间没有关系,很好扩展)

- 大数据量高性能(Redis一秒写8万次,读取 11 万次,NoSQL 的缓存记录级,是一种细粒度的缓存,性能会比较高)

- 数据类型是多样型的(不需要事先设计数据库,随取随用)

- NoSql可以作为关系型数据库的良好补充,但是不能替代关系型数据库

2、传统 RDBMS 和 NoSQL的比较:

| RDBMS(关系型数据库) | NoSQL(非关系型数据库) |

|---|---|

| 结构化组织 | 不仅仅是数据 |

| SQL | 没有固定的查询语言 |

| 数据和关系都存在单独的表中 | 键值对存储,列存储,文档存储,图形数据库 |

| 操作语言,数据库定义语言 | 最终一致性 |

| 严格的一致性 | CAP 定理和 BASE (异地多活) |

| 基础的事务 | 高性能,高可用,高可扩展 |

| …. | …. |

3、NoSQL 应用场景:

- 大数据时代的3V:主要是描述问题的:海量Volume、多样Variety、实时Velocity

- 大数据时代的3高:主要是对程序的要求:高并发、高可扩、高性能

- 实际项目:NoSQL+ RDBMS 配合使用

NoSQL 的四大分类:

1、键值对(key-value)存储数据库:

- 相关产品:Redis、Tokyo Cabinet/Tyrant、Voldemort、Berkeley DB 等

- 典型应用:内存缓存,主要用于处理大量数据的高访问负载

- 数据模型:一系列键值对

- 优势:快速查询

- 劣势:存储的数据缺少结构化

2、文档型数据库(bson 和 json 一样):

相关产品:MongoDB、ConthDB

典型应用:web应用(与key-value类似,value是结构化的)

数据模型:一系列键值对

优势:数据结构要求不严格

劣势:数据结构要求不严格

MongoDB:MongoDB 是一个基于分布式文件储存的数据库,使用 C++编写,主要用来处理大量的文档。MongoDB 是一个介于关系型数据库和非关系型数据中间的产品!MongoDB 是非关系型数据中功能最丰富,最像关系型数据库

3、列存储数据库:

- 相关产品:Hbase、Riak、Cassandra

- 典型应用:分布式的文件系统

- 数据模型:以列簇式存储,将同一列数据存在一起

- 优势:查找速度快,可扩展性强,更容易进行分布式扩展

- 劣势:功能相对局限

4、图关系数据库:

相关数据库:Neo4J、InfoGrid、Infinite、Graph

典型应用:社交网络

数据模型:图结构

优势:利用图结构先关算法

劣势:需要对整个图做计算才能得出结果,不容易做分布式的集群方案。

备注:他不是存图形,放的是关系,比如:朋友圈社交网络,广告推荐

2、Redis 概述

1、官网文档及下载地址:

- Redis 官网: https://redis.io/

- Redis 官网下载地址:http://download.redis.io/releases/

2、非官方文档地址:

- Redis 中文网: http://www.redis.cn/、https://www.redis.net.cn/

- Redis 命令参考:http://redisdoc.com/

- 在线测试:http://try.redis.io/

- 使用文档:http://doc.redisfans.com/

3、Redis (Remote Dictionary Server):即远程字典服务,是一个开源的使用 ANSI C语言编写、支持网络、可基于内存亦可持久刷的日志型、key-value 数据库,并提供多种语言的 API。免费和开源!是当下最热门的NoSQL 技术之一,也被人们称之为机构化数据库

4、Redis 的特征:多样化的数据类型、持久化、集群、事务

5、Redis 的作用:

- 内存存储、持久化(RDB 和 AOF)

- 效率高,可以用于高速缓存

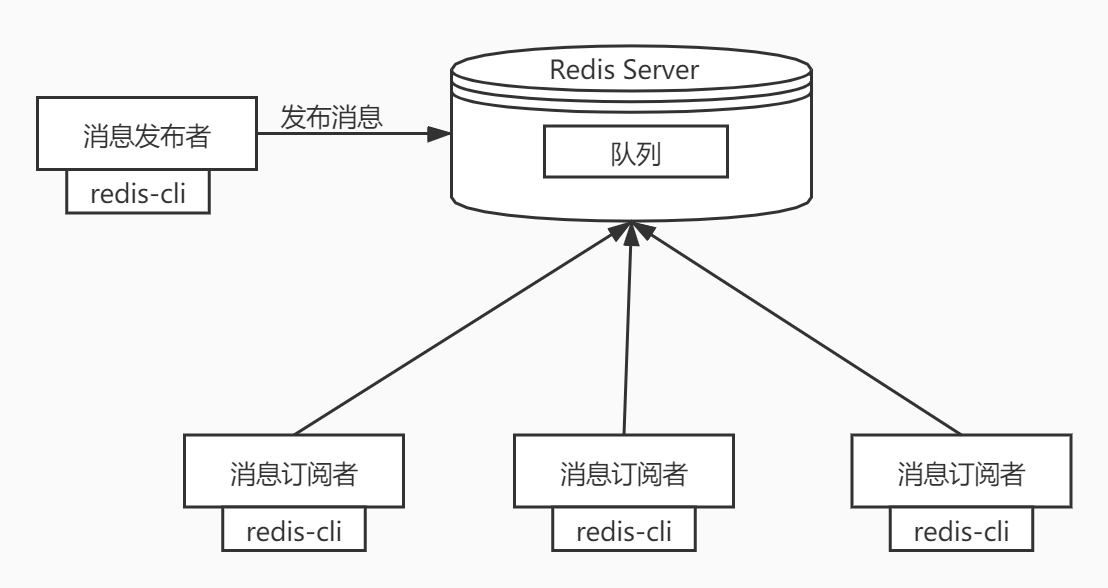

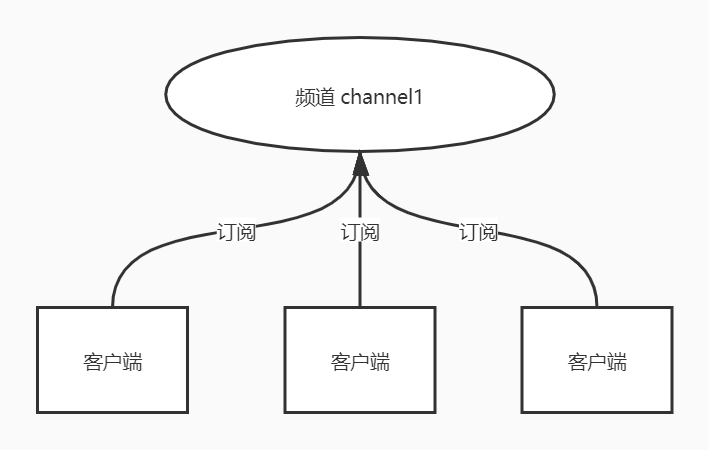

- 发布订阅系统

- 地图信息分析

- 计数器、计时器(比如浏览量)

6、Redis 应用场景:

- 内存数据库(登录信息、购物车信息、用户浏览记录等)

- 缓存服务器(商品数据、广告数据等等)(最多使用)

- 解决分布式集群架构中的 Session 分离问题(Session共享)

- 任务队列(秒杀、抢购、12306等等)

- 支持发布订阅的消息模式

- 应用排行榜

- 网站访问统计

- 数据过期处理(可以精确到毫秒)

3、Redis wins 安装

1、下载安装包:https://github.com/tporadowski/redis/releases

2、下载完毕得到压缩包解压:Redis-x64-5.0.9.zip

3、启动Redis:双击 redis-server.exe 运行服务

[24304] 29 Aug 11:32:40.572 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

[24304] 29 Aug 11:32:40.572 # Redis version=5.0.9, bits=64, commit=9414ab9b, modified=0, pid=24304, just started

[24304] 29 Aug 11:32:40.575 # Warning: no config file specified, using the default config. In order to specify a config file use d:\environment\redis\redis-x64-5.0.9\redis-server.exe /path/to/redis.conf

_._

_.-``__ ''-._

_.-`` `. `_. ''-._ Redis 5.0.9 (9414ab9b/0) 64 bit

.-`` .-```. ```\/ _.,_ ''-._

( ' , .-` | `, ) Running in standalone mode

|`-._`-...-` __...-.``-._|'` _.-'| Port: 6379

| `-._ `._ / _.-' | PID: 24304

`-._ `-._ `-./ _.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' | http://redis.io

`-._ `-._`-.__.-'_.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' |

`-._ `-._`-.__.-'_.-' _.-'

`-._ `-.__.-' _.-'

`-._ _.-'

`-.__.-'

[24304] 29 Aug 11:32:40.581 # Server initialized

[24304] 29 Aug 11:32:40.581 * Ready to accept connections

4、使用Redis客户端连接:点击 redis-cli.exe,输入ping,出现如图PONG结果即连接成功

127.0.0.1:6379> ping

PONG

127.0.0.1:6379>

5、常用的redis服务命令

安装服务:redis-server –service-install redis.windows-service.conf –loglevel verbose

卸载服务:redis-server –service-uninstall

开启服务:redis-server –service-start

停止服务:redis-server –service-stop

重命名服务:redis-server –service-name rename

# 安装服务:

# redis.windows-service.conf 为启动的配置文件

# --loglevel verbose表示记录日志等级

redis-server --service-install redis.windows-service.conf --loglevel verbose

redis-server --service-install --service-name Redis6 redis.windows-service.conf --loglevel verbose

# 开启服务:

redis-server --service-start

redis-server --service-start --service-name Redis6

# 停止服务:

redis-server --service-stop

redis-server --service-stop --service-name Redis6

# 卸载服务:

redis-server --service-uninstall

redis-server --service-uninstall --service-name Redis6

# 以下将会安装并启动三个不同的Redis实例作服务:

redis-server –service-install --service-name redisService1 --port 10001

redis-server –service-install --service-name redisService2 --port 10002

redis-server –service-install --service-name redisService3 --port 10003

redis-server –service-start --service-name redisService1

redis-server –service-start --service-name redisService2

redis-server –service-start --service-name redisService3

4、Redis linux 安装

1、下载安装包并将压缩包上传到服务器:redis 6.0.6.tar.gz

2、解压Redis安装包:自己的程序一般放在/opt目录下

# 下载redis-6.0.6.tar.gz安装包

wget -P /opt http://download.redis.io/releases/redis-6.0.6.tar.gz

# 解压Redis压缩包

tar -zxvf /opt/redis-6.0.6.tar.gz

###### 或者执行下面命令 #######

tar -zxvf redis-6.0.6.tar.gz -C /opt/

3、进入Redis目录:查看解压后的文件,可以看到Redis的配置文件redis.conf

[root@CentOS7 redis-6.0.6]# cd /opt/redis-6.0.6

[root@CentOS7 redis-6.0.6]# ls

00-RELEASENOTES COPYING Makefile redis.conf runtest-moduleapi src utils

BUGS deps MANIFESTO runtest runtest-sentinel tests

CONTRIBUTING INSTALL README.md runtest-cluster sentinel.conf TLS.md

4、基本的环境安装(需要进入redis目录)

Redis6.0以下版本安装

######################### Redis6.0以下版本 ############################### # 增加环境支持 [root@CentOS7 redis-6.0.6]# yum install gcc-c++ # 编译并安装 [root@CentOS7 redis-6.0.6]# make && make installRedis6.0以上版本安装

######################### Redis6.0以上版本 ############################### ############# 安装编译redis6需要升级gcc,默认自带的gcc版本比较老 ############## # 安装 gcc [root@CentOS7 redis-6.0.6]# yum install -y gcc-c++ autoconf automake # centos7 默认的 gcc 默认是4.8.5,版本小于 5.3 无法编译,需要先安装gcc新版才能编译 [root@CentOS7 redis-6.0.6]# gcc -v .... gcc version 4.8.5 20150623 (Red Hat 4.8.5-44) (GCC) # 升级新版gcc,配置永久生效 [root@CentOS7 redis-6.0.6]# yum -y install centos-release-scl [root@CentOS7 redis-6.0.6]# yum -y install devtoolset-9-gcc devtoolset-9-gcc-c++ devtoolset-9-binutils # 让新版gcc环境变量临时生效,2者执行一个即可 [root@CentOS7 redis-6.0.6]# scl enable devtoolset-9 bash # 让新版gcc环境变量永久生效,2者执行一个即可 [root@CentOS7 redis-6.0.6]# echo "source /opt/rh/devtoolset-9/enable" >>/etc/profile [root@CentOS7 redis-6.0.6]# gcc -v .... gcc version 9.3.1 20200408 (Red Hat 9.3.1-2) (GCC) # 编译并安装redis,make install 默认PREFIX是:/usr/local [root@CentOS7 redis-6.0.6]# make && make install # 编译并安装到指定目录 [root@CentOS7 redis-6.0.6]# mkdir -p /usr/local/redis [root@CentOS7 redis-6.0.6]# make && make PREFIX=/usr/local/redis install

5、进入 Redis 安装路径(如果没有指定 PREFIX 的话默认命令路径是/usr/local/bin)

[root@CentOS7 bin]# ll /usr/local/redis/bin

-rwxr-xr-x 1 root root 4739840 Aug 29 12:15 redis-benchmark # 性能测试的工具

-rwxr-xr-x 1 root root 9653568 Aug 29 12:15 redis-check-aof # aof文件进行检查的工具

-rwxr-xr-x 1 root root 9653568 Aug 29 12:15 redis-check-rdb # rdb文件进行检查的工具

-rwxr-xr-x 1 root root 5059032 Aug 29 12:15 redis-cli # 进入redis命令客户端

lrwxrwxrwx 1 root root 12 Aug 29 12:15 redis-sentinel -> redis-server # 启动哨兵监控服务

-rwxr-xr-x 1 root root 9653568 Aug 29 12:15 redis-server # 启动redis服务

6、启动 Redis 服务

[root@CentOS7 bin]# ./redis-server

6965:C 20 Aug 2021 12:06:31.892 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

6965:C 20 Aug 2021 12:06:31.892 # Redis version=6.0.6, bits=64, commit=00000000, modified=0, pid=6965, just started

6965:C 20 Aug 2021 12:06:31.892 # Warning: no config file specified, using the default config. In order to specify a config file use ./redis-server /path/to/redis.conf

_._

_.-``__ ''-._

_.-`` `. `_. ''-._ Redis 6.0.6 (00000000/0) 64 bit

.-`` .-```. ```\/ _.,_ ''-._

( ' , .-` | `, ) Running in standalone mode

|`-._`-...-` __...-.``-._|'` _.-'| Port: 6379

| `-._ `._ / _.-' | PID: 6965

`-._ `-._ `-./ _.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' | http://redis.io

`-._ `-._`-.__.-'_.-' _.-'

|`-._`-._ `-.__.-' _.-'_.-'|

| `-._`-._ _.-'_.-' |

`-._ `-._`-.__.-'_.-' _.-'

`-._ `-.__.-' _.-'

`-._ _.-'

`-.__.-'

6965:M 20 Aug 2021 12:06:31.893 # WARNING: The TCP backlog setting of 511 cannot be enforced because /proc/sys/net/core/somaxconn is set to the lower value of 128.

6965:M 20 Aug 2021 12:06:31.893 # Server initialized

6965:M 20 Aug 2021 12:06:31.893 # WARNING overcommit_memory is set to 0! Background save may fail under low memory condition. To fix this issue add 'vm.overcommit_memory = 1' to /etc/sysctl.conf and then reboot or run the command 'sysctl vm.overcommit_memory=1' for this to take effect.

6965:M 20 Aug 2021 12:06:31.893 # WARNING you have Transparent Huge Pages (THP) support enabled in your kernel. This will create latency and memory usage issues with Redis. To fix this issue run the command 'echo never > /sys/kernel/mm/transparent_hugepage/enabled' as root, and add it to your /etc/rc.local in order to retain the setting after a reboot. Redis must be restarted after THP is disabled.

6965:M 20 Aug 2021 12:06:31.894 * Ready to accept connections

5、Redis linux 卸载

# 1.停止redis服务器

[root@CentOS7 ~]# /opt/redis-6.0.6/src/redis-cli shutdown

# 2.删除make的时候生成的几个redisXXX的文件,如果install有指定PREFIX则换成指定目录即可

[root@CentOS7 ~]# rm -rf /usr/local/bin/redis*

# 3.顺便也删除掉解压后的文件目录和所有文件

[root@CentOS7 ~]# rm -rf /opt/redis-6.0.6

6、Redis 配置文件

Redis 默认配置文件路径为:./redis-6.0.6/redis.conf,我们可以直接修改它或将它拷贝到其他位置,然后指定配置文件路径启动服务

1、必须要知道的Redis配置

| 配置项 | 描述 |

|---|---|

| protected-mode yes(保护模式,默认yes) | yes:需配置bind ip或设密码,no:外部网络可以直接访问 |

| daemonize yes | 配置Redis是否为后台运行,默认 no |

| bind 127.0.0.1(绑定指定ip访问) | 0.0.0.0是不限制,配置多个 ip 用空格隔开 |

| port 6379 | Redis 运行端口,默认 6379 |

| requirepass password | 密码配置,默认没配置 |

| dir /usr/local/redis/data | 保存缓存数据文件目录(父目录必须存在) |

| dbfilename xxxx | 配置 Redis 持久化文件名称 |

| logfile “/usr/local/redis/logs/redis.log” | 设置日志保存目录(父目录必须存在) |

| pidfile /usr/local/redis/redis_6379.pid | 设置进程保存路径(父目录必须存在) |

| databases16 | 该Redis支持的数据库个数(0~15) |

2、创建目录:日志(log)、数据(data)、配置文件(conf)

[root@CentOS7 redis]# mkdir -p /usr/local/redis/{conf,log,data}

[root@CentOS7 redis]# ll

total 16

drwxr-xr-x 2 root root 4096 Aug 20 12:15 bin

drwxr-xr-x 2 root root 4096 Aug 20 12:33 conf

drwxr-xr-x 2 root root 4096 Aug 20 12:33 data

drwxr-xr-x 2 root root 4096 Aug 20 12:33 log

3、创建自定义配置文件 (使用自带的也行)

bind 0.0.0.0 # 任何ip可以访问

daemonize yes # 守护进程,后台启动

requirepass 123456 # 密码

dir /usr/local/redis/data # 持久化文件存储路径

dbfilename redis.rdb # 持久化文件名称

logfile "/usr/local/redis/log/redis.log" # 日志文件

pidfile /usr/local/redis/redis_6379.pid # 进程保存路径

########################################分割线,无注释版########################################

bind 0.0.0.0

daemonize yes

requirepass 123456

dir /usr/local/redis/data

dbfilename redis.rdb

logfile "/usr/local/redis/log/redis.log"

pidfile /usr/local/redis/redis_6379.pid

4、后台启动Redis服务(因为使用指定配置文件启动,而配置文件中设置了守护进程后台启动):

[root@CentOS7 ~]# /usr/local/redis/bin/redis-server /usr/local/redis/conf/redis.conf

5、使用Redis客户端连接测试

[root@CentOS7 bin]# /usr/local/redis/bin/redis-cli

127.0.0.1:6379> ping

PONG

127.0.0.1:6379> set name test

OK

127.0.0.1:6379> get name

"test"

127.0.0.1:6379> keys *

1) "name"

6、新开一个窗口,查看 Redis 进程:

[root@CentOS7 ~]# ps -ef|grep redis

root 19890 1 0 13:00 ? 00:00:00 /usr/local/redis/bin/redis-server 0.0.0.0:6379

root 20167 1470 0 13:05 pts/0 00:00:00 /usr/local/redis/bin/redis-cli

root 20173 20078 0 13:05 pts/1 00:00:00 grep --color=auto redis

7、关闭和退出Redis服务:

#################### 方式一关闭Redis ################

127.0.0.1:6379> shutdown # 关闭Redis

not connected> exit # 退出

[root@CentOS7 bin]# ps -ef|grep redis

root 8330 3437 0 08:49 pts/1 00:00:00 grep --color=auto redis

#################### 方式二关闭Redis ################

[root@CentOS7 bin]# ./redis-cli shutdown

#################### 方式三关闭Redis ################

[root@CentOS7 bin]# ps -ef|grep redis

[root@CentOS7 bin]# kill -9 PID

7、Redis 常用命令

| 描述 | 命令 |

|---|---|

| 指定配置文件启动Redis服务进程 | /usr/local/redis/bin/redis-server /usr/local/redis/conf/redis.conf |

| 关闭Redis服务进程 | /usr/local/redis/bin/redis-cli shutdown |

| 连接本机Redis数据库 | /usr/local/redis/bin/redis-cli |

| 连接远程Redis数据库 | /usr/local/redis/bin/redis-cli -h 127.0.0.1 -p 6379 |

| 进行端口查询Redis进程是否启动 | netstat -tunlp |grep 6379 |

| 干掉所有的Redis服务 | killall redis-server |

| Redis性能测试工具 | /usr/local/bin/redis-benchmark -n 10000-d 50 -c 2000 |

8、Redis 简单操作

Redis 默认有 16 个数据库,默认使用的是第 0 个(配置文件中默认配置)

切换数据库:select index

查看数据库大小:dbsize

查看数据库中所有key:keys *

清除当前数据库:flushdb

清除所有数据库:flushall

[root@liusx bin]# redis-cli -p 6379

127.0.0.1:6379> ping # 测试是否连接成功

PONG

127.0.0.1:6379> select 3 # 切换数据库

OK

127.0.0.1:6379[3]> dbsize # 查看数据库大小(key的个数)

(integer) 0

127.0.0.1:6379[3]> set name sam # 设置key-value

OK

127.0.0.1:6379[3]> dbsize # 查询key个个数

(integer) 1

127.0.0.1:6379[3]> keys * # 查询所有key

1) "name"

127.0.0.1:6379[3]> flushdb # 清空当前数据库的所有数据

OK

127.0.0.1:6379> flushall # 清空所有数据库的数控

OK

127.0.0.1:6379> keys *

(empty list or set)

9、参考资料 & 鸣谢

- 最新版Redis安装配置教程(Wins+Linux)【CSDN:Baret-H】https://blog.csdn.net/qq_45173404/article/details/107715530

- (Redis):Redis 通用指令:https://blog.csdn.net/baidu_41388533/article/details/108926086

- Redis6.x 在Windows上面编译安装的过程:https://mp.weixin.qq.com/s/TCUaNWCCUDhpeG7oigHsnw

- Windows编译安装新版Redis:https://mp.weixin.qq.com/s/if7YgScZmHjZkfDn2bMxzw

Redis 五种基本数据类型

中文网可查看命令: http://www.redis.cn/commands.html

1、Key(键操作命令)

| 命令 | 描述 |

|---|---|

| del key [key…] | 删除指定数据,不存在key将被忽略 |

| exists key | 判断 key 是否存在 |

| expire key seconds | 设置 key 的过期时间,单位秒 |

| expireat key timestamp | 同 expire,但是是 Unix 时间戳,单位秒 |

| pexpire key milliseconds | 设置 key 的过期时间,单位毫秒 |

| pexpireat key milliseconds-timestamp | 同 pexpire,但是是 Unix 时间戳,单位毫秒 |

| keys pattern | 查询所有符合 pattern 的 key |

| rename key newkey | 将key改名newkey,当key和newkey相同或key不存在会报错 |

| randomkey | 从当前数据库随机返回且不删除一个key |

| ttl key | 查看当前 key 的剩余过期时间,单位秒 |

| pttl key | 查看当前 key 的剩余过期时间,单位毫秒 |

| persist key | 切换key从时效性转换为永久性 |

| type key | 查看当前 key 的类型 |

| sort key | 对所有key(list)排序 |

| move key db | 数据移动到另一个db(条件:当前db有key,给定db没有key) |

| dump key | 序列化key的值 |

| help @generic | 帮助文档:key通用操作 |

1、正则匹配查询键

正则匹配查询key、判断key是否存在

# 查询所有key

127.0.0.1:6379> keys *

1) "k3"

2) "k2"

3) "name"

4) "k1"

# 正则匹配查询

127.0.0.1:6379> keys k*

1) "k3"

2) "k2"

3) "k1"

# 判断name是否存在

127.0.0.1:6379> exists name

(integer) 1

查询匹配规则

keys * 查询所有

keys it* 查询所有以it开头

keys *heima 查询所有以heima结尾

keys ??heima 查询所有前面两个字符任意,后面以heima结尾

keys user:? 查询所有以user:开头,最后一个字符任意

keys u[st]er:1 查询所有以u开头,以er:1结尾,中间包含一个字母, s或t

2、设置查询取消键过期时间

为key设置过期时间、查询key过期时间、取消key的过期时间

127.0.0.1:6379> expire name 60

(integer) 1

127.0.0.1:6379> ttl name

(integer) 57

127.0.0.1:6379> ttl name

(integer) 54

127.0.0.1:6379> persist name

(integer) 1

127.0.0.1:6379> ttl name

(integer) -1

3、查看key的类型

127.0.0.1:6379> set age 18

OK

127.0.0.1:6379> set name xm

OK

127.0.0.1:6379> type name

string

127.0.0.1:6379> type age

string

4、为指定key改名、删除指定key

127.0.0.1:6379> rename age age:1

OK

127.0.0.1:6379> keys *

1) "age:1"

2) "k3"

3) "k2"

4) "k1"

5) "name"

127.0.0.1:6379> keys age:1

1) "age:1"

127.0.0.1:6379> del age:1

(integer) 1

127.0.0.1:6379> keys age:1

(empty array)

5、随机弹出一个key且不删除它

127.0.0.1:6379> randomkey

"k3"

127.0.0.1:6379> randomkey

"name"

127.0.0.1:6379> randomkey

"k3"

6、序列化key的值

127.0.0.1:6379> dump name

"\x00\x02xm\t\x00i\xf6\xcb\xafy\x0b\\\xb7"

2、String(字符串)

1、String 类型介绍

String类型是Redis中最为基础的数据存储类型,字符串键值结构(key value),它在Redis中是二进制安全的,这便意味着该类型可以接受任何格式的数据,如JPEG图像数据或Json对象描述信息等,在Redis中字符串类型的Value最多可以容纳的数据长度是512M。一般建议一个key-value的大小为100k。

2、命令和示例

| 命令 | 描述 |

|---|---|

| SET key value | 设置指定 key 的值 |

| GET key | 获取指定 key 的值 |

| MSET key value [key value …] | 同时设置给定 key-value 对 |

| MGET key1 [key2..] | 获取所有给定 key 的值,要么一起成功,要么都失败 |

| SETNX key value | 只有在 key 不存在时设置 key 的值(仅当不存在时赋值) |

| MSETNX key value [key value …] | 同时设置一个或多个 key-value 对,当且仅当所有给定 key 都不存在 |

| SETEX key seconds value | 将 key 的过期时间设为 seconds (以秒为单位) |

| PSETEX key milliseconds value | 这个命令和 SETEX 命令相似,但它以毫秒为单位设置 key 的生存时间 |

| GETSET key value | 将给定 key 的值设为 value ,并返回 key 的旧值(old value) |

| GETRANGE key start end | 返回 key 中字符串值的子字符 |

| SETRANGE key offset value | 用 value 参数覆写给定 key 所储存的字符串值,从偏移量 offset 开始 |

| APPEND key value | 若 key 存在并是字符串,APPEND 命令会将 value 追加 旧 value 后面 |

| STRLEN key | 返回 key 所储存的字符串值的长度 |

| INCR key | 将 key 中储存的数字值增 1 |

| INCRBY key increment | 将 key 所储存的值加上给定的增量值(increment) |

| INCRBYFLOAT key increment | 将 key 所储存的值加上给定的浮点增量值(increment) |

| DECR key | 将 key 中储存的数字值减 1 |

| DECRBY key decrement | key 所储存的值减去给定的减量值(decrement) |

赋值、取值操作

127.0.0.1:6379> set name Sam # 赋值

OK

127.0.0.1:6379> get name # 取值

"Sam"

127.0.0.1:6379> mset age 18 sex 1 # 批量赋值

OK

127.0.0.1:6379> mget age sex # 批量取值

1) "18"

2) "1"

127.0.0.1:6379> setnx name mier # 仅当不存在时赋值

(integer) 0

127.0.0.1:6379> get name # 若存在则无法赋值

"Sam"

127.0.0.1:6379> msetnx name sam address guangzhou # msetnx 是一个原子性的操作,要么一起成功,要么都失败

(integer) 0

127.0.0.1:6379> get address

(nil)

127.0.0.1:6379> getset namex sam # 取值并赋值,如果不存在值,则返回 nil

(nil)

127.0.0.1:6379> getset name nick # 取值并赋值,如果存在值,则先返回旧值,再设置新值

"Sam"

127.0.0.1:6379> get name

"nick"

设置过期时间

- 查看当前剩余有效时间:ttl key

- 如果该内容已经消失则返回 -2

- 如果没有消失返回剩余的时间

- 如果没有设置过期时间获取取消了过期时间,那么返回 -1

- 取消 key 的有效时间(在有效期内):persist key

127.0.0.1:6379> setex ttlKey 30 "hello" # 设置 30 秒后过期

OK

127.0.0.1:6379> ttl ttlKey # 剩余过期时间

(integer) 25

127.0.0.1:6379> ttl ttlKey # 剩余过期时间

(integer) 20

127.0.0.1:6379> ttl ttlKey # 返回 -2 代表已经过期

(integer) -2

127.0.0.1:6379> psetex ttlkey 10000 hello # 设置 10 秒后过期

OK

127.0.0.1:6379> ttl ttlkey

(integer) 3

字符串截取和追加操作

127.0.0.1:6379> getrange name 0 2 # 截取字符串返回,没有修改实际值

"nic"

127.0.0.1:6379> setrange name 1 oo # 替换字符,从下标1开始替换oo 2个字符

(integer) 4

127.0.0.1:6379> get name

"nook"

127.0.0.1:6379> append name xxx # 追加字符,返回新字符长度

(integer) 7

127.0.0.1:6379> get name

"nookxxx"

自增、自减

127.0.0.1:6379> set views 0

OK

127.0.0.1:6379> get views

"0"

127.0.0.1:6379> incr views # 自增 1

(integer) 1

127.0.0.1:6379> get views

"1"

127.0.0.1:6379> decr views # 自减 1

(integer) 0

127.0.0.1:6379> decr views

(integer) -1

127.0.0.1:6379> get views

"-1"

127.0.0.1:6379> incrby views 10 # 设置步长、自增 10

(integer) 9

127.0.0.1:6379> decrby views 5 # 设置步长、自减 5

(integer) 4

3、String 的使用场景

- 分布式服务的验证码

- 计数器,发号器

- 订单重复提交令牌(也可以限制登录次数)

- 热点商品卡片(序列化Json对象存储)

- 分布式锁

- 可以当自增主键,具有原子性

4、注意事项

- 表示运行结果是否成功

- (integer) 0: false 失败

- (integer) 1: true 成功、或者 1个

- (integer) 3: 3个

- (nil):等同于null,数据未获取到

- Value 最大值为 512M

- Value 数值计算最大范围( Java中的long的最大值):9223372036854775807

- key 名设定约定一般可以使用2种:

- 表名:主键名:主键值。例:

order:id:8239303=》储存一个json字符串 - 表名:主键名:主键值:字段名。例:

order:id:8629303:name=》储存一个对象的一个字段值

- 表名:主键名:主键值。例:

3、Hash(哈希)

1、Hash 类型介绍

Hash也是K-V形式的,但是value是一个map,Hash特别适合用于存储对象,类似与Java的Map<String,Map<String,Object>>

2、命令和示例

| 命令 | 描述 |

|---|---|

| HSET key field value | 将哈希表 key 中的字段 field 的值设为 value |

| HGET key field | 获取存储在哈希表中指定字段的值 |

| HMSET key field1 value1 [field2 value2] | 同时将多个 field-value (域-值)对设置到哈希表 key 中 |

| HMGET key field1 [field2] | 获取所有给定字段的值 |

| HKEYS key | 获取所有哈希表中的字段 |

| HVALS key | 获取哈希表中所有值 |

| HGETALL key | 获取在哈希表中指定 key 的所有字段和值 |

| HLEN key | 获取哈希表中字段的数量 |

| HEXISTS key field | 查看哈希表 key 中,指定的字段是否存在 |

| HSETNX key field value | 只有在字段 field 不存在时,设置哈希表字段的值 |

| HINCRBY key field increment | 为哈希表 key 中指定字段的整数值加上增量 increment |

| HINCRBYFLOAT key field increment | 为哈希表 key 中指定字段的浮点数值加上增量 increment |

| HSCAN key cursor [MATCH pattern] [COUNT count] | 迭代哈希表中的键值对 |

| HDEL key field1 [field2] | 删除一个或多个哈希表字段 |

赋值、取值、只获取字段名或字段值、判断字段是否存在、获取所有字段、获取字段数量

127.0.0.1:6379> hset myhash field xxx # set 1个 key-value

(integer) 1

127.0.0.1:6379> hget myhash field # 获取myhash 1个字段值

"xxx"

127.0.0.1:6379> hmset myhash field1 hello field2 world # set 多个 key-value

OK

127.0.0.1:6379> hmget myhash field field1 field2 # 获取myhash多个字段值

1) "xxx"

2) "hello"

3) "world"

127.0.0.1:6379> hkeys myhash # 获取全部myhash中所有字段key

1) "field"

2) "field1"

3) "field2"

127.0.0.1:6379> hvals myhash # 获取全部myhash中所有val

1) "xxx"

2) "hello"

3) "world"

127.0.0.1:6379> hgetall myhash # 获取mybash中全部的数据

1) "field"

2) "xxx"

3) "field1"

4) "hello"

5) "field2"

6) "world"

127.0.0.1:6379> hlen myhash # 获取myhass中字段的数量

(integer) 3

127.0.0.1:6379> hexists myhash field # 查看myhash指定的字段是否存在

(integer) 1

127.0.0.1:6379> hexists myhash field4 # 查看myhash指定的字段是否存在

(integer) 0

127.0.0.1:6379>

127.0.0.1:6379> hsetnx myhash field nihao # myhash中field不存在才可以设值

(integer) 0

hash 数字自增操作

127.0.0.1:6379> hset myhash field3 5

(integer) 1

127.0.0.1:6379> hincrby myhash field3 1 # 指定增量

(integer) 6

127.0.0.1:6379> hincrby myhash field3 -1 # 自减

(integer) 5

删除指定字段 field:

127.0.0.1:6379> hdel myhash field1 # 删除指定的key,对应的value也就没有了

(integer) 1

127.0.0.1:6379> hgetall myhash

1) "field"

2) "xxx"

3) "field2"

4) "world"

127.0.0.1:6379>

3、hash 使用场景

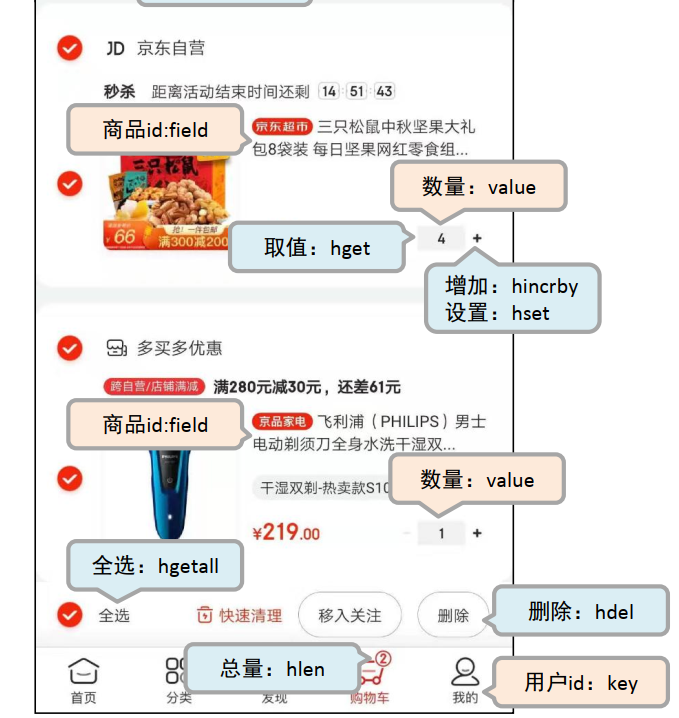

- 购物车

- 双11商品抢购

- 用户个人信息

- 商品详情

1、购物车

解决方案

- 以客户id作为key,每位客户创建一个hash存储结构存储对应的购物车信息

- 将商品编号作为field,购买数量作为value进行存储

- 添加商品:追加全新的field与value

- 浏览:遍历hash

- 更改数量:自增/自减,设置value值

- 删除商品:删除field

- 清空:删除key

2、双11商品抢购

解决方案:

- 以商家id作为key

- 将参与抢购的商品id作为field

- 将参与抢购的商品数量作为对应的value

- 抢购时使用降值的方式控制产品数量

4、hash 类型数据操作的注意事项

- hash 类型下的value只能存储字符串,不允许存储其他数据类型,不存在嵌套现象。如果数据未获取到,对应的值为( nil)hash 类型数据操作的注意事项

- 每个 hash 可以存储 2的32次方- 1个键值对(40多亿)

- hash 类型十分贴近对象的数据存储形式,并且可以灵活添加删除对象属性。但hash设计初衷不是为了存储大量对象而设计的,切记不可滥用,更不可以将hash 作为对象列表使用

- hgetall 操作可以获取全部属性,如果内部field过多,遍历整体数据效率就很会低,有可能成为数据访问瓶颈

4、List(列表)

1、List 列表介绍

字符串列表,按照插入顺序排序。双向链表,插入删除时间复杂度O(1)快,查找为O(n)慢。你可以添加一个元素到列表的头部(左边)或者尾部(右边),它的底层实际上是个链表。list列表有两个特点:有序和可以重复。

2、命令和示例

| 命令 | 描述 |

|---|---|

| LPUSH key value1 [value2] | 将一个或多个值插入到列表头部 |

| RPUSH key value1 [value2] | 将一个或多个值插入到列表尾部 |

| LPOP key | 移出并获取返回列表的第一个元素 |

| RPOP key | 移除并获取返回列表的最后一个元素 |

| LRANGE key start stop | 获取列表指定范围内的元素,索引从0开始,-1代表最后一个元素 |

| LINDEX key index | 通过索引获取列表中的元素 |

| LLEN key | 获取列表长度 |

| LSET key index value | 通过索引设置(修改)列表元素的值 |

| LREM key count value | 移除列表元素。count>0:从左开始删,count<0:从右开始删,count=0,删除所有value |

| LINSERT key BEFORE|AFTER pivot value | 在列表的(只会在第一个)指定元素前或者后插入元素 |

| LTRIM key start stop | 对列表进行修剪(trim)保留指定 key 的值范围内的数据 |

| RPOPLPUSH source destination | 移除并返回列表最后一个元素,并将该元素添加到另一个列表 |

| LPUSHX key value | 将一个值插入到已存在的列表头部 |

| RPUSHX key value | 为已存在的列表添加值 |

| BLPOP key1 [key2] timeout | 移除并获取列表第一个元素, 列表为空会阻塞列表直到等待超时或发现可弹出元素为止 |

| BRPOP key1 [key2] timeout | 移除并获取列表最后一个元素, 列表为空会阻塞列表直到等待超时或发现可弹出元素为止 |

| BRPOPLPUSH source destination timeout | 移除并返回列表最后1个值,并将该值添加到另1个列表,列表为空会阻塞直到等待超时或发现可弹出元素为止 |

在 Redis 中可以把 list 用作栈、队列、阻塞队列。

向列表两端添加元素、查看列表

127.0.0.1:6379> lpush list 1 # 向列表左边(头部)添加元素

(integer) 1

127.0.0.1:6379> lpush list 2

(integer) 2

127.0.0.1:6379> lpush list 3

(integer) 3

127.0.0.1:6379> lrange list 0 -1 # 查看全部元素

1) "3"

2) "2"

3) "1"

127.0.0.1:6379> lrange list 0 1 # 通过区间获取值

1) "3"

2) "2"

127.0.0.1:6379> rpush list 0 # 向列表右边(尾部)添加元素

(integer) 4

127.0.0.1:6379> lrange list 0 -1

1) "3"

2) "2"

3) "1"

4) "0"

从列表两端弹出元素弹出 pop

127.0.0.1:6379> lrange list 0 -1 # 查看list全部元素

1) "!"

2) "world"

3) "world"

4) "hello"

127.0.0.1:6379> lpop list # 移除list左边(头部)第一个元素

"!"

127.0.0.1:6379> lrange list 0 -1

1) "world"

2) "world"

3) "hello"

127.0.0.1:6379> rpop list # 移除list右边(尾部)第一个元素

"hello"

127.0.0.1:6379> lrange list 0 -1 # 查看list全部元素

1) "world"

2) "world"

获取/设置指定索引的元素值:lindex:获取指定索引的元素值。lset:将列表中指定下标的值替换为其他值。

127.0.0.1:6379> lrange list 0 -1

1) "hjk"

2) "world"

3) "world"

127.0.0.1:6379> lindex list 1 # 通过下标获取list中的某一个值

"world"

127.0.0.1:6379> lindex list 0

"hjk"

127.0.0.1:6379> exists list # 判断这个列表是否存在

(integer) 0

127.0.0.1:6379> lset list 0 item # 如果list不存在的话,更新会报错

(error) ERR no such key

127.0.0.1:6379> lpush list value1

(integer) 1

127.0.0.1:6379> lrange list 0 0

1) "value1"

127.0.0.1:6379> lset list 0 item # 如果list存在并且下标也存在,更新当前下标的值

OK

127.0.0.1:6379> lset list 1 other # 如果list存在当时下标不存在的话,更新会报错

(error) ERR index out of range

127.0.0.1:6379>

向列表中插入元素:linsert(将某个 value 插入到列表中某个元素的前面 或者 后面)

127.0.0.1:6379> lrange mylist 0 -1

1) "hello1"

2) "hello2"

127.0.0.1:6379> linsert mylist before "hello2" hello

(integer) 3

127.0.0.1:6379> lrange mylist 0 -1

1) "hello1"

2) "hello"

3) "hello2"

127.0.0.1:6379> linsert mylist after "hello2" hello

(integer) 4

127.0.0.1:6379> lrange mylist 0 -1

1) "hello1"

2) "hello"

3) "hello2"

4) "hello"

获取列表中元素的个数,llen 查询长度

127.0.0.1:6379> llen list

(integer) 3

删除列表中指定个数的值:当 count>0:从左开始删,count<0:从右开始删,count=0,删除所有value

127.0.0.1:6379> lrange list 0 -1

1) "hjk"

2) "world"

3) "world"

127.0.0.1:6379> lrem list 1 world # 移除list集合中指定个数的value,精确匹配

(integer) 1

127.0.0.1:6379> lrange list 0 -1

1) "hjk"

2) "world"

127.0.0.1:6379> lpush list hjk

(integer) 3

127.0.0.1:6379> lrange list 0 -1

1) "hjk"

2) "hjk"

3) "world"

127.0.0.1:6379> lrem list 2 hjk

(integer) 2

127.0.0.1:6379> lrange list 0 -1

1) "world"

127.0.0.1:6379>

trim 截断:

127.0.0.1:6379> lrange mylist 0 -1

1) "hello1"

2) "hello2"

3) "hello3"

4) "hello4"

127.0.0.1:6379> ltrim mylist 1 2 # 通过下标截取指定长度,这个list已经被破坏了,截断之后只剩下截断后的元素

OK

127.0.0.1:6379> lrange mylist 0 -1

1) "hello2"

2) "hello3"

127.0.0.1:6379>

rpoplpush :移除列表的最后一个元素,将他移动到新的列表中

127.0.0.1:6379> lrange mylist 0 -1

1) "hello1"

2) "hello2"

3) "hello3"

127.0.0.1:6379> rpoplpush mylist myotherlist # 移除列表的最后一个元素,将他移动到新的列表中。

"hello3"

127.0.0.1:6379> lrange mylist 0 -1 # 查看原来的列表

1) "hello1"

2) "hello2"

127.0.0.1:6379> lrange myotherlist 0 -1 # 查看目标列表中,确实存在该值

1) "hello3"

3、列表应用场景

- 简单队列

- 最新评论列表、微博中个人用户的关注列表需要按照用户的关注顺序进行展示,粉丝列表需要将最近关注的粉丝列在前面

- 微信朋友圈点赞,要求按照点赞顺序显示点赞好友信息。如果取消点赞,移除对应好友信息(rpush:点赞。lrem:取消)

- 非实时排行榜:定时计算榜单,如手机日销榜单

4、注意事项

- 存储的都是string字符串类型,一个列表最多可以包含 232 - 1 个元素 (4294967295, 每个列表不超过40亿个元素)

- 支持分页操作,高并发项目中,第一页数据都是来源list,第二页和更多信息则是通过数据库加载

- list具有索引的概念,但是操作数据时通常以队列的形式进行入队出队操作,或以栈的形式进行入栈出栈操作

- 获取全部数据操作结束索引设置为 -1

- list 实际上是一个链表,前后都可以插入,在两边插入或者改动值,效率最高。

- 如果key不存在,创建新的链表,如果移除了所有的值,空链表,也代表不存在

5、Set (集合)

1、Set 集合介绍

Set 集合是 String 类型的无序集合。相对于 list 列表,Set 集合也有两个特点:无序、不可重复。

2、命令和示例

| 命令 | 描述 |

|---|---|

| SADD key member1 [member2] | 向集合添加一个或多个元素 |

| SREM key member1 [member2] | 移除集合中一个或多个元素 |

| SMEMBERS key | 返回集合中的所有成员 |

| SPOP key | 移除并获取集合中的一个随机元素 |

| SRANDMEMBER key [count] | 获取集合中一个或多个随机元素 |

| SISMEMBER key member | 判断 member 元素是否是集合 key 的成员 |

| SCARD key | 获取集合的成员数 |

| SDIFF key1 [key2] | 返回给定集合的差集,属于key1且不属于key2的元素 |

| SINTER key1 [key2] | 返回给定集合的交集,既属于key1又属于key2的元素 |

| SUNION key1 [key2] | 返回给定集合的并集,key1和key2集合合并 |

| SDIFFSTORE destination key1 [key2] | 返回给定所有集合的差集并存储在 destination 中 |

| SINTERSTORE destination key1 [key2] | 返回给定所有集合的交集并存储在 destination 中 |

| SUNIONSTORE destination key1 [key2] | 所有给定集合的并集存储在 destination 集合中 |

| SMOVE source destination member | 将 member 从 source 集合移到 destination 集合 |

| SSCAN key cursor [MATCH pattern] [COUNT count] | 迭代集合中的元素 |

添加和删除集合元素、获取集合中的所有元素

127.0.0.1:6379> sadd myset "hello1" "hello2" "hello3" # 向集合中添加元素

(integer) 3

127.0.0.1:6379> sadd myset "hello1" "hello2" "hello3" # 向集合中添加重复元素

(integer) 0

127.0.0.1:6379> smembers myset # 查看指定Set的所有值

1) "hello3"

2) "hello1"

3) "hello2"

127.0.0.1:6379> srem myset hello3 # 移除集合中的hello3元素

(integer) 1

127.0.0.1:6379> smembers myset # 查看指定Set的所有值

1) "hello2"

2) "hello1"

判断元素是否在集合中、获取集合中的元素个数

127.0.0.1:6379> sadd myset "hello1" "hello2" "hello3" # 向集合中添加元素

(integer) 3

127.0.0.1:6379> sismember myset hello1 # 判断某一个值是不是在set中

(integer) 1

127.0.0.1:6379> sismember myset hellox # 判断某一个值是不是在set中

(integer) 0

127.0.0.1:6379> scard myset # 获取集合中的个数

(integer) 3

从集合中随机弹出或者或获取元素

127.0.0.1:6379> sadd myset "hello1" "hello2" "hello3" # 向集合中添加元素

(integer) 3

127.0.0.1:6379> srandmember myset # 随机抽取一个元素

"hello2"

127.0.0.1:6379> srandmember myset # 随机抽取一个元素

"hello3"

127.0.0.1:6379> srandmember myset 2 # 随机抽取指定个数的元素

1) "hello1"

2) "hello2"

127.0.0.1:6379> spop myset # 随机删除并获取该元素

1) "hello2"

127.0.0.1:6379> smembers myset # 查看指定Set的所有值

1) "hello3"

2) "hello1"

集合的差集运算 A-B:SDIFF :返回集合差集。SDIFFSTOR :返回差集并放入另一个集合

127.0.0.1:6379> sadd setA 1 2 3 4 5 6 # 初始化集合A

(integer) 6

127.0.0.1:6379> sadd setB 4 5 6 7 8 9 # 初始化集合B

(integer) 6

127.0.0.1:6379> sdiff setA setB # 查询集合A和B的差集

1) "1"

2) "2"

3) "3"

127.0.0.1:6379> sdiffstore setAB setA setB # 查询集合A和B的差集并存入另一个集合

(integer) 3

127.0.0.1:6379> smembers setAB

1) "1"

2) "2"

3) "3"

集合的交集运算 A ∩ B:SINTER:返回集合交集。SINTERSTORE:返回交集并放入另一个集合

127.0.0.1:6379> sadd setA 1 2 3 4 5 6 # 初始化集合A

(integer) 6

127.0.0.1:6379> sadd setB 4 5 6 7 8 9 # 初始化集合B

(integer) 6

127.0.0.1:6379> sinter setA setB # 查询集合A和B的交集

1) "4"

2) "5"

3) "6"

127.0.0.1:6379> sinterstore setAB setA setB # 查询集合A和B的交集并存入另一个集合

(integer) 3

127.0.0.1:6379> smembers setAB

1) "4"

2) "5"

3) "6"

集合的并集运算 A∪B:SUNION:返回集合并集。SUNIONSTORE:返回并集并放入另一个集合

127.0.0.1:6379> sadd setA 1 2 3 4 5 6 # 初始化集合A

(integer) 6

127.0.0.1:6379> sadd setB 4 5 6 7 8 9 # 初始化集合B

(integer) 6

127.0.0.1:6379> sunion setA setB # 查询集合A和B的并集

1) "1"

2) "2"

3) "3"

4) "4"

5) "5"

6) "6"

7) "7"

8) "8"

9) "9"

127.0.0.1:6379> sunionstore setAB setA setB # 查询集合A和B的并集并存入另一个集合

(integer) 9

127.0.0.1:6379> smembers setAB

1) "1"

2) "2"

3) "3"

4) "4"

5) "5"

6) "6"

7) "7"

8) "8"

9) "9"

3、应用场景

- 数据去重

- 社交应用关注、粉丝、共同好友

- 统计网站的PV、UV、IP

- 大数据里面的用户画像标签集合

4、注意事项

- 集合是通过哈希表实现的

- 添加已经存在于集合的成员元素将被忽略

6、Sorted Set(有序集合)

1、Sorted Set 有序集合介绍

Sorted Set是字符串的集合,不允许重复的成员出现在一个Set中。Sorted Set是有序集合,在Sorted Set内部的每一个元素,都有一个score与value关联。Sort Set的有序性就是通过score保证的。Sorted Set属于Set,具有Set的全部特性,同时Sorted Set拥有Set的额外的一个特性Sort。尽管Set的value不允许重复,但是score却是允许重复的。

在Set中增加、删除、更新元素是一个资源消耗非常小的操作。因为Sorted Set是有序的,所以即使访问Set的中部的元素,依然具有很高的效率。这是Redis的优势,其他数据库中想要实现这一点,比较困难。

2、命令和示例

| 命令 | 描述 |

|---|---|

| ZADD key score1 member1 [score2 member2] | 向有序集合添加一个或多个成员,或者更新已存在成员的分数 |

| ZREM key member [member…] | 移除有序集合中的一个或多个成员 |

| ZRANGE key start stop [WITHSCORES] | 通过索引返回有序集合指定区间内的成员(分数从低到高) |

| ZREVRANGE key start stop [WITHSCORES] | 通过索引返回有序集中指定区间内的成员(分数从高到低) |

| ZRANK key member | 返回有序集合中指定成员的排名索引(分数从低到高) |

| ZREVRANK key member | 返回有序集合中指定成员的排名索引(分数从高到低) |

| ZSCORE key member | 返回集合中指定成员的分数值 |

| ZCARD key | 获取有序集合的成员个数 |

| ZCOUNT key min max | 计算在有序集合中指定区间分数的成员个数 |

| ZLEXCOUNT key min max | 在有序集合中计算指定字典区间内成员数量 |

| ZINCRBY key increment member | 有序集合中对指定成员的分数加上增量 increment |

| ZRANGEBYSCORE key min max [WITHSCORES] [LIMIT] | 返回有序集合指定分数区间内的成员,分数从低到高排序 |

| ZREVRANGEBYSCORE key max min [WITHSCORES] [LIMIT] | 返回有序集中指定分数区间内的成员,分数从高到低排序 |

| ZREMRANGEBYRANK key start stop | 移除有序集合中给定的排名区间的所有成员 |

| ZREMRANGEBYSCORE key min max | 移除有序集合中给定的分数区间的所有成员 |

| 下面命令为不常用的,了解即可。 | |

| ZREMRANGEBYLEX key min max | 移除有序集合中给定的字典区间的所有成员 |

| ZINTERSTORE destination numkeys key [key…] | 计算给定的一个或多个有序集的交集,并存储在新的集合key 中 |

| ZUNIONSTORE destination numkeys key [key …] | 计算给定的一个或多个有序集的并集,并存储在新的集合key 中 |

| ZRANGEBYLEX key min max [LIMIT offset count] | 计算有序集合中指定成员之间的成员数量 |

| ZREVRANGEBYLEX key min max [LIMIT offset count] | 计算有序集合中指定成员之间的成员数量,倒序返回 |

| ZSCAN key cursor [MATCH pattern] [COUNT count] | 迭代有序集合中的元素(包括元素成员和元素分值) |

增加和删除有序集合元素、正序和倒序查询集合成员和分数、正序和倒序获取指定成员的排名(索引)

127.0.0.1:6379> zadd myzset 30 xhong 20 xming 50 xzhang 10 xli # 初始化有序集合

(integer) 4

127.0.0.1:6379> zrange myzset 0 -1 # 正序排序后显示有序集合成员

1) "xli"

2) "xming"

3) "xhong"

4) "xzhang"

127.0.0.1:6379> zrange myzset 0 -1 withscores # 正序排序后显示有序集合成员和分数

1) "xli"

2) "10"

3) "xming"

4) "20"

5) "xhong"

6) "30"

7) "xzhang"

8) "50"

127.0.0.1:6379> zrank myzset xhong # 正序排序后查询指定成员排名(索引从0开始)

(integer) 2

127.0.0.1:6379> zrevrange myzset 0 -1 # 倒序排序后显示有序集合成员

1) "xzhang"

2) "xhong"

3) "xming"

4) "xli"

127.0.0.1:6379> zrevrange myzset 0 -1 withscores # 倒序排序后显示有序集合成员和分数

1) "xzhang"

2) "50"

3) "xhong"

4) "30"

5) "xming"

6) "20"

7) "xli"

8) "10"

127.0.0.1:6379> zrevrank myzset xhong # 倒序排序后查询指定成员排名(索引从0开始)

(integer) 1

127.0.0.1:6379> zrem myzset xli # 删除有序集合指定成员xli

(integer) 1

获取指定成员分数、获取集合的成员个数、获取集合中指定区间分数的成员数

127.0.0.1:6379> zadd myzset 30 xhong 20 xming 50 xzhang 10 xli # 初始化有序集合

(integer) 4

127.0.0.1:6379> ZSCORE myzset xli # 获取集合中成员xli的分数

"10"

127.0.0.1:6379> zcard myzset # 获取有序集合的成员数

(integer) 4

127.0.0.1:6379> zcount myzset 20 30 # 获取集合中指定区间分数的成员个数

(integer) 2

给某个元素增加分数:ZINCRBY key increment member

127.0.0.1:6379> zincrby myzset 1 D # 给成员D分数加1

"91"

127.0.0.1:6379> zincrby myzset 2 D # 给成员D分数加2

"93"

按正序(分数从低到高)或者倒序(分数从高到低)返回集合指定分数区间内的成员和分数

127.0.0.1:6379> zadd myzset 30 xhong 20 xming 50 xzhang 10 xli # 初始化有序集合

(integer) 4

127.0.0.1:6379> zrangebyscore myzset -inf +inf # 正序显示最低分到最高分间的成员。min和max可以是-inf和+inf

1) "xli"

2) "xming"

3) "xhong"

4) "xzhang"

127.0.0.1:6379> zrangebyscore myzset -inf +inf withscores # 正序显示最低分到最高分间的成员

1) "xli"

2) "10"

3) "xming"

4) "20"

5) "xhong"

6) "30"

7) "xzhang"

8) "50"

127.0.0.1:6379> zrangebyscore myzset 15 35 # 正序显示分数为15到35之间的成员

1) "xming"

2) "xhong"

127.0.0.1:6379> zrangebyscore myzset 15 35 withscores # 正序显示分数为15到35之间的成员和分数

1) "xming"

2) "20"

3) "xhong"

4) "30"

127.0.0.1:6379> zrangebyscore myzset -inf 35 withscores # 正序显示分数为小于35分的成员和分数

1) "xli"

2) "10"

3) "xming"

4) "20"

5) "xhong"

6) "30"

127.0.0.1:6379> zrevrangebyscore myzset +inf -inf # 倒序显示最高分到最低分间的成员。min和max可以是-inf和+inf

1) "xzhang"

2) "xhong"

3) "xming"

4) "xli"

127.0.0.1:6379> zrevrangebyscore myzset +inf -inf withscores # 倒序序显示最高分到最低分间的成员和分数

1) "xzhang"

2) "50"

3) "xhong"

4) "30"

5) "xming"

6) "20"

7) "xli"

8) "10"

127.0.0.1:6379> zrevrangebyscore myzset 35 15 # 倒序显示分数为35到15之间的成员

1) "xhong"

2) "xming"

127.0.0.1:6379> zrevrangebyscore myzset 35 15 withscores # 倒序显示分数为35到15之间的成员和分数

1) "xhong"

2) "30"

3) "xming"

4) "20"

按照排名范围删除元素、按照分数范围删除元素

127.0.0.1:6379> zadd myzset 30 xhong 20 xming 50 xzhang 10 xli # 初始化有序集合

127.0.0.1:6379> zrange myzset 0 -1 # 先查询有序集合

1) "xli"

2) "xming"

3) "xhong"

4) "xzhang"

127.0.0.1:6379> zremrangebyrank myzset 0 2 # 按照正序排名删除前3名

(integer) 3

127.0.0.1:6379> zrange myzset 0 -1 # 查询结果

1) "xzhang"

127.0.0.1:6379> zadd myzset 30 xhong 20 xming 50 xzhang 10 xli # 初始化有序集合

127.0.0.1:6379> zrange myzset 0 -1 withscores # 先查询有序集合

1) "xli"

2) "10"

3) "xming"

4) "20"

5) "xhong"

6) "30"

7) "xzhang"

8) "50"

127.0.0.1:6379> zremrangebyscore myzset 20 30 # 按照正序排名删除20分到30分的数据

(integer) 2

127.0.0.1:6379> zrange myzset 0 -1 withscores # 查询结果

1) "xli"

2) "10"

3) "xzhang"

4) "50"

3、应用场景

- 实时排行榜:商品热销榜、体育类应用热门球队、积分榜、各类资源网站TOP10

- 优先级任务、队列

- 朋友圈文章点赞-取消,逻辑:用户只能点赞或取消。统计一篇文章被点赞了多少次,可以直接取里面有多少个成员

- 网站会定期开启投票、讨论,限时进行,逾期作废。如何有效管理此类过期信息

4、注意事项

- 底层使用到了Ziplist压缩列表和“跳跃表”两种存储结构

- score 保存的数据存储空间是64位,如果是整数范围是-9007199254740992~9007199254740992

- score 保存的数据也可以是一个双精度的double值,基于双精度浮点数的特征,可能会丢失精度,使用时候要慎重

- sorted_set 底层存储还是基于 set 结构的,因此数据不能重复,如果重复添加相同的数据,score 值将被反复覆盖,保留最后一次修改的结果

Redis 三种特殊数据类型

中文网可查看命令: http://www.redis.cn/commands.html

1、Geospatial

Redis 中文网站文档: https://www.redis.net.cn/order/3687.html

经纬度数据模拟网站: http://www.jsons.cn/lngcode/

Redis 在 3.2 推出 Geo 类型,该功能可以推算出地理位置信息,两地之间的距离。

1、geoadd

geoadd 添加地理位置

规则:两极无法直接添加,一般会下载城市数据,直接通过 Java 程序一次性导入。

有效的经度从 -180 度到 180 度。有效的纬度从 -85.05112878 度到 85.05112878 度。当坐标位置超出指定范围时,该命令将会返回一个错误。

127.0.0.1:6379> geoadd china:city 39.90 116.40 beijin

(error) ERR invalid longitude,latitude pair 39.900000,116.400000

添加一些模拟数据:

127.0.0.1:6379> geoadd china:city 116.40 39.90 beijing

(integer) 1

127.0.0.1:6379> geoadd china:city 121.47 31.23 shanghai

(integer) 1

127.0.0.1:6379> geoadd china:city 106.50 29.53 chongqing 114.05 22.52 shengzhen

(integer) 2

127.0.0.1:6379> geoadd china:city 120.16 30.24 hangzhou 108.96 34.26 xian

(integer) 2

127.0.0.1:6379>

2、geopos

geopos 获得当前定位坐标值

127.0.0.1:6379> geopos china:city beijing # 获得指定城市的经纬度

1) 1) "116.39999896287918091"

2) "39.90000009167092543"

127.0.0.1:6379> geopos china:city shanghai

1) 1) "121.47000163793563843"

2) "31.22999903975783553"

127.0.0.1:6379>

3、geodist

geodist 获取两个位置之间的距离

单位:

- m 表示单位为米

- km 表示单位为千米

- mi 表示单位为英里

- ft 表示单位为英尺

如果用户没有显式地指定单位参数, 那么 GEODIST 默认使用米作为单位。

127.0.0.1:6379> geodist china:city beijing shanghai km # 查看北京和上海直接的直线距离

"1067.3788"

127.0.0.1:6379> geodist china:city beijing chongqing km # 查看北京和重庆直接的直线距离

"1464.0708"

127.0.0.1:6379>

4、geohash

简单说:Geohash可以获取元素的经纬度编码字符串,它是Base32编码。 可以使用这个编码值去:http://geohash.org/${hash}中进行直接定位,它是Geohash的标准编码值。

该命令将返回11个字符的Geohash字符串,所以没有精度Geohash,损失相比,使用内部52位表示。返回的geohashes具有以下特性:

- 他们可以缩短从右边的字符。它将失去精度,但仍将指向同一地区。

- 它可以在

geohash.org网站使用,网址http://geohash.org/<geohash-string>。查询例子:http://geohash.org/sqdtr74hyu0 - 与类似的前缀字符串是附近,但相反的是不正确的,这是可能的,用不同的前缀字符串附近

返回值:一个数组, 数组的每个项都是一个 geohash 。 命令返回的 geohash 的位置与用户给定的位置元素的位置一一对应

redis> GEOADD Sicily 13.361389 38.115556 "Palermo" 15.087269 37.502669 "Catania"

(integer) 2

redis> GEOHASH Sicily Palermo Catania

1) "sqc8b49rny0"

2) "sqdtr74hyu0"

redis>

5、georedius

georedius 以给定的经纬度为中心,找出某一半径内的元素

获得所有附近的人的地址,定位!通过半径来查询!

获得指定数量的人,200。所有数据应该都录入:china:city ,才会让结果更加请求!

# 以110, 30 这个点为中心,寻找方圆 1000km 的城市

127.0.0.1:6379> georadius china:city 110 30 1000 km

1) "chongqing"

2) "xian"

3) "shengzhen"

4) "hangzhou"

127.0.0.1:6379> georadius china:city 110 30 500 km

1) "chongqing"

2) "xian"

127.0.0.1:6379> georadius china:city 110 30 500 km withcoord # 显示他人的定位信息

1) 1) "chongqing"

2) 1) "106.49999767541885376"

2) "29.52999957900659211"

2) 1) "xian"

2) 1) "108.96000176668167114"

2) "34.25999964418929977"

127.0.0.1:6379>

127.0.0.1:6379> georadius china:city 110 30 500 km withdist # 显示到中心点的距离

1) 1) "chongqing"

2) "341.9374"

2) 1) "xian"

2) "483.8340"

127.0.0.1:6379> georadius china:city 110 30 500 km withdist withcoord count 1 # 指定数量

1) 1) "chongqing"

2) "341.9374"

3) 1) "106.49999767541885376"

2) "29.52999957900659211"

127.0.0.1:6379> georadius china:city 110 30 500 km withdist withcoord count 2

1) 1) "chongqing"

2) "341.9374"

3) 1) "106.49999767541885376"

2) "29.52999957900659211"

2) 1) "xian"

2) "483.8340"

3) 1) "108.96000176668167114"

2) "34.25999964418929977"

127.0.0.1:6379>

6、georadiusbymember

GEORADIUSBYMEMBER 找出位于指定元素周围的其他元素

# 找出位于指定元素周围的其他元素!

127.0.0.1:6379> georadiusbymember china:city shanghai 1000 km

1) "hangzhou"

2) "shanghai"

127.0.0.1:6379> GEORADIUSBYMEMBER china:city shanghai 400 km

1) "hangzhou"

2) "shanghai"

geo 底层实现原理其实就是 zset ,可以使用 zset 命令操作 geo

127.0.0.1:6379> zrange china:city 0 -1 # 查看地图中全部的元素

1) "chongqing"

2) "xian"

3) "shengzhen"

4) "hangzhou"

5) "shanghai"

6) "beijing"

127.0.0.1:6379> zrem china:city beijing # 删除一个指定元素

(integer) 1

127.0.0.1:6379> zrange china:city 0 -1

1) "chongqing"

2) "xian"

3) "shengzhen"

4) "hangzhou"

5) "shanghai"

2、Hyperloglog

思考一个常见的业务问题:

如果你负责开发维护一个大型的网站,有一天老板找产品经理要网站每个网页每天的 UV 数据,然后让你来开发这个统计模块,你会如何实现?如果统计 PV 那非常好办,给每个网页一个独立的 Redis 计数器就可以了,这个计数器的 key 后缀加上当天的日期。这样来一个请求,incrby 一次,最终就可以统计出所有的 PV 数据。

但是 UV 不一样,它要去重,同一个用户一天之内的多次访问请求只能计数一次。这就要求每一个网页请求都需要带上用户的 ID,无论是登陆用户还是未登陆用户都需要一个唯一ID 来标识。你也许已经想到了一个简单的方案,那就是为每一个页面一个独立的 set 集合来存储所有当天访问过此页面的用户 ID。当一个请求过来时,我们使用 sadd 将用户 ID 塞进去就可以了。通过 scard 可以取出这个集合的大小,这个数字就是这个页面的 UV 数据。没错,这是一个非常简单的方案。

但是,如果你的页面访问量非常大,比如一个爆款页面几千万的 UV,你需要一个很大的 set 集合来统计,这就非常浪费空间。如果这样的页面很多,那所需要的存储空间是惊人的。为这样一个去重功能就耗费这样多的存储空间,值得么?其实老板需要的数据又不需要太精确,105w 和 106w 这两个数字对于老板们来说并没有多大区别,So,有没有更好的解决方案呢?

Redis 提供了 HyperLogLog 数据结构就是用来解决这种统计问题的。HyperLogLog 提供不精确的去重计数方案,虽然不精确但是也不是非常不精确,标准误差是 0.81%,这样的精确度已经可以满足上面的 UV 统计需求了。HyperLogLog 数据结构是 Redis 的高级数据结构,它非常有用,但是令人感到意外的是,使用过它的人非常少。

1、PV(Page View:访问量)具体是指网站的是页面浏览量或者点击量。用户每次对网站的访问均被记录,用户对同一页面的多次访问,访问量累计。

2、UV(Unique visitor:独立访客)是指通过互联网访问、浏览这个网页的自然人。访问的一个电脑客户端为一个访客,一天内同一个访客仅被计算一次。

Hyperloglog 介绍和说明:

- Redis 2.8.9 版本更新了 Hyperloglog 数据结构

- Hyperloglog 用于进行基数统计,不是集合不保存数据,只记录数量而不是具体数据(基数:数学上集合的元素个数,是不能重复的)

- hyperloglog 的优点是占用内存小,并且是固定的。存储 2^64 个不同元素的基数,只需要 12 KB 的空间。但是也可能有 0.81% 的错误率

- 核心是基数估算算法,最终数值存在一定误差,基数估计的结果是一个带有 0.81% 标准错误的近似值

- 耗空间极小,每个 hyperloglog key占用了12K的内存用于标记基数

- pfadd 命令不是一次性分配12K内存使用,会随着基数的增加内存逐渐增大

- pfmerge 命令合并后占用的存储空间为12K,无论合并之前数据量多少

这个数据结构常用于统计网站的 UV。传统的方式是使用 set 保存用户的ID,然后统计 set 中元素的数量作为判断标准。但是这种方式保存了大量的用户 ID,ID 一般比较长,占空间,还很麻烦。我们的目的是计数,不是保存数据,所以这样做有弊端。但是如果使用 hyperloglog 就比较合适了。

| 命令 | 描述 |

|---|---|

| pfadd key element [element…] | 添加数据 |

| pfcount key [key…] | 统计数据 |

| pfmerge destkey sourcekey [sourcekey…] | 合并数据 |

127.0.0.1:6379> pfadd mykey1 0 1 2 3 4 5 6 7 8 9 # 创建第一组元素

(integer) 1

127.0.0.1:6379> PFCOUNT mykey1 # 统计 mykey 基数

(integer) 10

127.0.0.1:6379> PFADD mykey2 7 8 9 10 11 12 13 # 创建第二组元素

(integer) 1

127.0.0.1:6379> PFCOUNT mykey2 # 统计 mykey2 基数

(integer) 7

127.0.0.1:6379> PFMERGE mykey3 mykey1 mykey2 # 合并两组 mykey1 mykey2 => mykey3

OK

127.0.0.1:6379> PFCOUNT mykey3 # 统计 mykey3 基数

(integer) 15

注意事项:

HyperLogLog 这个数据结构不是免费的,不是说使用这个数据结构要花钱,它需要占据一定 12k 的存储空间,所以它不适合统计单个用户相关的数据。如果你的用户上亿,可以算算,这个空间成本是非常惊人的。但是相比 set 存储方案,HyperLogLog 所使用的空间那真是可以使用千斤对比四两来形容了。

不过你也不必过于当心,因为 Redis 对 HyperLogLog 的存储进行了优化,在计数比较小时,它的存储空间采用稀疏矩阵存储,空间占用很小,仅仅在计数慢慢变大,稀疏矩阵占用空间渐渐超过了阈值时才会一次性转变成稠密矩阵,才会占用 12k 的空间。

pf 的内存占用为什么是 12k ?

算法中使用了 1024 个桶进行独立计数,不过在 Redis 的 HyperLogLog实现中用到的是 16384 个桶,也就是 2^14,每个桶的 maxbits 需要 6 个 bits 来存储,最大可以表示 maxbits=63,于是总共占用内存就是 2^14 * 6 / 8 = 12k 字节。

3、Bitmap 位图

| 命令 | 描述 |

|---|---|

| GETBIT key offset | 对 key 所储存的字符串值,获取指定偏移量上的位(bit) |

| SETBIT key offset value | 对 key 所储存的字符串值,设置或清除指定偏移量上的位(bit) |

| BITCOUNT key [start end] | 统计字符串被设置为1的 bit 数 |

bitmap 就是通过最小的单位bit来进行0或者1的设置,表示某个元素对应的值或者状态。一个bit的值只能是0或1;也就是说一个bit能存储的最多信息是2。bitmap 常用于统计用户信息比如活跃粉丝和不活跃粉丝、登录和未登录、是否打卡等。

1、这里使用一周打卡的案例说明其用法:

127.0.0.1:6379> setbit sign 0 1 # 周一打卡了

(integer) 0

127.0.0.1:6379> setbit sign 1 0 # 周二未打卡

(integer) 0

127.0.0.1:6379> setbit sign 2 0 # 周三未打卡

(integer) 0

127.0.0.1:6379> setbit sign 3 1 # 周四打卡了

(integer) 0

127.0.0.1:6379> setbit sign 4 1 # 周五打卡了

(integer) 0

127.0.0.1:6379> setbit sign 5 1 # 周六打卡了

(integer) 0

127.0.0.1:6379> setbit sign 6 0 # 周日未打卡

(integer) 0

2、查看某一天是否打卡:

127.0.0.1:6379> GETBIT sign 3

(integer) 1

127.0.0.1:6379> GETBIT sign 6

(integer) 0

3、统计:统计打卡的天数

127.0.0.1:6379> BITCOUNT sign

(integer) 4

Redis 操作命令大全

1、Redis 命令行参数大全

1、服务器启动参数(redis-server)

| 选项 | 说明 |

|---|---|

| -v、–version | 查Redis看版本号 |

| - | 从stdin中读取配置 |

| –port | 指定Redis服务监听的端口 |

| -a | 指定密码 |

| –sentinel | 设置哨兵系统启动 |

| /path | 选择指定的配置文件启动 |

| –test-memory | 检测当前操作系统能否稳定地分配指定容量的内存给 Redis |

| –slaveof | 将当前Redis设置为从库,为他设置主库地址 |

| –masterauth | 如果主库设置了主从密码, 从库需要用该参数指定主从密码 |

| –loglevel | 设置日志等级 |

[root@CentOS7 ~]# /usr/local/redis/bin/redis-server --help

Usage: ./redis-server [/path/to/redis.conf] [options]

./redis-server - (read config from stdin)

./redis-server -v or --version

./redis-server -h or --help

./redis-server --test-memory <megabytes>

Examples:

./redis-server (run the server with default conf)

./redis-server /etc/redis/6379.conf

./redis-server --port 7777

./redis-server --port 7777 --replicaof 127.0.0.1 8888

./redis-server /etc/myredis.conf --loglevel verbose

Sentinel mode:

./redis-server /etc/sentinel.conf --sentinel

2、客户端连接选项(redis-cli)

- 命令方式:

redis-cli -h {host} -p {port} {command},直接得到命令的返回结果,显示在屏幕上 - 交互式命令行方式:

redis-cli -h {host} -p {port},进入交互式命令行

| 选项 | 说明 |

|---|---|

| -h | 指定Redis server地址 |

| -p | 指定Redis server端口号 |

| -s | 指定服务器套接字(覆盖主机名和端口)。 |

| -a | 指定密码 |

| -u | url格式的地址 |

| -r | 将命令重复执行N次 |

| -i | 每隔N秒执行一次命令,必须与-r一起使用。 |

| -n | 选择库号 |

| -x | 代表从标准输入读取数据作为该命令的最后一个参数。 |

| -d | 原始格式中的多块分隔符(默认值: )。 |

| -c | 连接cluster集群结点时用的,此选项可防止moved和ask异常。 |

| –user | 指定登录的用户名,Redis6 ACL 更新的 |

| –pass | 指定登录密码,Redis6 ACL 更新的 |

| –csv | 将数据导出为CSV格式的文件 |

| –scan | 获取服务器所有的键 |

| –pattern | 指定scan获取的key的pattern,正则表达式用于scan命令后过滤. |

| –slave | 当前客户端模拟成当前redis节点的从节点,可用来获取指定redis节点的更新操作 |

| –rdb | 导出rdb文件,保存导到指定的位置 |

| –pipe | 将命令封装成redis通信协议定义的数据格式,批量发送给redis执行。 |

| –pipe-timeout | 设置管道超时时间 |

| –bigkeys | 统计bigkey的分布,使用scan命令对redis的键进行采样,从中找到内存占用比较大的键 |

| –hotkeys | 找出server中热点key |

| –stat | 实时获取redis的统计信息。istat和info相比可以看到一些增加的数据,如:每秒请求数 |

| –raw | 显示格式化的效果 |

| –no-raw | 要求返回原始格式 |

| –eval | 用于执行lua脚本 |

| –latency | 持续采样服务器延迟 |

| –latency-history | 持续采样服务器延迟并每隔(15秒)输出一个记录; 可以使用-i 更改间隔时间 |

| –latency-dist | 使用彩色终端显示一系列延时特征 |

| –intrinsic-latency | 固有延迟,由于操作系统或虚拟机/容器带来的延迟,需要在redis-server的本器上进行测量. |

| –ldb | 与–eval一起使用可以启用Redis Lua调试器 |

| –ldb-sync-mode | 比如–ldb,但是使用了同步Lua调试器, 此模式将阻塞服务器并更改脚本 |

| –lru-test |

3、redis-cli stat 参数说明

| 选项 | 说明 |

|---|---|

| keys | server中key的数量 |

| mem | 键值对的总内存量 |

| clients | 当前连接的总clients数量 |

| blocked | 正在等待执行阻塞命令(BLPOP、BRPOP、BRPOPLPUSH 等等)的客户端数量 |

| requests | 服务器请求总次数 (+1) 截止上次请求增加次数 |

| connections | 服务器连接次数 |

4、redis-cli –help 查看

[root@CentOS7 ~]# /usr/local/redis/bin/redis-cli --help

redis-cli 6.0.6

Usage: redis-cli [OPTIONS] [cmd [arg [arg ...]]]

-h <hostname> Server hostname (default: 127.0.0.1).

-p <port> Server port (default: 6379).

-s <socket> Server socket (overrides hostname and port).

-a <password> Password to use when connecting to the server.

You can also use the REDISCLI_AUTH environment

variable to pass this password more safely

(if both are used, this argument takes predecence).

--user <username> Used to send ACL style 'AUTH username pass'. Needs -a.

--pass <password> Alias of -a for consistency with the new --user option.

--askpass Force user to input password with mask from STDIN.

If this argument is used, '-a' and REDISCLI_AUTH

environment variable will be ignored.

-u <uri> Server URI.

-r <repeat> Execute specified command N times.

-i <interval> When -r is used, waits <interval> seconds per command.

It is possible to specify sub-second times like -i 0.1.

-n <db> Database number.

-3 Start session in RESP3 protocol mode.

-x Read last argument from STDIN.

-d <delimiter> Multi-bulk delimiter in for raw formatting (default: \n).

-c Enable cluster mode (follow -ASK and -MOVED redirections).

--raw Use raw formatting for replies (default when STDOUT is

not a tty).

--no-raw Force formatted output even when STDOUT is not a tty.

--csv Output in CSV format.

--stat Print rolling stats about server: mem, clients, ...

--latency Enter a special mode continuously sampling latency.

If you use this mode in an interactive session it runs

forever displaying real-time stats. Otherwise if --raw or

--csv is specified, or if you redirect the output to a non

TTY, it samples the latency for 1 second (you can use

-i to change the interval), then produces a single output

and exits.

--latency-history Like --latency but tracking latency changes over time.

Default time interval is 15 sec. Change it using -i.

--latency-dist Shows latency as a spectrum, requires xterm 256 colors.

Default time interval is 1 sec. Change it using -i.

--lru-test <keys> Simulate a cache workload with an 80-20 distribution.

--replica Simulate a replica showing commands received from the master.

--rdb <filename> Transfer an RDB dump from remote server to local file.

--pipe Transfer raw Redis protocol from stdin to server.

--pipe-timeout <n> In --pipe mode, abort with error if after sending all data.

no reply is received within <n> seconds.

Default timeout: 30. Use 0 to wait forever.

--bigkeys Sample Redis keys looking for keys with many elements (complexity).

--memkeys Sample Redis keys looking for keys consuming a lot of memory.

--memkeys-samples <n> Sample Redis keys looking for keys consuming a lot of memory.

And define number of key elements to sample

--hotkeys Sample Redis keys looking for hot keys.

only works when maxmemory-policy is *lfu.

--scan List all keys using the SCAN command.

--pattern <pat> Useful with --scan to specify a SCAN pattern.

--intrinsic-latency <sec> Run a test to measure intrinsic system latency.

The test will run for the specified amount of seconds.

--eval <file> Send an EVAL command using the Lua script at <file>.

--ldb Used with --eval enable the Redis Lua debugger.

--ldb-sync-mode Like --ldb but uses the synchronous Lua debugger, in

this mode the server is blocked and script changes are

not rolled back from the server memory.

--cluster <command> [args...] [opts...]

Cluster Manager command and arguments (see below).

--verbose Verbose mode.

--no-auth-warning Don't show warning message when using password on command

line interface.

--help Output this help and exit.

--version Output version and exit.

Cluster Manager Commands:

Use --cluster help to list all available cluster manager commands.

Examples:

cat /etc/passwd | redis-cli -x set mypasswd

redis-cli get mypasswd

redis-cli -r 100 lpush mylist x

redis-cli -r 100 -i 1 info | grep used_memory_human:

redis-cli --eval myscript.lua key1 key2 , arg1 arg2 arg3

redis-cli --scan --pattern '*:12345*'

(Note: when using --eval the comma separates KEYS[] from ARGV[] items)

When no command is given, redis-cli starts in interactive mode.

Type "help" in interactive mode for information on available commands

and settings.

2、Redis 系统相关命令

| 命令 | 描述 |

|---|---|

| ping | 如果连接成功返回PONG,连接失败返回错误信息 |

| auth password | 使用auth命令验证密码是否正确 |

| dbsize | 统计当前库下key的数量 |

| select index | 数据库之间进行切换 |

| flushdb | 清除当前库全数据 |

| flushall | 清除所有库全数据 |

| shutdown [SAVE | NOSAVE] | 停止所有客户端 |

| info [section] | 查看服务器信息,section 参数代表查看执行选项 |

| config get patten | 查看配置信息 |

| config set parameter value | 修改当前配置信息无需重启,当重启会失效 |

| config resetstat | 重置 info 命令中的某些统计数据,例 Keyspace hits/misses |

| config rewrite | 对启动Redis时指定的redis.conf文件进行改写 |

| time | 获取当前时间 |

| debug object key | 获取 key 的调试信息,当key不存在时返回错误信息。 |

| debug segfault | 执行1个非法的内存访问让 Redis 崩溃,仅开发时用于 BUG 调试,执行后需要重启服务 |

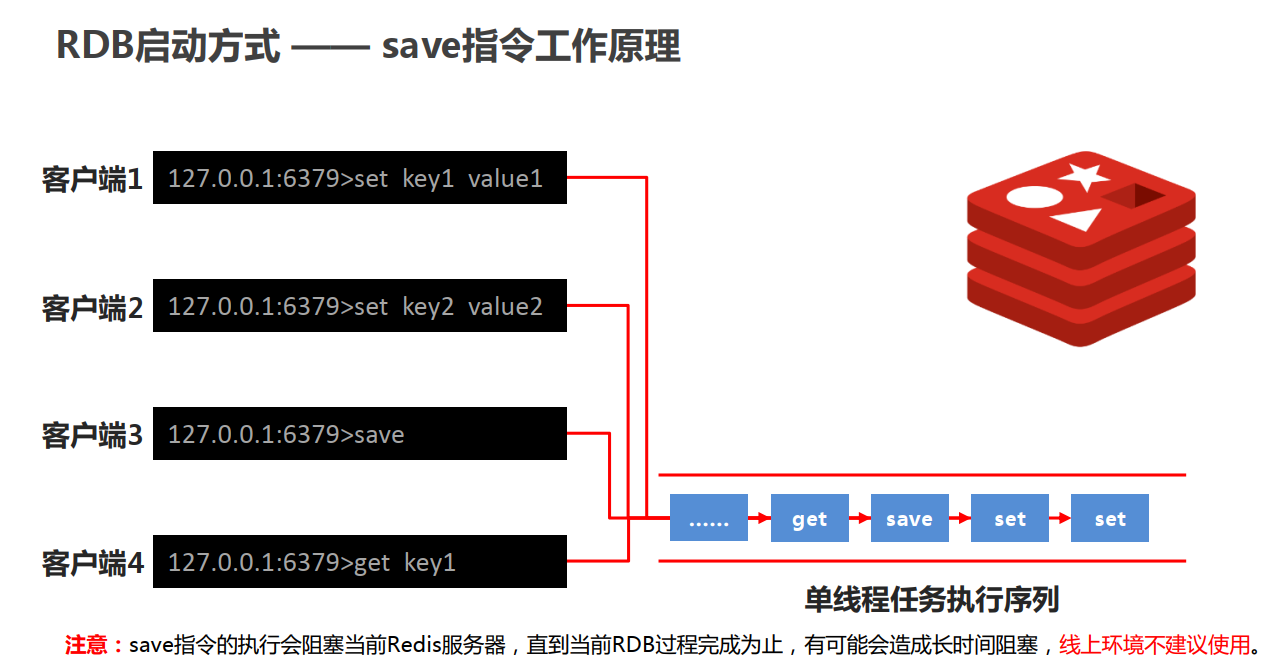

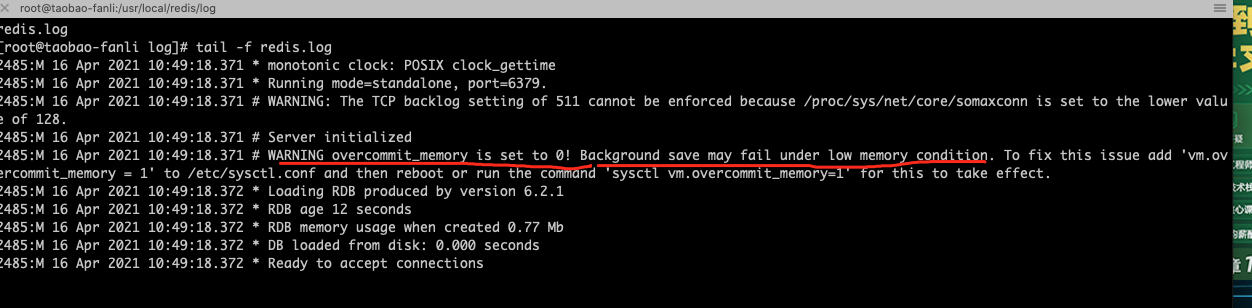

| save | 同步地将redis中的数据持久化到磁盘 |

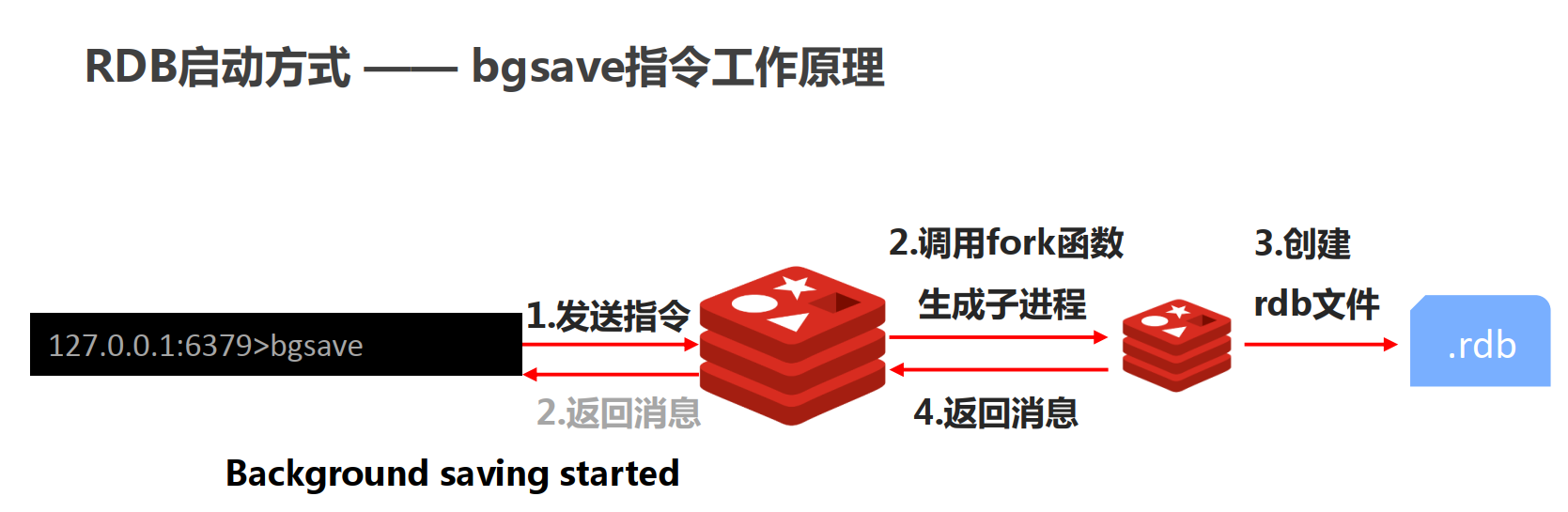

| bgsave | 异步将redis中的数据持久化到磁盘 |

| bgrewriteaof | 执行一个异步的AOF(append only file)文件重写 |

| lastsave | 查看上次持久化到磁盘的时间(以UNIX时间戳格式展示) |

| quit | 关闭连接 |

| command | 返回所有的Redis命令的详细信息,以数组形式展示 |

| command count | 查看当前Redis中命令的数量 |

| command info command-name [command-name…] | 查看当前Redis中指定的命令的详细信息 |

| client kill ip:port | 关闭地址为ip:port的客户端(命令执行完毕之后才会关闭客户端) |

| client list | 以可读的格式,返回所有连接到服务器的客户端信息和统计数据 |

| slaveof | 将当前服务器转变为指定服务器的从属服务器(slave server) |

| role | 返回主从实例所属的角色 |

| monitor | 监听redis服务器接收到的所有命令,调试用 |

| lolwut | 返回一副随机图像以及当前redis的版本信息(无意义) |

1、进入命令行模式

# 使用密码连接

redis-cli -a password_value

# raw 避免中文显示乱码

redis-cli -a password_value --raw

# 指定用户名密码登录,redis6新增ACL,后面会单开一个文章关于ACL

redis-cli --user default -a 123456 --raw

2、验证密码是否正确:auth password,校验连接状态:ping

[root@CentOS7 ~]# /usr/local/redis/bin/redis-cli

127.0.0.1:6379> ping # 如果连接成功返回PONG,连接失败返回错误信息

(error) NOAUTH Authentication required.

127.0.0.1:6379> auth xxxx # 使用错误密码连接

(error) WRONGPASS invalid username-password pair

127.0.0.1:6379> auth 123456 # 使用正确密码连接

OK

127.0.0.1:6379> ping

PONG

3、查看当前数据库大小、切换数据库、清空当前数据库或者所有数据库

127.0.0.1:6379> dbsize # 查看当前数据key数量

(integer) 4

127.0.0.1:6379> select 2 # 切换到2数据库

OK

127.0.0.1:6379[2]> flushdb # 清空2数据库

OK

127.0.0.1:6379[2]> flushall # 清空所有数据库

OK

4、获取当前服务器时间:time,返回列表: 第一个字符串是当前时间(以UNIX时间戳格式表示),第二个字符串是当前这一秒钟已经逝去的微秒数

127.0.0.1:6379> time

1) "1630030832" # 第一个值为 unix timestamp 粒度到秒

2) "844339" # 第二个返回值为该秒上当前的微秒数

5、DEBUG 调试命令:

- debug object key:获取 key 的调试信息,当 key 不存在时返回错误信息

- debug segfault:命令执行一个非法的内存访问从而让 Redis 崩溃,仅用于开发时 BUG 调试,执行后需要重启服务

127.0.0.1:6379> debug object key # 不存在key则返回错误

(error) ERR no such key

127.0.0.1:6379> debug object name # 返回name的相关信息

Value at:0x7fa17124b7b8 refcount:1 encoding:embstr serializedlength:3 lru:2571002 lru_seconds_idle:71391

127.0.0.1:6379> debug segfault # 非法命令使Redis崩溃,需要重启Redis

Could not connect to Redis at 127.0.0.1:6379: Connection refused

not connected>

6、数据持久化:save、bgsave:同步、异步将redis数据持久化到磁盘。bgrewriteaof:异步重写AOF文件(后续会细讲)

127.0.0.1:6379> save

OK

127.0.0.1:6379> bgsave

Background saving started

127.0.0.1:6379> bgrewriteaof

Background append only file rewriting started

127.0.0.1:6379>

7、查看上次RDB持久化时间:lastsave

127.0.0.1:6379> lastsave

(integer) 1630031218

8、查看当前Redis中所有可用命令:

- command:返回所有的Redis命令的详细信息,以数组形式展示

- command count:查看当前Redis中命令的数量

- command info command-name [command-name …]:查看当前Redis中指定的命令的详细信息

127.0.0.1:6379> command # 查询所有命令详情

# ....返回太长,只显示尾部。上面省略

205) 1) "debug"

2) (integer) -2

3) 1) admin

2) noscript

3) loading

4) stale

4) (integer) 0

5) (integer) 0

6) (integer) 0

7) 1) @admin

2) @slow

3) @dangerous

127.0.0.1:6379> command count # 查询命令的数量

(integer) 205

127.0.0.1:6379> command info auth # 查询指定命令详情

1) 1) "auth"

2) (integer) -2

3) 1) noscript

2) loading

3) stale

4) skip_monitor

5) skip_slowlog

6) fast

7) no_auth

4) (integer) 0

5) (integer) 0

6) (integer) 0

7) 1) @fast

2) @connection

3、Redis Info 系统命令

Redis Info 命令以一种易于理解和阅读的格式,返回关于 Redis 服务器的各种信息和统计数值,通过可选的参数 section ,可以只返回某一部分的信息(可以一次性获取所有的信息,也可以按块获取信息):

Server: # 有关redis服务器的常规信息

redis_mode:standalone # 运行模式,单机或者集群

multiplexing_api:epoll # redis所使用的事件处理机制

run_id:3abd26c33dfd059e87a0279defc4c96c13962ede # redis服务器的随机标识符(用于sentinel和集群)

config_file:/usr/local/redis/conf/redis.conf # 配置文件路径

Clients: # 客户端连接部分

connected_clients:10 # 已连接客户端的数量(不包括通过slave连接的客户端)

Memory: # 内存消耗相关信息

used_memory:874152 # 使用内存,以字节(byte)B为单位

used_memory_human:853.66K # 以人类可读的格式返回 Redis 分配的内存总量

used_memory_rss:2834432 # 系统给redis分配的内存即常驻内存,和top 、 ps 等命令的输出一致

used_memory_rss_human:2.70M # 以人类可读格式返回系统redis分配的常驻内存top、ps等命令的输出一致

used_memory_peak:934040 # 内存使用的峰值大小

used_memory_peak_human:912.15K # 以人类可读的格式返回 Redis 的内存消耗峰值

total_system_memory:1039048704 # 操作系统的总内存 ,以字节(byte)为单位

total_system_memory_human:990.91M # 以人类可读的格式返回操作系统的总内存

used_memory_lua:37888 # lua引擎使用的内存

used_memory_lua_human:37.00K # 以人类可读的格式返回lua引擎使用的内存

maxmemory:0 # 最大内存的配置值,0是不限制

maxmemory_human:0B # 以人类可读的格式

maxmemory_policy:noeviction # 达到最大内存配置值后的策略

Persistence: # RDB和AOF相关信息

rdb_bgsave_in_progress:0 # 标识rdb save是否进行中

rdb_last_bgsave_status:ok # 上次的save操作状态

rdb_last_bgsave_status:ok # 上次的save操作状态

rdb_last_bgsave_time_sec:-1 # 上次rdb save操作使用的时间(单位s)

rdb_current_bgsave_time_sec:-1 # 如果rdb save操作正在进行,则是所使用的时间

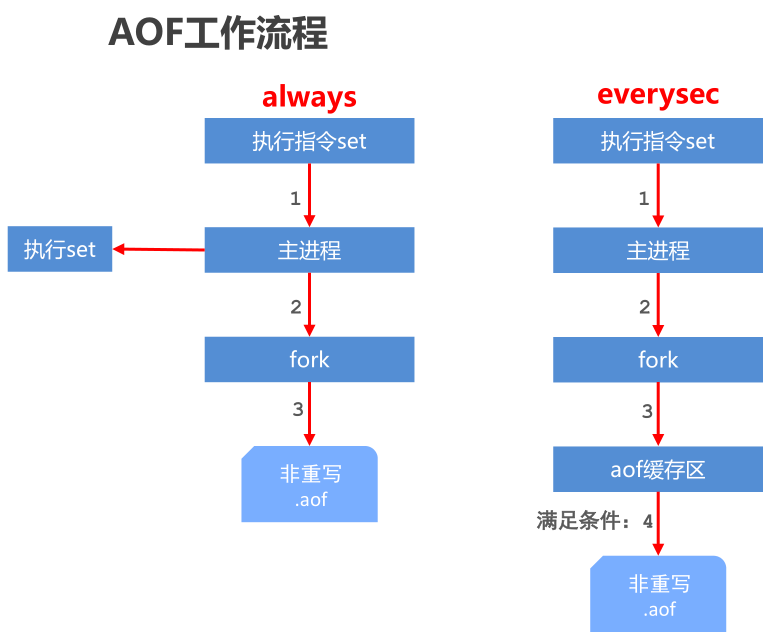

aof_enabled:1 # 是否开启aof,默认没开启

aof_rewrite_in_progress:0 # 标识aof的rewrite操作是否在进行中

aof_last_rewrite_time_sec:-1 # 上次rewrite操作使用的时间(单位s)

aof_current_rewrite_time_sec:-1 # 如果rewrite操作正在进行,则记录所使用的时间

aof_last_bgrewrite_status:ok # 上次rewrite操作的状态

aof_current_size:0 # aof当前大小

Stats: # 一般统计

evicted_keys:0 # 因为内存大小限制,而被驱逐出去的键的个数

Replication: # 主从同步信息

role:master # 角色

connected_slaves:1 # 连接的从库数

master_sync_in_progress:0 # 标识主redis正在同步到从redis

CPU: # CPU消耗统计

used_cpu_sys:1.004241

used_cpu_user:1.304583

used_cpu_sys_children:0.000000

used_cpu_user_children:0.000000

Cluster: # 集群部分

cluster_enabled:0 # 实例是否启用集群模式

Keyspace: # 数据库相关统计

db0:keys=4,expires=0,avg_ttl=0 # db0的key的数量,带有生存期的key的数,平均存活时间

- persistence : RDB 和 AOF 的相关信息

- stats : 一般统计信息

- replication : 主/从复制信息

- cpu : CPU 计算量统计信息

- commandstats : Redis 命令统计信息

- cluster : Redis 集群信息

- keyspace : 数据库相关的统计信息

1、查看全部信息:执行:info

127.0.0.1:6379> info

# Server

redis_version:6.0.6

redis_git_sha1:00000000

redis_git_dirty:0

redis_build_id:93007b2b698019d1

redis_mode:standalone

os:Linux 3.10.0-1127.19.1.el7.x86_64 x86_64

arch_bits:64

multiplexing_api:epoll

atomicvar_api:atomic-builtin

gcc_version:9.3.1

process_id:1687

run_id:765c451cf9a59c732cb3646f86f159a6240033d2

tcp_port:6379

uptime_in_seconds:1746

uptime_in_days:0

hz:10

configured_hz:10

lru_clock:2223250

executable:/usr/local/redis/bin/redis-server

config_file:/usr/local/redis/conf/redis.conf

# Clients

connected_clients:1

client_recent_max_input_buffer:2

client_recent_max_output_buffer:0

blocked_clients:0

tracking_clients:0

clients_in_timeout_table:0

# Memory

used_memory:865696

used_memory_human:845.41K

used_memory_rss:2584576

used_memory_rss_human:2.46M

used_memory_peak:865696

used_memory_peak_human:845.41K

used_memory_peak_perc:100.18%

used_memory_overhead:819162

used_memory_startup:801992

used_memory_dataset:46534

used_memory_dataset_perc:73.05%

allocator_allocated:967488

allocator_active:1228800

allocator_resident:3592192

total_system_memory:3823165440

total_system_memory_human:3.56G

used_memory_lua:37888

used_memory_lua_human:37.00K

used_memory_scripts:0

used_memory_scripts_human:0B

number_of_cached_scripts:0

maxmemory:0

maxmemory_human:0B

maxmemory_policy:noeviction

allocator_frag_ratio:1.27

allocator_frag_bytes:261312

allocator_rss_ratio:2.92

allocator_rss_bytes:2363392

rss_overhead_ratio:0.72

rss_overhead_bytes:-1007616

mem_fragmentation_ratio:3.14

mem_fragmentation_bytes:1761376

mem_not_counted_for_evict:0

mem_replication_backlog:0

mem_clients_slaves:0

mem_clients_normal:16986

mem_aof_buffer:0

mem_allocator:jemalloc-5.1.0

active_defrag_running:0

lazyfree_pending_objects:0

# Persistence

loading:0

rdb_changes_since_last_save:0

rdb_bgsave_in_progress:0

rdb_last_save_time:1629611456

rdb_last_bgsave_status:ok

rdb_last_bgsave_time_sec:-1

rdb_current_bgsave_time_sec:-1

rdb_last_cow_size:0

aof_enabled:1

aof_rewrite_in_progress:0

aof_rewrite_scheduled:0

aof_last_rewrite_time_sec:-1

aof_current_rewrite_time_sec:-1

aof_last_bgrewrite_status:ok

aof_last_write_status:ok

aof_last_cow_size:0

module_fork_in_progress:0

module_fork_last_cow_size:0

aof_current_size:118

aof_base_size:118

aof_pending_rewrite:0

aof_buffer_length:0

aof_rewrite_buffer_length:0

aof_pending_bio_fsync:0

aof_delayed_fsync:0

# Stats

total_connections_received:1

total_commands_processed:2

instantaneous_ops_per_sec:0

total_net_input_bytes:73

total_net_output_bytes:18641

instantaneous_input_kbps:0.00

instantaneous_output_kbps:0.00

rejected_connections:0

sync_full:0

sync_partial_ok:0

sync_partial_err:0

expired_keys:0

expired_stale_perc:0.00

expired_time_cap_reached_count:0

expire_cycle_cpu_milliseconds:32

evicted_keys:0

keyspace_hits:0

keyspace_misses:0

pubsub_channels:0

pubsub_patterns:0

latest_fork_usec:0

migrate_cached_sockets:0

slave_expires_tracked_keys:0

active_defrag_hits:0

active_defrag_misses:0

active_defrag_key_hits:0

active_defrag_key_misses:0

tracking_total_keys:0

tracking_total_items:0

tracking_total_prefixes:0

unexpected_error_replies:0

# Replication

role:master

connected_slaves:0

master_replid:94ccef8237ed7322980cce77f8bb07181049db6a

master_replid2:0000000000000000000000000000000000000000

master_repl_offset:0

second_repl_offset:-1

repl_backlog_active:0

repl_backlog_size:1048576

repl_backlog_first_byte_offset:0

repl_backlog_histlen:0

# CPU

used_cpu_sys:1.004241

used_cpu_user:1.304583

used_cpu_sys_children:0.000000

used_cpu_user_children:0.000000

# Modules

# Cluster

cluster_enabled:0

# Keyspace

db0:keys=3,expires=0,avg_ttl=0

2、当然也可以获取单个的信息(交互式info命令使用)

127.0.0.1:6379> info replication

# Replication

role:master

connected_slaves:0

master_replid:94ccef8237ed7322980cce77f8bb07181049db6a

master_replid2:0000000000000000000000000000000000000000

master_repl_offset:0

second_repl_offset:-1

repl_backlog_active:0

repl_backlog_size:1048576

repl_backlog_first_byte_offset:0

repl_backlog_histlen:0

3、查询 Redis 每秒执行多少次指令(终端info命令使用)

[root@CentOS7 bin]# ./redis-cli info stats | grep ops

instantaneous_ops_per_sec:12

以上,表示 ops 是 12,也就是所有客户端每秒会发送 12 条指令到服务器执行。极限情况下,Redis 可以每秒执行 10w 次指令,CPU 几乎完全榨干。如果 qps 过高,可以考虑通过 monitor 指令快速观察一下究竟是哪些 key 访问比较频繁,从而在相应的业务上进行优化,以减少 IO 次数。monitor 指令会瞬间吐出来巨量的指令文本,所以一般在执行 monitor 后立即 ctrl+c 中断输出

[root@CentOS7 bin]# ./redis-cli monitor

OK

^C

[1]+ Stopped redis-cli monitor

4、Redis 连接了多少客户端 ?这个信息在 Clients 块里,可以通过 info clients 看到

[root@CentOS7 bin]# ./redis-cli info clients

# Clients

connected_clients:1

client_recent_max_input_buffer:2

client_recent_max_output_buffer:0

blocked_clients:0

tracking_clients:0

clients_in_timeout_table:0

这个信息也是比较有用的,通过观察这个数量可以确定是否存在意料之外的连接。如果发现这个数量不对劲,接着就可以使用 client list 指令列出所有的客户端链接地址来确定源头

关于客户端的数量还有个重要的参数需要观察,那就是 rejected_connections,它表示因为超出最大连接数限制而被拒绝的客户端连接次数,如果这个数字很大,意味着服务器的最大连接数设置的过低需要调整 maxclients 参数

[root@CentOS7 bin]# ./redis-cli info stats | grep reject

rejected_connections:0

5、Redis 内存占用多大?这个信息在 Memory 块里,可以通过 info memory 看到。

[root@CentOS7 bin]# ./redis-cli info memory | grep used | grep human

used_memory_human:843.95K

used_memory_rss_human:2.67M

used_memory_peak_human:845.41K

used_memory_lua_human:37.00K

used_memory_scripts_human:0B

如果单个 Redis 内存占用过大,并且在业务上没有太多压缩的空间的话,可以考虑集群化了。

6、复制积压缓冲区多大?这个信息在 Replication 块里,可以通过 info replication 看到。

[root@CentOS7 bin]# ./redis-cli info replication | grep backlog

repl_backlog_active:0

repl_backlog_size:1048576

repl_backlog_first_byte_offset:0

repl_backlog_histlen:0

复制积压缓冲区大小非常重要,它严重影响到主从复制的效率。当从库因为网络原因临时断开了主库的复制,然后网络恢复了,又重新连上的时候,这段断开的时间内发生在 master 上的修改操作指令都会放在积压缓冲区中,这样从库可以通过积压缓冲区恢复中断的主从同步过程。

积压缓冲区是环形的,后来的指令会覆盖掉前面的内容。如果从库断开的时间过长,或者缓冲区的大小设置的太小,都会导致从库无法快速恢复中断的主从同步过程,因为中间的修改指令被覆盖掉了。这时候从库就会进行全量同步模式,非常耗费 CPU 和网络资源。如果有多个从库复制,积压缓冲区是共享的,它不会因为从库过多而线性增长。如果实例的修改指令请求很频繁,那就把积压缓冲区调大一些,几十个 M 大小差不多了,如果很闲,那就设置为几个 M。

[root@CentOS7 bin]# ./redis-cli info stats | grep sync

sync_full:0

sync_partial_ok:0

sync_partial_err:0

通过查看 sync_partial_err 变量的次数来决定是否需要扩大积压缓冲区,它表示主从半同步复制失败的次数。

4、Redis Config 系统命令

Config 命令介绍(配置文件中都有默认值)

| 命令 | 描述 |

|---|---|

| config get patten | 查看配置信息 |

| config set parameter value | 修改当前配置信息无需重启,当重启会失效 |

| config rewrite | 对启动Redis时指定的redis.conf文件进行改写 |

| config resetstat | 重置 info 命令中的某些统计数据,例 Keyspace hits/misses |

1、常用配置(其他配置key名可以去默认配置文件 redis.conf 中查找获取)

daemonize # 后端运行

bind # ip绑定

timeout # 客户端连接时的超时时间,单位为秒。当客户端在这段时间内没有发出任何指令,那么关闭该连接

databases # 设置数据库的个数,可以使用 SELECT 命令来切换数据库。默认使用的数据库是 0

save # 设置 Redis 进行rdb持久化数据库镜像的频率。

rdbcompression # 在进行镜像备份时,是否进行压缩

slaveof # 设置该数据库为其他数据库的从数据库

masterauth # 当主数据库连接需要密码验证时,在这里配

maxclients # 限制同时连接的客户数量,当连接数超过这个值时,redis 将不再接收其他连接请求,返回error

maxmemory # 设置 redis 能够使用的最大内存,

- 防止所用内存超过服务器物理内存, maxmemory 限制的是Redis实际使用的内存量, 也就是used_memory统计项对应的内存

- 由于内存碎片率的存在, 实际消耗的内存可能会比maxmemory设置的更大, 实际使用时要小心这部分内存溢出

- 默认无限使用服务器内存, 为防止极端情况下导致系统内存耗尽, 建议所有的Redis进程都要配置maxmemory

- 在64bit系统下,maxmemory设置为0表示不限制Redis内存使用,在32bit系统下,maxmemory不能超过3GB

- 注意:Redis 在占用的内存超过指定的 maxmemory 之后,通过 maxmemory_policy 确定 Redis 是否释放内存以及如何释放内存

2、查看配置信息(默认的):config get patten

127.0.0.1:6379> config get maxclients

1) "maxclients"

2) "10000"

127.0.0.1:6379> config get maxclients

1) "maxclients"

2) "10000"

127.0.0.1:6379> config get max*

1) "maxmemory-policy"

2) "noeviction"

3) "maxmemory-samples"

4) "5"

5) "maxclients"

6) "10000"

7) "maxmemory"

8) "0"

3、修改当前配置信息:config set parameter value

Config Set 命令可以动态地调整 Redis 服务器的配置(configuration)而无须重启,但此时配置文件中仍是修改前的配置,可搭配 config rewrite 命令一起使用:

127.0.0.1:6379> config get maxclients

1) "maxclients"

2) "10000"

127.0.0.1:6379> config set maxclients 1

OK

4、重写配置文件:config rewrite

Config rewrite 命令对启动 Redis 服务器时所指定的 redis.conf 配置文件进行改写。与config set不同,set 之后会将配置信息修改而无需重启服务,但此时redis.conf配置文件里记录的参数仍是set之前的值,如果将redis服务重启后会读取conf文件中的配置,这时候读到的还是set之前的配置,因此我们可以在set配置之后使用rewrite命令将当前的配置回写至配置文件内,这样就能不停机修改配置信息了,因此config set和config rewrite是配合使用的:

127.0.0.1:6379> config get maxclients # 查询maxclients配置

1) "maxclients"

2) "10000"

127.0.0.1:6379> config set maxclients 1 # 修改maxclients配置

OK

127.0.0.1:6379> quit

[root@CentOS7 ~]# cat /usr/local/redis/conf/redis.conf |grep maxclients # 查询配置文件中maxclients

maxclients 10000 # 如果自定义配置文件没配maxclients就不会显示

[root@CentOS7 ~]# /usr/local/redis/bin/redis-cli -a 123456 # 重新用客户端登录

Warning: Using a password with '-a' or '-u' option on the command line interface may not be safe.

127.0.0.1:6379> config rewrite # 将当前配置重写会当前配置文件

OK

127.0.0.1:6379> quit

[root@CentOS7 ~]# cat /usr/local/redis/conf/redis.conf |grep maxclients # 退出查看配置文件,发现配置写进了配置文件

maxclients 1

5、重置统计信息:config resetstat。使用该命令重置 INFO 命令中的某些统计数据,包括:

- Keyspace hits (键空间命中次数)

- Keyspace misses (键空间不命中次数)

- Number of commands processed (执行命令的次数)

- Number of connections received (连接服务器的次数)

- Number of expired keys (过期key的数量)

- Number of rejected connections (被拒绝的连接数量)

- Latest fork(2) time(最后执行 fork(2) 的时间)

- The aof_delayed_fsync counter(aof_delayed_fsync 计数器的值)

127.0.0.1:6379> config resetstat

OK

5、Redis 授权访问系统命令

1、Redis 访问密码设置(可以设置 Redis 的密码,默认是没有密码的)密码配置方式有多种:

- 在 redis.conf 配置文件配置密码

requirepass <password>

- 客户端命令行设置和获取密码

config get requirepass

config set requirepass <password>

- 启动服务器时设置密码

redis-server -a <password>

2、Redis 客户端密码访问两种方式:

- 方式一:进入命令行模式

redis-cli -a <password> # 使用密码连接

redis-cli -a <password> --raw # raw 避免中文显示乱码

redis-cli --user <username> -a <password> --raw # 指定用户名密码登录,redis6新增ACL

# 方式一:redis-cli 带参数-a登录,系统提示不建议这种方式登录

[root@CentOS7 ~]# /usr/local/redis/bin/redis-cli -a 123456

Warning: Using a password with '-a' or '-u' option on the command line interface may not be safe.

- 方式二:进入客户端模式

auth <password> # 等价于 auth default <password>

auth <username> <password> # Redis AUTH 命令也在 Redis 6.0 中进行了扩展,现在支持两个参数的访问

# 方式二:进入redis后,使用auth

# [root@CentOS7 ~]# /usr/local/redis/bin/redis-cli

127.0.0.1:6379> ping

(error) NOAUTH Authentication required.

127.0.0.1:6379> auth 123456

OK

127.0.0.1:6379> ping

PONG

PS:slave 主从访问 master 的密码配置(在redis.conf中配置):

masterauth <password>

6、Redis 危险命令禁用或重命名

安全禁用或者重命名危险命令:

rename-command CONFIG ""

对 Redis 稍微有点使用经验的人都知道线上是不能执行 keys * 命令的,虽然其模糊匹配功能使用方便也很强大,在小数据量情况下使用没什么问题,但数据量大会导致 Redis 锁住及 CPU 飙升,在生产环境建议禁用或者重命名!

- Redis还有哪些危险命令:keys、flushdb、flushall、config(客户端可修改 Redis 配置)

- 怎么禁用或重命名危险命令?在 redis.conf 中添加 rename-command 配置即可达到安全目的

# 1.禁用命令:

rename-command KEYS ""

rename-command FLUSHALL ""

rename-command FLUSHDB ""

rename-command CONFIG ""

# 2.重命名命令:XX 可以定义新命令名称,或者用随机字符代替

rename-command KEYS "XXXXXXXXXXXX"

rename-command FLUSHALL "XXXXXXXXXXXX"

rename-command FLUSHDB "XXXXXXXXXXXX"

rename-command CONFIG "XXXXXXXXXXXX"

Redis 配置文件详解

默认配置文件名:redis.conf

1、容器单位

# Redis configuration file example.

#

# Note that in order to read the configuration file, Redis must be

# started with the file path as first argument:

#

# ./redis-server /path/to/redis.conf

# Note on units: when memory size is needed, it is possible to specify

# it in the usual form of 1k 5GB 4M and so forth:

#

# 1k => 1000 bytes

# 1kb => 1024 bytes

# 1m => 1000000 bytes

# 1mb => 1024*1024 bytes

# 1g => 1000000000 bytes

# 1gb => 1024*1024*1024 bytes

#

# units are case insensitive so 1GB 1Gb 1gB are all the same.

这里没什么好说的,需要注意的是后面需要使用内存大小时,可以指定单位,通常是以 k,gb,m的形式出现,并且单位不区分大小写。

2、INCLUDES 文件包含

################################## INCLUDES ###################################

# Include one or more other config files here. This is useful if you

# have a standard template that goes to all Redis servers but also need

# to customize a few per-server settings. Include files can include

# other files, so use this wisely.

#

# Notice option "include" won't be rewritten by command "CONFIG REWRITE"

# from admin or Redis Sentinel. Since Redis always uses the last processed

# line as value of a configuration directive, you'd better put includes

# at the beginning of this file to avoid overwriting config change at runtime.

#

# If instead you are interested in using includes to override configuration

# options, it is better to use include as the last line.

#

# include /path/to/local.conf

# include /path/to/other.conf

配置文件可以将多个配置文件合起来使用。好比 Spring、Improt, include

3、NETWORK 网络

bind 127.0.0.1 # 绑定的 IP

protected-mode no # 保护模式

port 6379 # 端口设置

4、GENERAL 通用

daemonize yes # 以守护进程的方式运行,默认是 no ,我们需要自己开启为 yes

pidfile /var/run/redis_6379.pid # 如果是后台启动,我们需要指定一个pid 文件

# 日志级别

# Specify the server verbosity level.

# This can be one of:

# debug (a lot of information, useful for development/testing)

# verbose (many rarely useful info, but not a mess like the debug level)

# notice (moderately verbose, what you want in production probably)

# warning (only very important / critical messages are logged)

loglevel notice # 日志级别

logfile "" # 日志文件的位置

databases 16 # 数据库的数量,默认是 16

always-show-logo yes # 是否总是显示 LOGO

5、SNAPSHOTTING 快照

################################ SNAPSHOTTING ################################

#

# Save the DB on disk:

#

# save <seconds> <changes>

#

# Will save the DB if both the given number of seconds and the given

# number of write operations against the DB occurred.

#

# In the example below the behaviour will be to save:

# after 900 sec (15 min) if at least 1 key changed

# after 300 sec (5 min) if at least 10 keys changed

# after 60 sec if at least 10000 keys changed

#

# Note: you can disable saving completely by commenting out all "save" lines.

#

# It is also possible to remove all the previously configured save

# points by adding a save directive with a single empty string argument

# like in the following example:

#

# save ""

save 900 1 # 如果 900s 内,至少有 1 个 key 进行了修改,进行持久化操作

save 300 10 # 如果 300s 内,至少有 10 个 key 进行了修改,进行持久化操作

save 60 10000 # 如果 60s 内,至少有 10000 个 key 进行了修改,进行持久化操作

stop-writes-on-bgsave-error yes # 如果持久化出错,是否还要继续工作

rdbcompression yes # 是否压缩 rdb 文件,需要消耗一些 cpu 资源

rdbchecksum yes # 保存 rdb 文件的时候,进行错误的检查校验

dbfilename dump.rdb # 数据库的文件名

rdb-del-sync-files no # 在没有持久性的情况下删除复制中使用的RDB文件,通常情况下保持默认即可

dir ./ # rdb 文件保存的目录

持久化,在规定的时间内,执行了多少次操作则会持久化到文件。Redis 是内存数据库,如果没有持久化,那么数据断电即失。

6、REPLICATION 同步

################################# REPLICATION(主从复制配置) #################################

# 如果当前服务器为slave,那么这里配置的就是master的ip和端口,如:192.168.1.2 6379

# replicaof <masterip> <masterport>

# 如果当前服务器为slave,那么这里配置的就是master的访问密码

# masterauth <master-password>

# 如果当前服务器为slave,那么这里配置的就是master的用户名

# masteruser <username>