日志的概念

1、日志简介

1、日志是什么

日志:记录程序的运行轨迹,方便查找关键信息,也方便快速定位解决问题

通常,Java程序员在开发项目时都是依赖Eclipse/IDEA等集成开发工具的Debug 调试功能来跟踪解决Bug,但项目发布到了测试、生产环境怎么办?你有可能会说可以使用远程调试,但实际并不能允许让你这么做。

所以,日志的作用就是在测试、生产环境没有 Debug 调试工具时开发和测试人员定位问题的手段。日志打得好,就能根据日志的轨迹快速定位并解决线上问题,反之,日志输出不好,不仅无法辅助定位问题反而可能会影响到程序的运行性能和稳定性。

很多介绍 AOP 的地方都采用日志来作为介绍,实际上日志要采用切面的话是极其不科学的!对于日志来说,只是在方法开始、结束、异常时输出一些什么,那是绝对不够的,这样的日志对于日志分析没有任何意义。如果在方法的开始和结束整个日志,那方法中呢?如果方法中没有日志的话,那就完全失去了日志的意义!如果应用出现问题要查找由什么原因造成的,也没有什么作用。这样的日志还不如不用!

2、日志的作用

不管是使用何种编程语言,日志输出几乎无处不再。总结起来,日志大致有以下几种用途:

- 「问题追踪」:辅助排查和定位线上问题,优化程序运行性能

- 「状态监控」:通过日志分析,可以监控系统的运行状态

- 「安全审计」:审计主要体现在安全上,可以发现非授权的操作

总结:日志在应用程序中是非常非常重要的,好的日志信息能有助于我们在程序出现BUG时能快速进行定位,并能找出其中的原因。作为一个有修养的程序猿,对日志这个东西应当引起足够的重视。

2、常见日志框架

1、日志门面

- JCL(Apache Commons Logging,原名 Jakarta Commons Logging):commons-logging 是日志的门面接口,它也是Apache 最早提供的日志门面接口,用户可以根据喜好选择不同的日志实现框架,而不必改动日志定义,这就是日志门面的好处,符合面对接口抽象编程。现在已经不太流行了,了解一下就行

- SLF4j( Simple Logging Facade for Java):为Java提供的简单日志Facade。Facade门面,更底层一点说就是接口。它允许用户以自己的喜好,在工程中通过slf4j接入不同的日志系统。因此slf4j入口就是众多接口的集合,它不负责具体的日志实现,只在编译时负责寻找合适的日志系统进行绑定。具体有哪些接口,全部都定义在slf4j-api中。查看slf4j-api源码就可以发现,里面除了public final class LoggerFactory类之外,都是接口定义。因此slf4j-api本质就是一个接口定义。

- jboss-logging(诞生就不是为了服务大众)

2、日志实现:JUL(java.util.logging)、Log4j、Log4j2、Logback

- JUL:这是 Java 自带的日志工具类,在 JDK 1.5 开始就已经有了,在 java.util.logging 包下。通常情况下,这个基本没什么人用了,了解一下就行

- Log4j:是 Apache 的一个开源日志框架,也是市场占有率最多的一个框架。注意:log4j 在 2015.08.05 这一天被 Apache 宣布停止维护了,用户需要切换到 Log4j2上面去

- Log4j2:Apache Log4j 2是apache开发的一款Log4j的升级产品。Log4j2与Log4j1发生了很大的变化,log4j2不兼容log4j1

- Logback:是 Slf4j 的原生实现框架,同样也是出自 Log4j 一个人之手,但拥有比 log4j 更多的优点、特性和更做强的性能,现在基本都用来代替 log4j 成为主流

SLF4J、Log4j、Logback都是同一个人Ceki写的。为什么写三个呢?那是因为Ceki先写了Log4j,但后面觉得Log4j太烂了,他已经不想改了。所以后面写了logback。Log4j2呢,从设计上来说很优秀,但太优秀了,太先进了,很多开源框架对其支持有限(Log4j2性能优于logback,但为了有高性能,设计得过于复杂,没必要,用Logback就够了)

如下是日志结构框架:

┌───────────────────┐ ┌────────────────────────────────────┐

│ 日志适配器 │ »»»»»»»»» │ 日志门面 │

│ │ »»»»»»»»» │ slf4j commons-logging │

│ │ └────────────────────────────────────┘

│ jul-to-slf4j │ ┌────────────────────────────────────┐

│ log4j-over-slf4j │ │ 日志门面的适配器 │

│ jcl-to-slf4j │ │ slf4j-jdk slf4j-jcl slf4j-log4j12 |

└───────────────────┘ └────────────────────────────────────┘

┌───────────────────────────────────────────────────────────────────────────┐

│ 日志库的具体实现 │

│ log4j log4j2 logback log-jdk otherLogging │

└───────────────────────────────────────────────────────────────────────────┘

3、日志框架怎么选

选项太多了的后果就是选择困难症,我的看法是没有最好的,只有最合适的:

- commons-loggin、slf4j 只是一种日志抽象门面,不是具体的日志框架。log4j、logback 是具体的日志实现框架。

- 在关注性能的地方,选择Logback或自己实现高性能Logging API可能更合适。推荐:slf4j + logback.

- 在非常关注异步性能或已经使用了Log4j的项目中,如果没有发现问题,继续使用可能是更合适的方式:推荐组合为:slf4j + Log4j2

- 如果不想有依赖则使用java.util.logging或框架容器已经提供的日志接口

- SLF4J实现机制决定SLF4J限制较少,使用范围更广。由于SLF4J在编译期间,静态绑定本地的LOG库使得通用性要比Commons Logging要好

- Commons Logging开销更高,所以一般日志门面都会选择SLF4J

- Logback拥有更好的性能。Logback声称:某些关键操作,比如判定是否记录一条日志语句的操作,其性能得到了显著的提高。这个操作在Logback中需要3纳秒,而在Log4J中则需要30纳秒。LogBack创建记录器(logger)的速度也更快:13毫秒,而在Log4J中需要23毫秒。更重要的是,它获取已存在的记录器只需94纳秒,而Log4J需要2234纳秒,时间减少到了1/23。跟JUL相比的性能提高也是显著的(这只是在Log4j2出现之前)

- Logback文档免费。Logback的所有文档是全面免费提供的,不象Log4J那样只提供部分免费文档而需要用户去购买付费文档

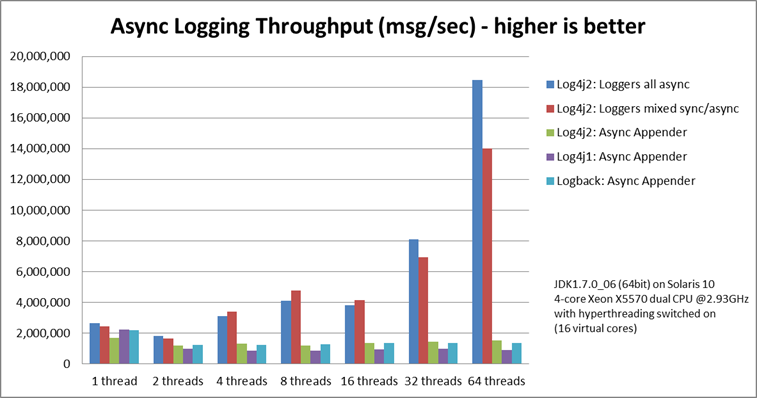

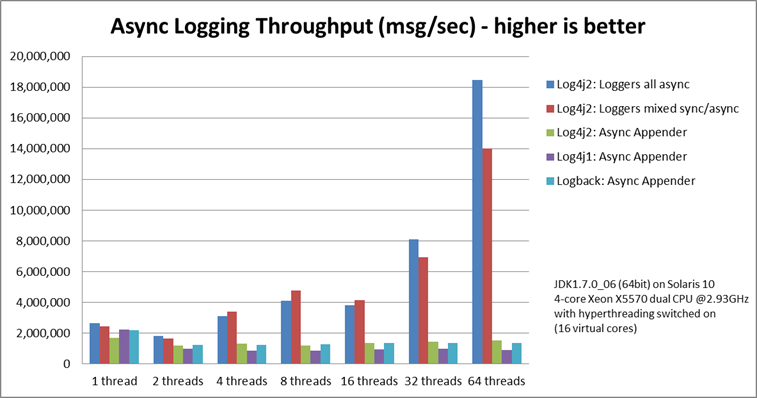

- Log4j2的出现改变的Logback的地位,他重写了Log4j1.x并修复了Logback中的不足,在性能方面不管是同步还是异步功能都吊打所有的日志框架

- 总结:如果是使用SpringBoot开发,正常没有特殊性能要求的话,使用Logback或Log4j2都行,建议使用Logback,SpringBoot自带可以减少引入依赖,如果对性能有要求,并且对功能要求较高,可以使用Log4j2(在功能和性能上都比Logback丰富)

4、日志发展历史

1、阶段一(System)

2001年以前,Java是没有日志库的,打印日志全凭:System.out 和 System.err。缺点:

- 产生大量的IO操作同时在生产环境中无法合理的控制是否需要输出

- 输出的内容不能保存到文件

- 只打印在控制台,打印完就过去了,也就是说除非你一直盯着程序跑

- 无法定制化,且日志粒度不够细

2、阶段二(Log4j)

2001年,一个叫Ceki Gulcü的大佬搞了一个日志框架 log4j后来(Log4j成为Apache项目),Ceki加入Apache组织Apache还曾经建议Sun引入Log4j到Java的标准库中,但Sun拒绝了。

3、阶段三(JUL)

Sun有自己的小心思,2002年2月JDK1.4发布,Sun推出了自己的日志标准库JUL(Java Util Logging),其实是照着Log4j抄的,而且还没抄好,还是在JDK1.5以后性能和可用性才有所提升。由于Log4j比JUL好用,并且成熟,所以Log4j在选择上占据了一定的优势。

4、阶段四(JCL)

2002年8月Apache推出了JCL(Jakarta Commons Logging),也就是日志抽象层,支持运行时动态加载日志组件的实现,当然也提供一个默认实现Simple Log(在ClassLoader中进行查找,如果能找到Log4j则默认使用Log4j实现,如果没有则使用JUL实现,再没有则使用JCL内部提供的Simple Log实现)

项目

⬇

JCL

⬇

┌────────────────────┬───────────────────────────┬──────────────────────────────┐

Log4JLogger JDK14Logger Jdk13LumberjackLogger SimpleLog

JUL有三个缺点:

1.效率较低

2.容易引发混乱

3.使用了自定义ClassLoader的程序中,使用JCL会引发内存泄露

5、阶段五(SLF4J)

SLF4J的由来与背景:在Log4j开发出来出来之后,Log4j就受到了广大开发者的爱好,纷纷开始使用Log4j,但是后来Log4j的创始人跟Apache因为一些矛盾从Apache辞职自己去创业了,创始人为了给自己的公司打出一点名声,所以就基于Log4j又开发出了一个新的日志框架Logback,Logback不管是性能还是功能都比Log4j强,但是却很少人使用, 因为JCL门面不支持Logback,所以这个创世人又设计出了slf4j,slf4j支持市面上所有主流的日志框架;所以目前为止,使用最多的就是SLF4J了; 后来Apache又基于Logback的源码设计出了Log4j2日志,性能上Log4j2比Logback更胜一筹,并且Log4j2既是日志框架,也是门面技术,但是Log4j2的门面技术很少人使用,大多还是使用SLF4J。

2006年巨佬Ceki(Log4j的作者)因为一些原因离开了Apache组织,之后Ceki觉得JCL不好用,自己重写了一套新的日志标准接口规范Slf4j(Simple Logging Facacfor Java),也可以称为日志门面,很明显Slf4j是对标JCL,后面也证明了Slf4j比JCL更优秀。

大佬Ceki提供了一系列的桥接包来帮助Slf4j接口与其他日志库建立关系,这种方式称桥接设计模式。代码使用Slf4j接口,就可以实现日志的统一标准化,后续如果想要更换日志实现,只需引入Slf4j与相关的桥接包,再引入具体的日志标准库即可。

6、阶段六(Logback)

Ceki巨佬觉得市场上的日志标准库都是间接实现Slf4j接口,也就是说每次都需要配合桥接包,因此在2006年,Ceki巨佬基于Slf4j接口写出了Logback日志标准库,做为Slf4j接口的默认实现,Logback也十分给力,在功能完整度和性能上超越了所有已有的日志标准库。

- 根本原因还在于,随着用户体量的提升,Log4j无法满足高性能的要求,成为应用的性能瓶颈

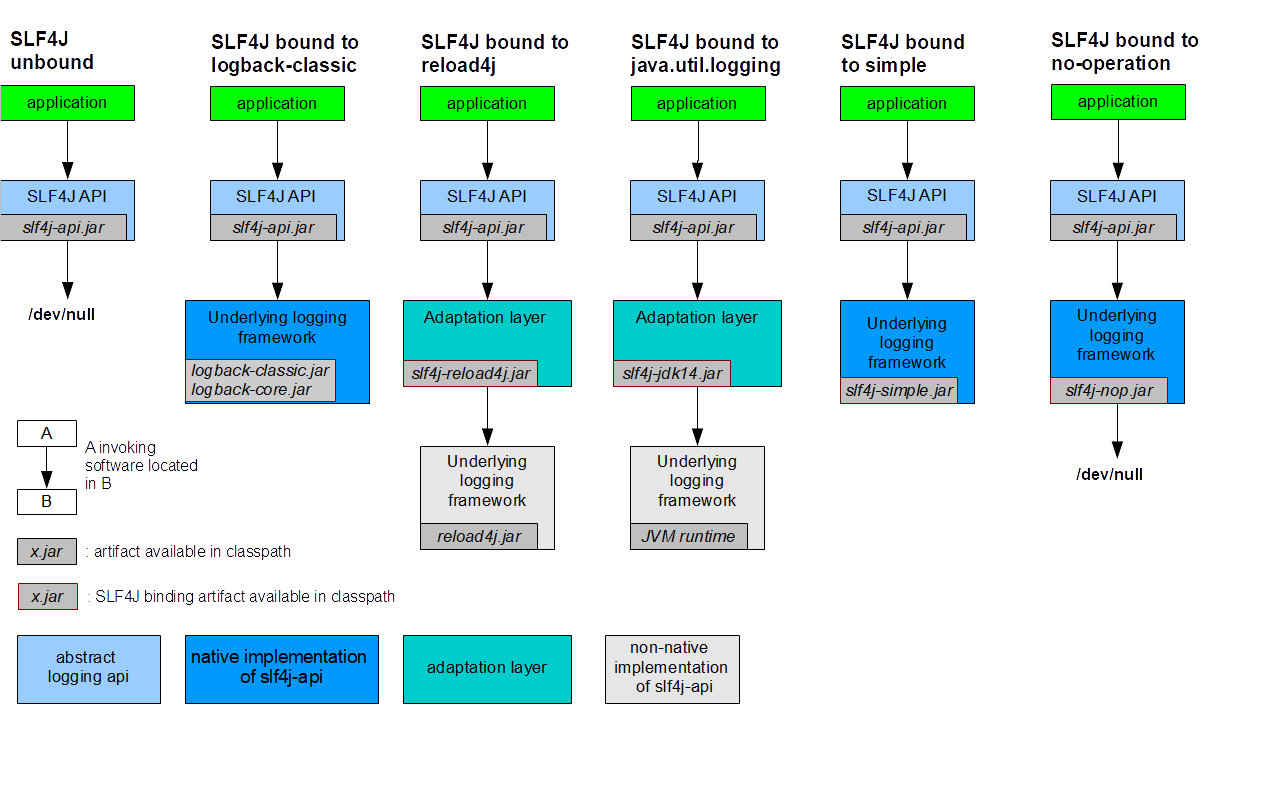

- 通过SLF4j桥接到具体的日志框架实现。日志框架的绑定(Binding):绑定其他日志的实现

- 通过其他日志框架桥接到SLF4j。日志框架的桥接(Bridging):桥接旧的日志框架

7、阶段七(Log4j2)

产生背景:Logback算是JAVA 里一个老牌的日志框架,从06年开始第一个版本,迭代至今也十几年了。不过logback最近一个最稳定版本还停留在 2017 年,好几年都没有更新大版本了Llogback的兄弟SLF4J最近一个稳定版也是2017年。而且Logback的异步性能实在拉跨,功能简陋,配置又繁琐,远不及Apache的新一代日志框架:Log4j2。目前来看,Log4j2就是王者,其他日志框架都不是对手。

2012年,Apache直接推出新项目Log4j2(不兼容Log4j),Log4j2全面借鉴Slf4j+Logback 。Log4j2不仅仅具有Logback的所有特性,还做了分离设计,分为log4j-api和log4j-core,log4j-api是日志接口,log4j-core是日志标准库,并且Apache也为Log4j2提供了各种桥接包。而且log4j2 的性能提升很大,而且支持异步日志打印。增加很多新的特性

5、日志打印的建议

1、打日志建议简单版

- 应用中不可直接使用日志系统中的API (Log4j,Logback),而应依赖使用日志框架SLF4J中的API。使用门面模式有利于维护和各个类的日志处理方法统一

- 日志文件推荐至少保存15天,因为有些异常具备以“周”为频次发生的特点

- 应用中的扩展日志(如打点、临时监控、访问日志等)命名方式:appName_logType_logName.log。logType为日志类型,推荐分类有stats/monitor/visit 等

- logName为日志描述。这种命名的好处:通过文件名就可以知道日志文件属于哪个应用,哪种类型,有什么目的,这也有利于归类查找

- 对trace、debug、info级别的日志输出,必须使用条件输出形式或者占位符的方式

- 避免重复打印日志,否则会浪费磁盘空间。务必在日志配置文件中设置additivity=false

- 异常信息应该包括两类:案发现场信息和异常堆栈信息。如果不处理,那么通过关键字向上抛出

- 谨慎地记录日志。生产环境禁止输出debug日志;有选择地输出info日志;如果使用warn记录刚上线时的业务行为信息,一定要注意日志输出量的问题,避免吧服务器磁盘撑爆,并及时删除这些观察日志

- 可以使用warn日志级别记录用户输入参数错误的情况,避免当用户投诉时无所适从

2、打日志建议详情版

日志是快速定位问题的好帮手,是撕逼和甩锅的利器!打印好日志非常重要。今天我们来聊聊日志打印的15个好建议

1、选择恰当的日志级别

常见的日志级别有5种,分别是error、warn、info、debug、trace。日常开发中,我们需要选择恰当的日志级别,不要直接打印info

- error:错误日志,指比较严重的错误,对正常业务有影响,需要运维配置监控的;

- warn:警告日志,一般的错误,对业务影响不大,但是需要开发关注;

- info:信息日志,记录排查问题的关键信息,如调用时间、出参入参等等;

- debug:用于开发DEBUG的,关键逻辑里面的运行时数据;

- trace:最详细的信息,一般这些信息只记录到日志文件中。

2、日志要打印出方法的入参和出参

我们并不需要打印很多很多日志,只需要打印可以快速定位问题的有效日志。有效的日志,才能有效的查到问题!哪些算得的上有效关键的日志呢?比如说,方法进来的时候,打印入参。再然后呢,在方法返回的时候,就是打印出参,返回值。入参的话,一般就是userId或者bizSeq这些关键信息。正例如下:

public String testLogMethod(Document doc, Mode mode){

log.debug(“method enter param:{}”,userId);

String id = "666";

log.debug(“method exit param:{}”,id);

return id;

}

3、选择合适的日志格式

理想的日志格式,应当包括这些最基本的信息:如当前时间戳(一般毫秒精确度)、日志级别,线程名字等等。在logback日志里可以这么配置:

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{HH:mm:ss.SSS} %-5level [%thread][%logger{0}] %m%n</pattern>

</encoder>

</appender>

4、遇到if…else…时,每个分支首行都尽量打印日志

当你碰到if…else…或者switch这样的条件时,可以在分支的首行就打印日志,这样排查问题时,就可以通过日志,确定进入了哪个分支,代码逻辑更清晰,也更方便排查问题了。

if(user.isVip()){

log.info("该用户是会员,Id:{},开始处理会员逻辑",user,getUserId());

// 会员逻辑

}else{

log.info("该用户是非会员,Id:{},开始处理非会员逻辑",user,getUserId());

// 非会员逻辑

}

5、日志级别比较低时,进行日志开关判断

对于trace/debug这些比较低的日志级别,必须进行日志级别的开关判断。

User user = new User(666L, "公众号", "捡田螺的小男孩");

if (log.isDebugEnabled()) {

log.debug("userId is: {}", user.getId());

}

因为当前有如下的日志代码:

logger.debug("Processing trade with id: " + id + " and symbol: " + symbol);

如果配置的日志级别是warn的话,上述日志不会打印,但是会执行字符串拼接操作,如果symbol是对象, 还会执行toString()方法,浪费了系统资源,执行了上述操作,最终日志却没有打印,因此建议加日志开关判断。

6、不能直接使用日志系统(Log4j、Logback)中的 API,而是使用日志框架SLF4J中的API

SLF4J 是门面模式的日志框架,有利于维护和各个类的日志处理方式统一,并且可以在保证不修改代码的情况下,很方便的实现底层日志框架的更换。

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

private static final Logger logger = LoggerFactory.getLogger(TianLuoBoy.class);

7、建议使用参数占位{},而不是用+拼接

反例:

logger.info("Processing trade with id: " + id + " and symbol: " + symbol);

上面的例子中,使用+操作符进行字符串的拼接,有一定的性能损耗。

正例:

logger.info("Processing trade with id: {} and symbol : {} ", id, symbol);

我们使用了大括号{}来作为日志中的占位符,比于使用+操作符,更加优雅简洁。并且,相对于反例,使用占位符仅是替换动作,可以有效提升性能。

8、建议使用异步的方式来输出日志。

- 日志最终会输出到文件或者其它输出流中的,IO性能会有要求的。如果异步,就可以显著提升IO性能。

- 除非有特殊要求,要不然建议使用异步的方式来输出日志。以logback为例吧,要配置异步很简单,使用AsyncAppender就行

<appender name="FILE_ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<appender-ref ref="ASYNC"/>

</appender>

9、不要使用e.printStackTrace()

反例:

try {

// 业务代码处理

} catch(Exception e) {

e.printStackTrace();

}

正例:

try {

// 业务代码处理

} catch(Exception e) {

log.error("你的程序有异常啦",e);

}

理由:

- e.printStackTrace()打印出的堆栈日志跟业务代码日志是交错混合在一起的,通常排查异常日志不太方便。

- e.printStackTrace()语句产生的字符串记录的是堆栈信息,如果信息太长太多,字符串常量池所在的内存块没有空间了,即内存满了,那么,用户的请求就卡住啦~

10、异常日志不要只打一半,要输出全部错误信息

反例1:

try {

//业务代码处理

} catch (Exception e) {

// 错误

LOG.error('你的程序有异常啦');

}

异常e都没有打印出来,所以压根不知道出了什么类型的异常。

反例2:

try {

//业务代码处理

} catch (Exception e) {

// 错误

LOG.error('你的程序有异常啦', e.getMessage());

}

e.getMessage()不会记录详细的堆栈异常信息,只会记录错误基本描述信息,不利于排查问题。

正例:

try {

//业务代码处理

} catch (Exception e) {

// 错误

LOG.error('你的程序有异常啦', e);

}

11、禁止在线上环境开启 debug

禁止在线上环境开启debug,这一点非常重要。因为一般系统的debug日志会很多,并且各种框架中也大量使用 debug的日志,线上开启debug不久可能会打满磁盘,影响业务系统的正常运行。

12、不要记录了异常,又抛出异常

反例如下:

log.error("IO exception", e);

throw new MyException(e);

- 这样实现的话,通常会把栈信息打印两次。这是因为捕获了MyException异常的地方,还会再打印一次。

- 这样的日志记录,或者包装后再抛出去,不要同时使用!否则你的日志看起来会让人很迷惑。

13、避免重复打印日志

避免重复打印日志,酱紫会浪费磁盘空间。如果你已经有一行日志清楚表达了意思,避免再冗余打印,反例如下:

if (user.isVip()) {

log.info("该用户是会员,Id:{}",user,getUserId());

// 冗余,可以跟前面的日志合并一起

log.info("开始处理会员逻辑,id:{}",user,getUserId());

// 会员逻辑

} else {

// 非会员逻辑

}

如果你是使用log4j日志框架,务必在log4j.xml中设置 additivity=false,因为可以避免重复打印日志。正例:

<logger name="com.taobao.dubbo.config" additivity="false">

14、日志文件分离

- 我们可以把不同类型的日志分离出去,比如access.log,或者error级别error.log,都可以单独打印到一个文件里面。

- 当然,也可以根据不同的业务模块,打印到不同的日志文件里,这样我们排查问题和做数据统计的时候,都会比较方便啦。

15、核心功能模块,建议打印较完整的日志

- 我们日常开发中,如果核心或者逻辑复杂的代码,建议添加详细的注释,以及较详细的日志。

- 日志要多详细呢?脑洞一下,如果你的核心程序哪一步出错了,通过日志可以定位到,那就可以啦。

6、日志分析工具汇总

运维利器:9个Java日志分析工具:https://mp.weixin.qq.com/s/cvnA_HiglxAd5x6XtmnOIQ

- Apache Log4j:Java领域资格最老,应用最广的日志工具

- 官网:https://logging.apache.org/log4j/2.x/

- Log4j是apache的一个开源项目,创始人Ceki Gulcu。Log4j 从诞生之日到现在一直广受业界欢迎。Log4j是高度可配置的,并可通过在运行时的外部文件配置。它根据记录的优先级别,并提供机制,以指示记录信息到许多的目的地,诸如:数据库,文件,控制台,UNIX系统日志等。

- Graylog:适合扩展角色和权限管理的开源聚合器

- 官网:https://www.graylog.org/

- Graylog是强大的日志管理、分析工具。它基于 Elasticsearch, Java和MongoDB。Graylog可以收集监控多种不同应用的日志。但是为了示范说明,我只收集syslog。并且,我将会把用到的组件全部安装到一个单独的服务器上。对于大型、生产系统你可以把组件分开安装在不同的服务器上,这样可以提高效率

- Kibana:分析和可视化日志文件。 某些功能需要付款

- 官网:https://www.elastic.co/products/kibana

- Kibana是一个开源的分析和可视化平台,设计用于和Elasticsearch一起工作。你用Kibana来搜索,查看,并和存储在Elasticsearch索引中的数据进行交互。你可以轻松地执行高级数据分析,并且以各种图标、表格和地图的形式可视化数据。可谓「一张图片胜过千万行日志」

- Logback:通过Groovy有趣的配置选项的强大的日志库

- 官网:https://logback.qos.ch/

- Logback是由log4j创始人Ceki Gulcu设计的又一个开源日记组件,目标是替代log4j

- Logbook:可扩展的开源库,用于HTTP请求和响应日志记录

- 官网:https://github.com/zalando/logbook

- Logbook是一个可扩展的Java库,可为不同的客户端和服务器端技术提供完整的请求和响应日志记录。 它满足了以下特殊需求:a)允许Web应用程序开发人员记录应用程序接收或发送的任何HTTP流量;b),以便以后易于持久化和分析。 这对于传统的日志分析,满足审计要求或调查各个历史流量问题非常有用

- Logstash:用于管理日志文件的工具

- SLF4J:与实现一起使用的抽象层

- 官网:https://www.slf4j.org/

- 作者又是 Ceki Gulcu!这位大神写了Log4j、Logback和slf4j,专注日志组件开发五百年,一直只能超越自己。用作各种日志框架(例如java.util.logging,logback,log4j)的简单外观或抽象,允许最终用户在部署时插入所需的日志记录框架

- tinylog:具有静态记录器类的轻量级日志框架

- 官网:https://tinylog.org/

- tinylog是一个用于Java和Android的轻量级开源日志记录框架,针对易用性进行了优化

- Tracer:在分布式系统中调用跟踪和日志关联

- 官网:https://github.com/zalando/tracer

- Tracer是一个管理自定义跟踪标识符并通过分布式系统进行管理的库

7、参考资料 & 鸣谢

- 全网最全、最细致的Java日志框架以及门面技术【CSDN Java学术趴】https://blog.csdn.net/chengbaobao520/article/details/120218849

- java日志框架JUL、JCL、Slf4j、Log4j、Log4j2、Logback 一网打尽【CSDN java叶新东老师】https://yexindong.blog.csdn.net/article/details/122010178

JUL日志框架

1、JUL 简单介绍

JUL全称Java util logging是Java原生的日志框架,使用时不需要另外引用第三方类库,相对其他日志框 架使用方便,学习简单,能够在小型应用中灵活使用。

在JUL中有以下组件:

- Loggers:被称为记录器,应用程序通过获取Logger对象,调用其API来来发布日志信息。Logger通常时应用程序访问日志系统的入口程序

- Handlers:也被称为Appenders,每个Logger都会关联一组Handlers,Logger会将日志交给关联的Handler处理,由Handler负责将日志做记录。Handlers在此是一个抽象,其具体的实现决定了日志记录的位置可以是控制台、文件、网络上的其他日志服务或操作系统日志等

- Formatters:也被称为Layouts,它负责对日志事件中的数据进行转换和格式化。它决定了数据在一条日志记录中的最终形式

- Level:日志的输出级别,每条日志消息都有一个关联的级别。我们根据输出级别的设置,来展现最终所呈现的日志信息,根据不同的需求设置不同级别

- Filters:过滤器,根据需要定制哪些信息会被记录,哪些信息会被放过

总结一下就是:

用户使用Logger来进行日志记录,Logger持有若干个Handler,日志的输出操作是由Handler完成的。 在Handler在输出日志前,会经过Filter的过滤,判断哪些日志级别过滤放行哪些拦截,Handler会将日志内容输出到指定位置(日志文件、控制台等)。Handler在输出日志时会使用Layout,将输出内容进行排版。

JUC 流程示意图:

┌──────────────────────────────────────────────────────────────────────────────────────┐

│ LogManager─┐ Level Filter Formatter │

│ ⬇ ⬇ ⬇ ⬇ │

│ Application-------->Logger-------->LogRecord-------->Handler-------->Outside World │

└──────────────────────────────────────────────────────────────────────────────────────┘

┌──────────────────────────────────────────────────────────────────────────────────────┐

│ 应用程序 运行 日志记录器 记录日志 日志处理器 处理日志 │

│ Application-------->Logger---------------->Handler------------------>Outside World │

│ ⬇ ⬇ │

│ ┌──────────────────────────────────────────────────────────────┐ │

│ │Filters(日志过滤器), Formatters(日志格式化组件), Level日志输出级别│ │

│ └──────────────────────────────────────────────────────────────┘ │

└──────────────────────────────────────────────────────────────────────────────────────┘

JUC 总体流程:

- 初始化LogManager,LogManager加载logging.properties配置,添加Logger到LogManager中

- 从单例LogManager获取Logger

- 设置级别Level,并指定日志记录LogRecord

- Filter提供了日志级别之外更细粒度的控制

- Handler是用来处理日志输出位置

- Formatter是用来格式化LogRecord的

JUL 日志原理解析:

- Logger:是用来记录日志的,负责调用其有的Handler进行日志输出

- LogRecord:是用来传递日志的,一条具体的日志对象,比如这条日志所在线程、日志级别,日志名称,日志内容,时间等信息

- Handler:是用来导出(处理)日志的,负责具体的日志输出,有不同的实现类,比如(ConsoleHandler 控制台输出,FileHandler 文件输出)

- Level:是用来定义日志级别的(控制日志输出)

- Filter:提供了日志级别之外更细粒度的控制

- Formatter:是用来格式化LogRecord的,Handler在输出前会调用Formatter 对LogRecord 进行格式化,如简单字符串格式化,Html格式化,XML格式化等

- 此外还有一个单一的全局的LogManager维护Logger和管理日志(LogManager 负责创建日志对象,并将创建的日志对象继承RootLogger的默认配置)。JUL主要由这七个核心类或接口组成,再有就是一些子类或者实现类。API中关于这几个类或接口的类和方法的详细介绍这里不再复述。现在我们已经对JUL有了一个整体的了解,并且对核心类或接口的功能职责也有了初步了解,接下就该结合代码看看JUL的真面目。

在任何日志框架中都会有继承性的概念,在获取Logger对象时,默认会继承RootLogger的配置,但自己的Logger也可以单独设置级别,Handler等。但是如果日志名称是包名进行命名的话,子包默认会继承父包的配置,例如 指定了com.a.b这个包的Handler是ConsoleHandler,Level是info,则com.a.b.c或者 com.a.b.c.d等属于这个包的Logger都会默认继承这个包的配置

2、JUL 入门案例

import java.util.logging.Level;

import java.util.logging.Logger;

public class Test {

//1、获取日志记录器对象

public static Logger logger = Logger.getLogger(Test.class.getName());

public static void main(String[] args) {

/**

* 对于日志输出有两种方式

* 1.一种是指定日志级别方法输出(支持占位符输出)

* 2.另一种是通用方法输出,需要参数指定日志级别(不支持占位符输出)

*/

// 1.通用方法输出,需要参数指定日志级别

logger.log(Level.SEVERE, "this is a severe");

logger.log(Level.WARNING, "this is a warn");

logger.log(Level.INFO, "this is a info"); // JUL默认日志级别,比info高的输出,比info低的过滤掉

logger.log(Level.CONFIG, "this is a config");

logger.log(Level.FINE, "this is a fine");

logger.log(Level.FINER, "this is a finer");

logger.log(Level.FINEST, "this is a finest");

logger.log(Level.INFO, "this is a info", new Exception("My Exception")); // 带异常输出

// 2.指定日志级别方法输出,有不同的级别,可带参数,其它类似

logger.severe("severe log");

logger.warning("warning log");

logger.info("info log"); // JUL默认日志级别,比info高的输出,比info低的过滤掉

logger.config("config log");

logger.fine("fine log");

logger.finer("finer log");

logger.finest("finest log");

// 3.占位符输出, 只有.log()方法是支持占位符输出的

logger.log(Level.WARNING, "this is a warn, {0} ", "p1");

logger.log(Level.INFO, "this is a info, {0} {1}", new Object[]{"p1","p2"});

}

}

// 输出内容

3月 26, 2022 11:21:58 上午 Test main

严重: this is a severe

3月 26, 2022 11:21:58 上午 Test main

警告: this is a warn

3月 26, 2022 11:21:58 上午 Test main

信息: this is a info

3月 26, 2022 11:21:58 上午 Test main

信息: this is a info

java.lang.Exception: My Exception

at Test.main(Test.java:21)

3月 26, 2022 11:21:58 上午 Test main

严重: severe log

3月 26, 2022 11:21:58 上午 Test main

警告: warning log

3月 26, 2022 11:21:58 上午 Test main

信息: info log

3月 26, 2022 11:21:58 上午 Test main

警告: this is a warn, p1

3月 26, 2022 11:21:58 上午 Test main

信息: this is a info, p1 p2

因为默认的日志级别是INFO,所以比INFO级别低的 CONFIG、FINE、FINER、FINEST的日志记录消息没有记录。

3、JUL 组件介绍

JUL常用组件如下:

- Level:日志级别

- Handler:日志输出地

- Formatter:日志格式化

1、Level(日志级别)

日志级别由高到低:OFF/SEVERE/WARNIN/INFO/CONFIG/FINE/FINERG/FINEST/ALL,每个级别有自己的数值,在java.util.logging.Level类中源码如下:

public static final Level OFF = new Level("OFF",Integer.MAX_VALUE, defaultBundle);

public static final Level SEVERE = new Level("SEVERE",1000, defaultBundle);

public static final Level WARNING = new Level("WARNING", 900, defaultBundle);

public static final Level INFO = new Level("INFO", 800, defaultBundle);

public static final Level CONFIG = new Level("CONFIG", 700, defaultBundle);

public static final Level FINE = new Level("FINE", 500, defaultBundle);

public static final Level FINER = new Level("FINER", 400, defaultBundle);

public static final Level FINEST = new Level("FINEST", 300, defaultBundle);

public static final Level ALL = new Level("ALL", Integer.MIN_VALUE, defaultBundle);

- Level.SEVERE:最高级别的日志,主要记录错误信息

- Level.WARNING:级别排行第二,记录警告信息

- Level.INFO:级别排行第三,最常用的日志级别,记录普通消息,比如请求信息、连接信息、参数信息等等

- Level.CONFIG:级别排行第四,记录配置信息,加载配置文件、读取配置参数都可以使用CONFIG记录

- Level.FINE :debug 时记录的 日志消息,记录运行时的状态、传递的参数等等

- Level.FINER:debug 时记录的 日志消息,记录运行时的状态、传递的参数等等

- Level.FINEST:debug 时记录的 日志消息,记录运行时的状态、传递的参数等等

- Level.OFF: 关闭日志记录

- Level.ALL:所有记录都开启

可自定义日志级别:继承java.util.logging.Level类即可

2、Handler(日志输出)

日志输出的目的,java.util.logging包中有如下四种(ConsoleHandler、FileHandler、SocketHandler、MemoryHandler):

- StreamHandler(父类):

- ConsoleHandler:输出到控制台,默认Level为INFO,流为System.err,Formatter为SimpleFormatter

- FileHandler:输出到文件,默认Level为INFO,Formatter为XMLFormatter

- SocketHandler:输出到socket

- MemoryHandler:输出到内存

可自定义日志输出:继承java.util.logging.Handler类即可

3、Formatter(日志格式化)

定义日志输出的格式,目前有SimpleFormatter和XMLFormatter两种格式,分别对应简单格式和xml格式。

注意:默认情况下:ConsoleHandler对应SimpleFormatter,FileHandler对应XMLFormatter。

可自定输出格式:继承抽象类java.util.logging.Formatter即可

4、自定义日志输出

1、自定义输出日志级别(控制台)

Java默认的只能输出3个级别,并且默认的还是输出到控制台。我们现在想要输出其他多个级别,只能自定义输出级别了。自定义的时候,先要关闭默认的。

import java.util.logging.ConsoleHandler;

import java.util.logging.Level;

import java.util.logging.Logger;

import java.util.logging.SimpleFormatter;

public class Test {

public static void main(String[] args) {

// 1.获取日志记录器对象

Logger logger = Logger.getLogger(Test.class.getName());

// 2.关闭系统默认配置(需要自定义日志配置必须关闭)

logger.setUseParentHandlers(false);

// 3.自定义配置日志级别

// 创建ConsoleHandler控制台输出

ConsoleHandler consoleHandler = new ConsoleHandler();

// 创建简单格式转换对象

SimpleFormatter simpleFormatter = new SimpleFormatter();

// 进行关联

consoleHandler.setFormatter(simpleFormatter);

logger.addHandler(consoleHandler);

// 配置日志具体级别,注意:Logger与Handler都需要配置

logger.setLevel(Level.ALL);

consoleHandler.setLevel(Level.ALL);

// 4.日志记录输出,可以发现设置级别为全部输出后,可以在控制台看到所有输出了

logger.severe("severe");

logger.warning("warning");

logger.info("info");

logger.config("config");

logger.fine("fine");

logger.finer("finer");

logger.finest("finest");

}

}

// 输出内容

3月 26, 2022 11:56:15 上午 Test main

严重: severe

3月 26, 2022 11:56:15 上午 Test main

警告: warning

3月 26, 2022 11:56:15 上午 Test main

信息: info

3月 26, 2022 11:56:15 上午 Test main

配置: config

3月 26, 2022 11:56:15 上午 Test main

详细: fine

3月 26, 2022 11:56:15 上午 Test main

较详细: finer

3月 26, 2022 11:56:15 上午 Test main

非常详细: finest

2、自定义日志输出到文件(磁盘)

import java.io.IOException;

import java.util.logging.*;

public class Test {

public static void main(String[] args) throws IOException {

// 1.获取日志记录器对象

Logger logger = Logger.getLogger(Test.class.getName());

// 2.关闭系统默认配置(需要自定义日志配置必须关闭)

logger.setUseParentHandlers(false);

// 自定义配置日志Level、Handler、Formatter

/**

* 创建ConsoleHandler控制台输出

* 并且设置为SimpleFormatter简单格式转换对象(默认就是SimpleFormatter)

* 日志输出级别为ALL全部级别

*/

ConsoleHandler consoleHandler = new ConsoleHandler();

consoleHandler.setFormatter(new SimpleFormatter());

logger.addHandler(consoleHandler);

// 配置Handler日志具体级别

consoleHandler.setLevel(Level.ALL);

/**

* 创建FileHandler文件输出

* 并且设置为SimpleFormatter简单格式转换对象(默认是XMLFormatter)

* 日志输出级别为ALL全部级别

*/

// 第二个参数是日志输出内容追加,注意:目录必须提前存在,否则会抛异常

FileHandler fileHandler = new FileHandler("./logs/jul.log", true);

fileHandler.setFormatter(new SimpleFormatter());

logger.addHandler(fileHandler);

// 配置Handler日志具体级别

fileHandler.setLevel(Level.ALL);

// 配置Logger日志输出级别

logger.setLevel(Level.ALL);

// 3.日志记录输出,以下级别从大到小

logger.severe("severe");

logger.warning("warning");

logger.info("info");

logger.config("config");

logger.fine("fine");

logger.finer("finer");

logger.finest("finest");

}

}

// 输出内容(文件磁盘中也是同样的输出)

3月 26, 2022 12:27:32 下午 Test main

严重: severe

3月 26, 2022 12:27:32 下午 Test main

警告: warning

3月 26, 2022 12:27:32 下午 Test main

信息: info

3月 26, 2022 12:27:32 下午 Test main

配置: config

3月 26, 2022 12:27:32 下午 Test main

详细: fine

3月 26, 2022 12:27:33 下午 Test main

较详细: finer

3月 26, 2022 12:27:33 下午 Test main

非常详细: finest

以上创建了两个Handler,一个是控制台的,一个是文件的,把这个Handler设置到日志记录器对象里面。以后的日志不仅可以输出控制台,还可以输出到文件

可以把文件输出Formatter改成默认的XMLFormatter,观察文件内容

FileHandler fileHandler = new FileHandler("./logs/jul.log", true);

fileHandler.setFormatter(new XMLFormatter()); // 这行代码可写可不写,因为FileHandler默认就是XMLFormatter

输出到文件的内容:

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<!DOCTYPE log SYSTEM "logger.dtd">

<log>

<record>

<date>2022-03-26T04:33:02.178157900Z</date>

<millis>1648269182178</millis>

<nanos>157900</nanos>

<sequence>0</sequence>

<logger>Test</logger>

<level>SEVERE</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>severe</message>

</record>

<record>

<date>2022-03-26T04:33:02.228169900Z</date>

<millis>1648269182228</millis>

<nanos>169900</nanos>

<sequence>1</sequence>

<logger>Test</logger>

<level>WARNING</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>warning</message>

</record>

<record>

<date>2022-03-26T04:33:02.229171100Z</date>

<millis>1648269182229</millis>

<nanos>171100</nanos>

<sequence>2</sequence>

<logger>Test</logger>

<level>INFO</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>info</message>

</record>

<record>

<date>2022-03-26T04:33:02.232172300Z</date>

<millis>1648269182232</millis>

<nanos>172300</nanos>

<sequence>3</sequence>

<logger>Test</logger>

<level>CONFIG</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>config</message>

</record>

<record>

<date>2022-03-26T04:33:02.233171500Z</date>

<millis>1648269182233</millis>

<nanos>171500</nanos>

<sequence>4</sequence>

<logger>Test</logger>

<level>FINE</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>fine</message>

</record>

<record>

<date>2022-03-26T04:33:02.233171500Z</date>

<millis>1648269182233</millis>

<nanos>171500</nanos>

<sequence>5</sequence>

<logger>Test</logger>

<level>FINER</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>finer</message>

</record>

<record>

<date>2022-03-26T04:33:02.234172500Z</date>

<millis>1648269182234</millis>

<nanos>172500</nanos>

<sequence>6</sequence>

<logger>Test</logger>

<level>FINEST</level>

<class>Test</class>

<method>main</method>

<thread>1</thread>

<message>finest</message>

</record>

</log>

5、Logger之间的父子关系

JUL中Logger之间存在父子关系,这种父子关系通过树状结构存储,JUL在初始化时会创建一个顶层RootLogger作为所有Logger父Logger,存储上作为树状结构的根节点。并父子关系通过路径来关联。默认子Logger会继承父Logger的属性。

import java.io.IOException;

import java.util.logging.*;

public class Test {

public static void main(String[] args) throws IOException {

// 1.获取日志记录器对象, logger1 是 logger2 的父对象

Logger logger1 = Logger.getLogger("com");

Logger logger2 = Logger.getLogger("com.controller");

// 2.测试

System.out.println(logger1 == logger2.getParent()); // true

// 所有日志记录器的顶级父元素 LogManager$RootLogger,name 为 ""

System.out.println("logger1 Parent:"+logger1.getParent() + " ,name:" + logger1.getParent().getName());

// 打印logger2的父类logger1的对象与名称

System.out.println("logger2 Parent:"+logger2.getParent() + " ,name:" + logger2.getParent().getName());

// 3.logger1父类:关闭默认配置, 并自定义配置日志级别和设置ConsoleHandler控制台输出

logger1.setUseParentHandlers(false);

ConsoleHandler consoleHandler = new ConsoleHandler();

consoleHandler.setFormatter(new SimpleFormatter());

consoleHandler.setEncoding("UTF-8");

consoleHandler.setLevel(Level.ALL);

logger1.addHandler(consoleHandler);

logger1.setLevel(Level.ALL);

// 4.使用logger2子类输出(查看是否继承父类的属性)

logger2.severe("severe");

logger2.warning("warning");

logger2.info("info");

logger2.config("config");

logger2.fine("fine");

logger2.finer("finer");

logger2.finest("finest");

}

}

// 输出内容

true

logger1 Parent:java.util.logging.LogManager$RootLogger@4b9e13df ,name:

logger2 Parent:java.util.logging.Logger@2b98378d ,name:com

3月 26, 2022 12:57:31 下午 Test main

严重: severe

3月 26, 2022 12:57:31 下午 Test main

警告: warning

3月 26, 2022 12:57:31 下午 Test main

信息: info

3月 26, 2022 12:57:31 下午 Test main

配置: config

3月 26, 2022 12:57:31 下午 Test main

详细: fine

3月 26, 2022 12:57:31 下午 Test main

较详细: finer

3月 26, 2022 12:57:31 下午 Test main

非常详细: finest

从执行结果可以看出子类默认继承了父类Logger的配置。

注意:如果子类不想或者不需要继承父类Logger的配置,只需要关闭子类Logger默认配置,然后重新自定配置即可。

import java.io.IOException;

import java.util.logging.*;

public class Test {

public static void main(String[] args) throws IOException {

// 1.获取日志记录器对象, logger1 是 logger2 的父对象

Logger logger1 = Logger.getLogger("com");

Logger logger2 = Logger.getLogger("com.controller");

// 2.logger1父类:关闭默认配置, 并自定义配置日志级别和设置ConsoleHandler控制台输出

logger1.setUseParentHandlers(false);

ConsoleHandler consoleHandler = new ConsoleHandler();

consoleHandler.setFormatter(new SimpleFormatter());

consoleHandler.setEncoding("UTF-8");

consoleHandler.setLevel(Level.ALL);

logger1.addHandler(consoleHandler);

logger1.setLevel(Level.ALL);

// 3.使用logger2子类输出(查看是否继承父类的属性)

System.out.println("===================如下是继承父类配置的输出==========================");

log(logger2);

// 4.重写自定义logger2的日志配置(不想使用logger1父类继承的配置)

// 注意: 如果没有取消默认配置,那么当前又设置了子类的属性,logs输出会输出2次重复的,因为继承父类输出1次,子类自己输出1次

logger2.setUseParentHandlers(false);

ConsoleHandler consoleHandler2 = new ConsoleHandler();

consoleHandler.setLevel(Level.WARNING);

logger2.addHandler(consoleHandler2);

logger2.setLevel(Level.WARNING);

// 4.使用logger2子类输出(查看是否继承父类的属性)

System.out.println("===================如下是没有继承父类配置的输出==========================");

log(logger2);

}

private static void log(Logger logger2) {

logger2.severe("severe");

logger2.warning("warning");

logger2.info("info");

logger2.config("config");

logger2.fine("fine");

logger2.finer("finer");

logger2.finest("finest");

}

}

// 输出内容

===================如下是继承父类配置的输出==========================

3月 26, 2022 1:06:48 下午 Test log

严重: severe

3月 26, 2022 1:06:48 下午 Test log

警告: warning

3月 26, 2022 1:06:48 下午 Test log

信息: info

3月 26, 2022 1:06:48 下午 Test log

配置: config

3月 26, 2022 1:06:48 下午 Test log

详细: fine

3月 26, 2022 1:06:48 下午 Test log

较详细: finer

3月 26, 2022 1:06:48 下午 Test log

非常详细: finest

===================如下是没有继承父类配置的输出==========================

3月 26, 2022 1:06:48 下午 Test log

严重: severe

3月 26, 2022 1:06:48 下午 Test log

警告: warning

6、JUL自定义配置文件

以上所有配置相关操作都是以Java硬编码的形式进行的的,我们可以使用更加清晰,更加专业的一种做法,就是使用配置文件,如果我们没有自己添加配置文件,则会使用系统(JDK)默认的配置文件。默认配置文件路径$JAVAHOME\jre\lib\logging.properties,默认配置文件内容如下

############################################################

# Default Logging Configuration File

#

# You can use a different file by specifying a filename

# with the java.util.logging.config.file system property.

# For example java -Djava.util.logging.config.file=myfile

############################################################

############################################################

# Global properties

############################################################

# "handlers" specifies a comma separated list of log Handler

# classes. These handlers will be installed during VM startup.

# Note that these classes must be on the system classpath.

# By default we only configure a ConsoleHandler, which will only

# show messages at the INFO and above levels.

handlers= java.util.logging.ConsoleHandler

# To also add the FileHandler, use the following line instead.

#handlers= java.util.logging.FileHandler, java.util.logging.ConsoleHandler

# Default global logging level.

# This specifies which kinds of events are logged across

# all loggers. For any given facility this global level

# can be overriden by a facility specific level

# Note that the ConsoleHandler also has a separate level

# setting to limit messages printed to the console.

.level= INFO

############################################################

# Handler specific properties.

# Describes specific configuration info for Handlers.

############################################################

# default file output is in user's home directory.

java.util.logging.FileHandler.pattern = %h/java%u.log

java.util.logging.FileHandler.limit = 50000

java.util.logging.FileHandler.count = 1

java.util.logging.FileHandler.formatter = java.util.logging.XMLFormatter

# Limit the message that are printed on the console to INFO and above.

java.util.logging.ConsoleHandler.level = INFO

java.util.logging.ConsoleHandler.formatter = java.util.logging.SimpleFormatter

# Example to customize the SimpleFormatter output format

# to print one-line log message like this:

# <level>: <log message> [<date/time>]

#

# java.util.logging.SimpleFormatter.format=%4$s: %5$s [%1$tc]%n

############################################################

# Facility specific properties.

# Provides extra control for each logger.

############################################################

# For example, set the com.xyz.foo logger to only log SEVERE

# messages:

com.xyz.foo.level = SEVERE

自定义配置文件:logging.properties。将该文件保存至resources目录下

# RootLogger顶级父元素指定的默认处理器,多个用逗号分隔

# handlers = java.util.logging.FileHandler,java.util.logging.ConsoleHandler

handlers = java.util.logging.ConsoleHandler

# RootLogger顶级父元素默认的日志级别为:ALL

.level = ALL

# 文件处理器属性设置

# 输出日志文件的路径

java.util.logging.FileHandler.pattern = ./logs/java%u.log

# 输出日志文件的限制(50000字节)

java.util.logging.FileHandler.limit = 50000

# 设置日志文件的数量

java.util.logging.FileHandler.count = 1

# 设置输出日志的格式,默认是以XML方式输出的

java.util.logging.FileHandler.formatter = java.util.logging.SimpleFormatter

# 指定handler对象的日志级别,默认是INFO级别

java.util.logging.FileHandler.level = ALL

# 指定义追加的方式添加日志内容

java.util.logging.FileHandler.append = true

# 控制台处理器属性设置

# 控制台默认输出的格式

java.util.logging.ConsoleHandler.formatter = java.util.logging.SimpleFormatter

# 指定handler对象的字符集编码方式

java.util.logging.ConsoleHandler.encoding = UTF-8

# 控制台输出默认的级别设置(默认是INFO)

java.util.logging.ConsoleHandler.level = ALL

# 指定日志消息格式

#设置日志格式

# java.util.logging.SimpleFormatter.format= %1$tc %2$s%n%4$s: %5$s%6$s%n

java.util.logging.SimpleFormatter.format = %4$s: %5$s [%1$tc]%n

# 自定义Logger使用:包名 + handlers/level

com.xyz.handlers = java.util.logging.ConsoleHandler,java.util.logging.FileHandler

com.xyz.level = SEVERE

# 必须关闭默认设置(只有关闭该配置,自定义设置才能生效,否则还会使用RootLogger的属性配置)

com.xyz.useParentHandlers = false

加载自定义配置文件代码:

package com.xyz;

import java.io.InputStream;

import java.util.logging.LogManager;

import java.util.logging.Logger;

public class Test {

public static void main(String[] args) throws Exception {

// 读取配置文件,通过类加载器

InputStream ins = Test.class.getClassLoader().getResourceAsStream("logging.properties");

// 创建LogManager

LogManager logManager = LogManager.getLogManager();

// 通过LogManager加载配置文件

logManager.readConfiguration(ins);

// 创建日志记录器(当前Logger使用的配置是RootLogger的)

Logger logger = Logger.getLogger("com");

logger.severe("severe");

logger.warning("warning");

logger.info("info");

logger.config("config");

logger.fine("fine");

logger.finer("finer");

logger.finest("finest");

// 创建日志记录器(当前Logger使用的是自己自动配置的, Level配置为severe)

Logger logger2 = Logger.getLogger("com.xyz");

logger2.severe("severe test");

logger2.warning("warning test");

logger2.info("info test");

logger2.config("config test");

logger2.fine("fine test");

logger2.finer("finer test");

logger2.finest("finest test");

}

}

// 输出内容

严重: severe [周六 3月 26 14:57:57 CST 2022]

警告: warning [周六 3月 26 14:57:58 CST 2022]

信息: info [周六 3月 26 14:57:58 CST 2022]

配置: config [周六 3月 26 14:57:58 CST 2022]

详细: fine [周六 3月 26 14:57:58 CST 2022]

较详细: finer [周六 3月 26 14:57:58 CST 2022]

非常详细: finest [周六 3月 26 14:57:58 CST 2022]

严重: severe test [周六 3月 26 14:57:58 CST 2022]

7、JUL自定义组件方式

这里通过继承Level、Handler、Formatter自定义Logger,日志存在文件中,且每个不同的loggerName存不同日志文件中。示例如下,解释请查看注释:

import java.io.File;

import java.io.FileWriter;

import java.io.IOException;

import java.io.PrintWriter;

import java.time.LocalDate;

import java.time.LocalDateTime;

import java.time.format.DateTimeFormatter;

import java.util.logging.*;

public class Test {

/**

* 自定义日志level

*/

public static class SelfLevel extends Level {

public static SelfLevel ERROR = new SelfLevel("ERROR", 910);

/**

* @param name 自定义级别名称

* @param value 自定义级别的权重值

*/

protected SelfLevel(String name, int value) {

super(name, value);

}

}

/**

* 自定义日志格式formatter

*/

public static class SelfFormatter extends Formatter {

@Override

public String format(LogRecord record) {

return String.format("[%s] %s %s.%s: %s\r\n",

LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")),

record.getLevel().getName(),

record.getSourceClassName(),

record.getSourceMethodName(),

record.getMessage());

}

}

/**

* 自定义日志输出handler

*/

public static class SelfHandle extends Handler {

/**

* 日志写入的位置

*/

@Override

public void publish(LogRecord record) {

try {

// 每一个不同的loggerName分别记在不同的日志文件中

File file = new File(String.format("%s_%s.log", record.getLoggerName(),

LocalDate.now().format(DateTimeFormatter.ofPattern("yyyy-MM-dd"))));

if (!file.exists()) {

file.createNewFile();

}

FileWriter fw = new FileWriter(file, true);

PrintWriter pw = new PrintWriter(fw);

String log = String.format("[%s] %s %s.%s: %s\r\n",

LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy-MM-dd HH:mm:ss")),

record.getLevel().getName(),

record.getSourceClassName(),

record.getSourceMethodName(),

record.getMessage());

pw.write(log);

pw.flush();

} catch (IOException e) {

e.printStackTrace();

}

}

/**

* 刷新缓存区,保存数据

*/

@Override

public void flush() {

}

/**

* 关闭

*/

@Override

public void close() throws SecurityException {

}

}

public static void main(String[] args) {

// 创建日志记录器

Logger logger = Logger.getLogger(Test.class.getName());

// 生成日志输出handler实例

logger.addHandler(new SelfHandle());

logger.info("info log");

logger.severe("severe log");

//使用自定义的logger level

logger.log(SelfLevel.ERROR, "error log");

System.out.println("------------------------");

Logger log = Logger.getLogger("com.test");

log.setUseParentHandlers(false);

ConsoleHandler console = new ConsoleHandler();

console.setFormatter(new SelfFormatter());

log.addHandler(console);

log.log(Level.INFO, "selfFormatter test");

}

}

控制台输出内容如下:

3月 27, 2022 6:19:11 下午 Test main

信息: info log

3月 27, 2022 6:19:11 下午 Test main

严重: severe log

3月 27, 2022 6:19:11 下午 Test main

ERROR: error log

------------------------

[2022-03-27 18:19:11] INFO Test.main: selfFormatter test

在项目同级目录会生产文件Test_2022-03-27.log

[2022-03-27 18:19:11] INFO Test.main: info log

[2022-03-27 18:19:11] SEVERE Test.main: severe log

[2022-03-27 18:19:11] ERROR Test.main: error log

8、Logger private static final 为啥?

为什么将 Logger 对象声明为 private static final:

- private:是为了防止其他类使用当前类的日志对象

- static:是为了让每个类中的日志对象只生成一份,是属于类的,不是属于具体的实例的

- final:是为了避免日志对象在运行时被修改

9、参考文献 & 鸣谢

- java日志:一、JUL使用【CSDN:小徐也要努力鸭】https://blog.csdn.net/a232884c/article/details/121103424

- 日志技术之JUL入门【CSDN:StudyWinter】https://blog.csdn.net/Zhouzi_heng/article/details/107943477

- java日志(二)–java官方日志jul的使用【CSDN:panda-star】https://blog.csdn.net/chinabestchina/article/details/104730196

Log4j日志框架

1、Log4j 简单入门

1、简单介绍

Log4j 官方网站: http://logging.apache.org/log4j/1.2/、Maven仓库:https://search.maven.org/search?q=g:log4j

- Log4j =》Log for java,从时间上讲,Log4j 的产生时间要比JUL早

- Log4j 很重要的一个缺陷是不支持占位符,但是用户可自己定义实现占位符的功能

- 从官网或者Maven仓库可以发现 Log4j 最后的版本是1.2.17

Log4j是Apache下的一款开源日志框架,通过使用Log4j,可以控制日志信息输出到控制台、文件、甚至是数据库中。我们可以控制每条日志的输出格式,通过定义日志的输出级别,可以更灵活的控制日志的输出过程,方便项目调试。这些设置可以通过一个配置文件来灵活的进行配置,而不需要修改应用的代码。

2、入门案例

1、建立maven工程并添加依赖

<!--https://search.maven.org/search?q=g:log4j-->

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

<scope>test</scope>

</dependency>

2、默认直接获取Logger对象打印日志,可以发现没有打印我们想要的内容 (是由于我们什么都没有配置,并且Log4j也没有默认配置)

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

/**

* Log4j获取日志记录器对象的两个方法:

* public static Logger getLogger(String name);

* public static Logger getLogger(Class clazz);

*/

Logger logger = Logger.getLogger(Log4jTest.class);

logger.info("hello log4j");

}

}

// 输出内容

log4j:WARN No appenders could be found for logger (Log4jTest).

log4j:WARN Please initialize the log4j system properly.

log4j:WARN See http://logging.apache.org/log4j/1.2/faq.html#noconfig for more info.

注意:如果既没有Java硬编码配置,又没有使用配置文件配置日志输出。默认是没有任何配置,不会输出任何内容

3、使用Log4j提供的初始化默认配置方式

import org.apache.log4j.BasicConfigurator;

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

// 初始化配置信息,在入门案例中暂不使用配置文件

BasicConfigurator.configure();

/**

* Log4j获取日志记录器对象的两个方法:

* public static Logger getLogger(String name);

* public static Logger getLogger(Class clazz);

*/

Logger logger = Logger.getLogger(Log4jTest.class);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); // 记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

// 输出内容

0 [main] FATAL Log4jTest - fatal test

0 [main] ERROR Log4jTest - error test

0 [main] WARN Log4jTest - warn test

0 [main] INFO Log4jTest - info test

0 [main] DEBUG Log4jTest - debug test

可以发现只打印出了TRACE没有打印出来,是由于默认日志级别为DEBUG,低于DEBUG级别的是不会打印出来

2、Log4j 组件介绍

Log4j主要由Loggers(日志记录器)、Appenders(输出端)和Layout(日志格式化器)组成,其中Loggers控制日志的输出级别与日志是否输出;Appenders指定日志的输出方式(输出到控制台、文件等);Layout控制日志信息的输出格式。

1、Loggers

日志记录器,负责收集处理日志记录,实例的命名就是类”xx”的full quailied name(类的全限定名),Logger的名字大小写敏感,其命名有继承机制。例如:name为org.apache.commoms的logger会继承name为org.apache的logger。

Log4j中有一个特殊的logger叫做”root”,它是所有logger的根,也就意味着其他所有的logger都会直接或者间接的继承自root。root logger可以用Logger.getRootLogger()方法获取。JUL也有一个名为”.“的根。

PS:自Log4j 1.2版以来, Logger 类已经取代了 Category 类。对于熟悉早期版本的Log4j的人来说,Logger 类可以被视为 Category 类的别名。

2、Appenders

Appender 用来指定日志输出到哪个地方(和JUL的Handler很像),可以同时指定日志的输出目的地。Log4j 常用的输出目的地。有以下几种:

| 输出端类型 | 作用 |

|---|---|

| ConsoleAppender | 将日志输出到控制台 |

| FileAppender | 将日志输出到文件中 |

| DailyRollingFileAppender | 将日志输出到一个日志文件,并且每天输出到一个新的文件 |

| RollingFileAppender | 将日志信息输出到一个日志文件,并且指定文件的尺寸,当文件大小达到指定尺寸时,会自动把文件改名,同时产生一个新的文件 |

| JDBCAppender | 把日志信息保存到数据库中 |

3、Layouts

Layouts 布局器,用于控制日志输出的格式,让我么可以自定义日志格式,Log4j 常用的 Layouts 有以下几种

| 格式化器 | 作用 |

|---|---|

| HTMLLayout | 格式化日志为html表格形式 |

| XMLLayout | 格式化日志为xml文档形式 |

| SimpleLayout | (默认)简单的日志输出格式化,打印的日志格式为(info - message) |

| PatternLayout | 最强大的格式化器,可以根据自定义格式输出日志,如果没有指定转换格式,默认的格式只显示消息内容; |

4、日志输出格式

使用PatternLayout可以自定义格式输出,是我们最常用的方式,这种格式化输出采用类似C语言的printf函数的打印格式化日志信息,具体占位符及含义如下:

| 参数 | 说明 | 举例 |

|---|---|---|

%m |

输出代码中指定的日志信息 | logger.info(日志信息) |

%p |

输出日志级别 | INFO、DEBUG、ERROR %-8p 表示占用8个字符,若字符不够用空格代替 |

%n |

换行符 | 必须在结尾加上换行符,否则日志将杂乱不堪 |

%r |

输出从应用启动到输出该log信息耗费的毫秒数 | log打印时间 - 应用启动时间 |

%c |

输出打印语句所属的类全名 | %c :com.xd.App %c{1}:App |

%C |

列出调用logger的类的全名(包含包路径) | %C :com.xd.App %C{1}:App |

%t |

输出产生该日志所在的线程名名称 | main 、thread-0、thread-1 |

%d |

输出服务器当前时间,精确到豪秒 | 输出服务器当前时间, 默认为ISO8601, 也可指定格式:%d{yyyy-MM-dd HH:mm:ss} |

%l |

输出日志发生的位置,包含包、类、方法、代码行数 | com.log.App.haveConfigFile(App.java:25) |

%L |

输出代码中的行号 | 12 |

%F |

显示调用logger的类的文件名 | App.class |

%% |

输出一个百分号 % | % |

%* 可以在 % 与字符之间加上修饰符来控制最小宽度、最大宽度和文本的对其方式。如:

%5c 输出category名称,最小宽度是5,category<5,默认的情况下右对齐

%-5c 输出category名称,最小宽度是5,category<5,"-"号指定左对齐,会有空格

%.5c 输出category名称,最大宽度是5,category>5,就会将左边多出的字符截掉,<5不会有空格

%20.30c category名称<20补空格,并且右对齐,>30字符,就从左边交远销出的字符截掉

5、日志输出级别

关于日志级别信息,例如:DEBUG、INFO、WARN、ERROR…级别是分大小的,DEBUG < INFO < WARN < ERROR,分别用来指定这条日志信息的重要程度,Log4j 输出日志的规则是:只输出级别不低于设定级别的日志信息,假设 Loggers 级别设定为 INFO,则 INFO、WARN、ERROR 级别的日志信息都会输出,而级别低于 INFO 的 DEBUG 则不会输出。

Log4j 的默认日志级别是:DEBUG

- OFF:最高等级的而级别,用户关闭所有的日志记录

- FATAL:严重的错误信息,一般会造成系统崩溃并终止运行

- ERROR:记录错误信息,不会影响系统运行。一般情况不想输出太多日志,则使用该级别即可

- WARN:记录警告信息

- INFO:记录运行信息

- DEBUG:(默认)记录调式信息,一般在开发中使用

- TRACE:记录追踪信息,记录程序的流程信息,一般情况不会使用

- ALL:最低等级,用于打开所有级别的日志记录

注:一般只使用4个级别,优先级从高到低为 ERROR > WARN > INFO > DEBUG

3、硬编码与配置文件

1、Java硬编码配置

1、Java代码配置:Appenders使用ConsoleAppender,Layouts使用SimpleLayout。

import org.apache.log4j.ConsoleAppender;

import org.apache.log4j.Level;

import org.apache.log4j.Logger;

import org.apache.log4j.SimpleLayout;

import java.io.PrintWriter;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

// 配置一个控制台输出源

ConsoleAppender consoleAppender = new ConsoleAppender(new SimpleLayout());

consoleAppender.setName("console");

consoleAppender.setWriter(new PrintWriter(System.out));

logger.addAppender(consoleAppender);

logger.setLevel(Level.ERROR);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); // 记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

// 输出内容

FATAL - fatal test

ERROR - error test

2、Java代码配置,Appenders使用ConsoleAppender,Layouts使用自定义Layout。

import org.apache.log4j.*;

import org.apache.log4j.spi.LoggingEvent;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

// 配置一个自定义Layout(自定义格式化输出)

Layout layout = new Layout() {

@Override

public String format(LoggingEvent loggingEvent) {

// loggingEvent.getLoggerName()输出包名+类名

return loggingEvent.getLoggerName() + " " + loggingEvent.getMessage() + "\r\n";

}

@Override

public boolean ignoresThrowable() {

return false;

}

@Override

public void activateOptions() {

}

};

// 配置一个控制台输出源

ConsoleAppender consoleAppender = new ConsoleAppender(layout);

consoleAppender.setName("customConsole");

logger.addAppender(consoleAppender);

logger.setLevel(Level.ERROR);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); //记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

// 输出内容

Log4jTest fatal test

Log4jTest error test

3、注意如下两个配置,需要的时候可以配置

// 初始化配置信息(没有使用使用配置文件情况下)

BasicConfigurator.configure();

// 开启Log4j内置日志记录(用来打印Log4j更加详细的debug信息)

LogLog.setInternalDebugging(true);

2、加载配置文件

通过查看LogManager源码可知log4j是通过静态代码块中,类加载器加载的配置文件,所以可以在resources下新建一个log4j.properties文件:

# 指定日志的输出级别与输出端

# WARN代表的是输出级别, console是我们自定义的一个名称appenderNam, 这个可以设置打印到多个地方, 中间用逗号隔开

log4j.rootLogger = WARN,console

# 配置appender输出方法及配置输出信息的格式

log4j.appender.console = org.apache.log4j.ConsoleAppender

log4j.appender.console.layout = org.apache.log4j.SimpleLayout

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); //记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

// 输出内容

FATAL - fatal test

ERROR - error test

WARN - warn test

4、Appender输出详解

1、将日志输出到控制台

ConsoleAppender:将日志输出到控制台

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,console

############################# 控制台输出配置 #############################

# 1、指定控制台日志输出的appender

log4j.appender.console = org.apache.log4j.ConsoleAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式xml.XMLLayout

log4j.appender.console.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容

#log4j.appender.console.layout.conversionPattern = %r [%t] %p %c %x - %m%n

log4j.appender.console.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); // 记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

控制台中输出如下内容

[FATAL] 0 Log4jTest.main(Log4jTest.java:6) 2022-03-30 15:09:46:620 fatal test

[ERROR] 0 Log4jTest.main(Log4jTest.java:7) 2022-03-30 15:09:46:620 error test

[WARN] 0 Log4jTest.main(Log4jTest.java:8) 2022-03-30 15:09:46:620 warn test

[INFO] 0 Log4jTest.main(Log4jTest.java:9) 2022-03-30 15:09:46:620 info test

2、将日志输出到指定文件

FileAppender:将日志输出到文件中

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,file

############################# 文件输出配置 #############################

# 2、指定文件日志输出的appender【默认是追加的】

log4j.appender.file = org.apache.log4j.FileAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式XMLLayout

log4j.appender.file.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容 (%r [%t] %p %c %x - %m%n)

log4j.appender.file.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

# 指定日志文件的保存路径

log4j.appender.file.file = ./logs/log4j.log

# 指定日志文件的字符集

log4j.appender.file.encoding = UTF-8

此时这个日志信息会输出到这个指定位置的文件中。项目同级目录下会自动创建目录与文件(logs/log4j.log)输出内容如下:

[FATAL] 0 Log4jTest.main(Log4jTest.java:6) 2022-03-30 15:09:46:620 fatal test

[ERROR] 0 Log4jTest.main(Log4jTest.java:7) 2022-03-30 15:09:46:620 error test

[WARN] 0 Log4jTest.main(Log4jTest.java:8) 2022-03-30 15:09:46:620 warn test

[INFO] 0 Log4jTest.main(Log4jTest.java:9) 2022-03-30 15:09:46:620 info test

3、根据时间来拆分日志文件

DailyRollingFileAppender:将日志输出到一个日志文件,并且每天输出到一个新的文件

这个会根据你输入的时间间隔来生成新的日志信息,这个时间可以是一天,也可以是一秒,需要注意的是这个并不是自动为我们生成新的日志文件,是我们手动生成的日志文件,比如:你设置的间隔是 yyyy-MM-dd ,这个时候如果你现在输出了一个日志文件,那么在这个时间开始的后24个小时内都不会生成新的日志文件,在这24小时内输出的日志文件都会存储到这个一个旧的日志文件中。即使过了24个小时,系统也不会为我们自动生成一个新的日志文件,需要程序员在输出日志的时候才会生成一个新的日志文件,加可以精确到秒,那么一秒就会为我们生成一个新的日志文件。

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,dailyFile

############################# 按照时间规则输出到文件 #############################

# 3、按日期日志文件输出的appender【在这个类中没有提供覆盖的方法】

log4j.appender.dailyFile = org.apache.log4j.DailyRollingFileAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式XMLLayout

log4j.appender.dailyFile.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容

log4j.appender.dailyFile.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

# 指定日志文件的保存路径【当前文件默认是覆盖的】

log4j.appender.dailyFile.file = ./logs/log4j.log

# 指定日志文件的字符集

log4j.appender.dailyFile.encoding = UTF-8

# 指定日期拆分规则 默认【'.'yyyy-MM-dd】时间pattern只能以短横线-划分

log4j.appender.dailyFile.datePattern = '.'yyyy-MM-dd-HH-mm-ss

多次执行测试类,这时可以发现指定路径下会按照时间秒生产日志文件(log4j.log 中文件是覆盖的,log4j.log.xxx文件在同一个时间内是追加的)

log4j.log

log4j.log.2022-03-30-15-46-12

log4j.log.2022-03-30-15-46-14

在测试时可以根据秒来指定拆分策略,但实际生产环境中,我们可以根据按天或者周、月进行拆分。

4、根据文件大小拆分日志文件

RollingFileAppender:将日志信息输出到一个日志文件,并且指定文件的尺寸,当文件大小达到指定尺寸时,会自动把文件改名,同时产生一个新的文件

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,rollingFile

############################# 按照文件大小拆分输出到文件 #############################

# 4、按照文件大小拆分的appender

log4j.appender.rollingFile = org.apache.log4j.RollingFileAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式XMLLayout

log4j.appender.rollingFile.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容

log4j.appender.rollingFile.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

# 指定日志文件的保存路径

log4j.appender.rollingFile.file = ./logs/log4j.log

# 指定日志文件的字符集

log4j.appender.rollingFile.encoding = UTF-8

# 指定日志文件内容的大小【这里为了测试所以1KB】

log4j.appender.rollingFile.maxFileSize = 1KB

# 指定日志文件的数量【默认是1个】 超过5个,按照时间覆盖(最旧的文件覆盖最新的文件)

log4j.appender.rollingFile.maxBackupIndex = 5

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

for (int i = 0; i < 100; i++) {

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); // 记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

}

}

}

只要文件超过1KB,那么则生成另一个文件,文件的数量最多5个。如果5个文件啊不够怎么办,作为日志管理来讲,不可能让日志无休止的增长,所以覆盖策略是:按照时间来进行覆盖,原则是保留新的,覆盖旧的。这个时候日志6会覆盖掉日志1.

log4j.log

log4j.log.1

log4j.log.2

log4j.log.3

log4j.log.4

log4j.log.5

5、将日志信息存储到数据库

JDBCAppender:把日志信息保存到数据库中

数据库这里需要新建数据库,加入数据库的依赖,然后在配置文件中配置连接数据库的信息并且设置插入语句。

-- create table

CREATE TABLE tab_log (

log_id int(11) NOT NULL AUTO_INCREMENT,

project_name varchar(255) DEFAULT NULL COMMENT '目项名',

create_date varchar(255) DEFAULT NULL COMMENT '创建时间',

level varchar(255) DEFAULT NULL COMMENT '优先级',

category varchar(255) DEFAULT NULL COMMENT '所在类的全名',

file_name varchar(255) DEFAULT NULL COMMENT '输出日志消息产生时所在的文件名称',

thread_name varchar(255) DEFAULT NULL COMMENT '日志事件的线程名',

line varchar(255) DEFAULT NULL COMMENT '号行',

all_category varchar(255) DEFAULT NULL COMMENT '日志事件的发生位置',

message varchar (4000) DEFAULT NULL COMMENT '输出代码中指定的消息',

PRIMARY KEY (log_id)

);

<!--mysql依赖-->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.9</version>

</dependency>

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,logDB

############################# 将日志信息存储到数据库 #############################

# 5、持久化日志信息 将日志信息存储到数据库的appender

log4j.appender.logDB = org.apache.log4j.jdbc.JDBCAppender

log4j.appender.logDB.layout = org.apache.log4j.PatternLayout

log4j.appender.logDB.Driver = com.mysql.jdbc.Driver

log4j.appender.logDB.URL = jdbc:mysql://localhost/tab_log

log4j.appender.logDB.User = root

log4j.appender.logDB.Password = password

# 此时要像数据库中插入数据,使用insert语句

log4j.appender.logDB.Sql = INSERT INTO tab_log(name,create,level,category,fileName,message) values('project_log','%d{yyyy-MM-dd HH:mm:ss}','%p','%c','%F','%m')

然后执行测试类,可以查看到数据中成功插入日志。

6、将日志信息输出到多个位置

上面分别介绍了单个Appender的用法,实际上我们还可以将日志同时输出到多个Appender中。下面示例同时输出到控制台、文件与数据库中

# 指定日志的输出级别与输出端

# 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger=INFO,console,file,logDB

############################# 控制台输出配置 #############################

# 1、指定控制台日志输出的appender

log4j.appender.console = org.apache.log4j.ConsoleAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式xml.XMLLayout

log4j.appender.console.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容

#log4j.appender.console.layout.conversionPattern = %r [%t] %p %c %x - %m%n

log4j.appender.console.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd- HH:mm:ss:SSS} %m%n

############################# 文件输出配置 #############################

# 2、指定文件日志输出的appender【默认是追加的】

log4j.appender.file = org.apache.log4j.FileAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式XMLLayout

log4j.appender.file.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容 (%r [%t] %p %c %x - %m%n)

log4j.appender.file.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

# 指定日志文件的保存路径

log4j.appender.file.file = ./logs/log4j.log

# 指定日志文件的字符集

log4j.appender.file.encoding = UTF-8

############################# 将日志信息存储到数据库 #############################

# 5、持久化日志信息 将日志信息存储到数据库的appender

log4j.appender.logDB = org.apache.log4j.jdbc.JDBCAppender

log4j.appender.logDB.layout = org.apache.log4j.PatternLayout

log4j.appender.logDB.Driver = com.mysql.jdbc.Driver

log4j.appender.logDB.URL = jdbc:mysql://localhost/tab_log

log4j.appender.logDB.User = root

log4j.appender.logDB.Password = password

# 此时要像数据库中插入数据,使用insert语句

log4j.appender.logDB.Sql = INSERT INTO tab_log(name,create,level,category,fileName,message) values('project_log','%d{yyyy-MM-dd HH:mm:ss}','%p','%c','%F','%m')

实际上主要是对这个配置的修改:

# 指定日志的输出级别与输出端, 第1个逗号前是设置的日志级别,后面是自定义名称,输出到什么地方.名称在下方使用

log4j.rootLogger = info,console,file

5、自定义配置Logger

# 使用最高父类rootLogger配置logger,这个时候继承的是父logger(根节点)

log4j.rootLogger = info,console

# 配置自定义loggerlogger对象,会默认继承rootLogger

# 级别会覆盖, INFO升级为WARN. Appender会继承, 既会向控制台输出console, 也会向文件file输出

# 注意:这里自定义的com.xyz是Log4jTest类所在的包名路径

log4j.logger.com.xyz = warn,file

# 第三方框架(org.apache.log4j.Logger)的错误日志打印,不指定appender,就是默认rootLogger的appender(console)

log4j.logger.org.apache = error

############################# 控制台输出配置 #############################

# 1、指定控制台日志输出的appender

log4j.appender.console = org.apache.log4j.ConsoleAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式xml.XMLLayout

log4j.appender.console.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容

#log4j.appender.console.layout.conversionPattern = %r [%t] %p %c %x - %m%n

log4j.appender.console.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

############################# 文件输出配置 #############################

# 2、指定文件日志输出的appender【默认是追加的】

log4j.appender.file = org.apache.log4j.FileAppender

# 指定消息格式layout,使用简单格式SimpleLayout ,HTML格式HTMLLayout,xml格式XMLLayout

log4j.appender.file.layout = org.apache.log4j.PatternLayout

# 指定消息格式的内容 (%r [%t] %p %c %x - %m%n)

log4j.appender.file.layout.conversionPattern =[%p] %r %l %d{yyyy-MM-dd HH:mm:ss:SSS} %m%n

# 指定日志文件的保存路径

log4j.appender.file.file = ./logs/log4j.log

# 指定日志文件的字符集

log4j.appender.file.encoding = UTF-8

package com.xyz;

import org.apache.log4j.Logger;

public class Log4jTest {

public static void main(String[] args) {

Logger logger = Logger.getLogger(Log4jTest.class);

logger.fatal("fatal test"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger.error("error test"); // 记录错误信息,不会影响系统运行

logger.warn("warn test"); // 记录警告信息

logger.info("info test"); // 记录运行信息

logger.debug("debug test"); // (默认)记录调式信息,一般在开发中使用

logger.trace("trace test"); // 记录追踪信息,记录程序的流程信息

// 三方框架的错误日志信息打印

// 因为log4j.properties文件中appender名是类名的包路径,

// 这里是org.apache.log4j.Logger,就可以继承log4j.properties的配置

Logger logger2 = Logger.getLogger(Logger.class);

logger2.fatal("fatal test2"); // 记录严重的错误信息,一般会造成系统崩溃并终止运行

logger2.error("error test2"); // 记录错误信息,不会影响系统运行

logger2.warn("warn test2"); // 记录警告信息

logger2.info("info test2"); // 记录运行信息

logger2.debug("debug test2"); // (默认)记录调式信息,一般在开发中使用

logger2.trace("trace test2"); // 记录追踪信息,记录程序的流程信息

}

}

控制台输出:

[FATAL] 0 com.xyz.Log4jTest.main(Log4jTest.java:7) 2022-03-30 17:58:48:215 fatal test

[ERROR] 10 com.xyz.Log4jTest.main(Log4jTest.java:8) 2022-03-30 17:58:48:225 error test

[WARN] 10 com.xyz.Log4jTest.main(Log4jTest.java:9) 2022-03-30 17:58:48:225 warn test

[FATAL] 10 com.xyz.Log4jTest.main(Log4jTest.java:19) 2022-03-30 17:58:48:225 fatal test2

[ERROR] 10 com.xyz.Log4jTest.main(Log4jTest.java:20) 2022-03-30 17:58:48:225 error test2

文件中输出:

[FATAL] 0 com.xyz.Log4jTest.main(Log4jTest.java:7) 2022-03-30 17:58:48:215 fatal test

[ERROR] 10 com.xyz.Log4jTest.main(Log4jTest.java:8) 2022-03-30 17:58:48:225 error test

[WARN] 10 com.xyz.Log4jTest.main(Log4jTest.java:9) 2022-03-30 17:58:48:225 warn test

可以看出:file中不会存入org.apache这个logger的日志,因为该logger没有指定appender,默认的rootLogger的appender只是输出到控制台的

自定义Logger结论:如果根节点的Logger和自定义父Logger配置的输出位置是不同的则取二者的并集,也就是配置的位置都会进行日志的输出。如果二者配置的日志级别不同,主要以按照我们自定义的父logger的级别输出为主。

6、参考文献 & 鸣谢

- 日志技术之Log4j学习【CSDN:StudyWinter】https://blog.csdn.net/Zhouzi_heng/article/details/107965987

- java日志:二、log4j使用【CSDN:小徐也要努力鸭】https://blog.csdn.net/a232884c/article/details/121102525

日志门面统一技术

1、日志门面介绍

1、什么是日志门面技术

日志门面技术借鉴了 JDBC 的思想,为日志系统也提供了一套门面,开发者就可以面向这些接口规范来开发,避免了直接依赖具体日志框架,因为不同的日志框架有不同的用法,所以导致在更换日志框架时就需要改动大量的代码,所以为了减少开发量,就有了日志门面技术,门面技术简单地理解就是说你的日志框架变了,但是不需要改代码,只修改依赖和配置文件即可,提高了开发效率

- 常见的日志门面: JCL、SLF4J

- 常见的日志实现: JUL、Log4j、Logback、Log4j2

- 日志框架出现的历史顺序:Log4j » JUL » JCL » SLF4J » Logback » Log4j2

- 常用门面及实现组合:slf4j + logback、slf4j + log4j2

因为JCL支持的日志框架比较少,只支持目前比较主流的日志框架,且不支持扩展,需要扩展其他的日志实现技术的话需要用户自己修改源代码,但是随着技术的发展,以后肯定会发展出更多更好的日志框架,但JCL却不支持这些新出的框架,因此JCL在2014年就已经被 Apache 给淘汰了,目前使用最广泛的是SLF4J

2、为什么要用门面技术

- 面向接口开发,不在依赖具体的实现类,减少代码的耦合

- 项目通过导入不同的日志实现类,可以灵活的切换日志框架

- 统一API,方便开发者学习和使用

- 统一配置便于项目日志的管理

2、日志门面SLF4J

官网:https://www.slf4j.org/、Maven 仓库地址:https://search.maven.org/artifact/org.slf4j/slf4j-api

简单日志门面(Simple Logging Facade For Java)主要是为了给Java日志访问提供一套标准、规范的API框架,其主要意义在于提供接口,具体的实现可以交由其它日志框架,例如log4j和logback等。当然slf4j自己也提供了功能较为简单的实现,但是一般很少用到。对于一般的java项目而言,日志框架会选择slf4j-api作为门面,配上具体的实现框架(log4j、logback等),中间使用桥接器完成桥接。并且类路径要绑定具体的日志实现框架(Logback、Log4j、Log4j2、JUL),否则无操作去实现,因为SLF4J只是接口。

SLF4J是目前市面上最流行的日志门面。现在的项目中基本上都是使用SLF4J。主要提供两大功能:

- 日志框架的绑定(Binding):绑定其他日志的实现

- 日志框架的桥接(Bridging):桥接旧的日志框架

┌ 日志桥接绑定 日志实现组件

├ loback-classic-version.jar »»» logback

日志门面 ├ slf4j-log4j12-version.jar »»» log4j

client »»» slf4j-api »»» ├ slf4j-jdk14-version.jar »»» jul(jdk)

├ slf4j-jcl-version.jar »»» jcl

├ slf4j-simple-version.jar »»» slf4j simple

└ slf4j-nop-version.jar »»» slf4j nop

1、核心接口或类 & 日志级别

核心接口或类:

- org.slf4j.Logger:核心接口(包含了日志操作的方法)

- org.slf4j.LoggerFactory:工厂类,获取日志实例

LoggerFactory:位于slf4j-api.jar包中,是一个用于生产各种Logger的工厂,有3个公共方法。

| 方法名称 | 含义 |

|---|---|

| getILoggerFactory | 返回logger工厂,getLogger方法内部会调用该方法 |

| getLogger(Class<?> clazz) | 通过clazz查找具体的logger |

| getLogger(String name) | 通过name查找具体的logger |

日志级别有5类,分别是ERROR、WARN、INFO、DEBUG、TRACE。源码如下:

ERROR(ERROR_INT, "ERROR"),

WARN(WARN_INT, "WARN"),

INFO(INFO_INT, "INFO"),

DEBUG(DEBUG_INT, "DEBUG"),

TRACE(TRACE_INT, "TRACE");

final public int TRACE_INT = 00;

final public int DEBUG_INT = 10;

final public int INFO_INT = 20;

final public int WARN_INT = 30;

final public int ERROR_INT = 40;

2、绑定默认日志实现 Binding

1、单独使用SLF4J

直接使用SLF4J日志门面,不加日志实现框架

<!-- slf4j 日志门面 -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

public class SLF4JTest {

public static void main(String[] args) {

Logger logger = LoggerFactory.getLogger(SLF4JTest.class);

logger.error("error test");

logger.warn("warn test");

logger.info("info {}", "test");

logger.debug("debug test ");

logger.trace("trace test");

}

}

因为目前只有接口,还没有具体的实现,此时还不会打印内容,会打印提示您没有实现类

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder".

SLF4J: Defaulting to no-operation (NOP) logger implementation

SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details.

2、SLF4J日志开关

slf4j-nop是slf4j开关,加上该依赖,重新执行Test,既不会打印内容,也不会提示

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-nop</artifactId>

<version>1.7.32</version>

</dependency>

3、绑定默认日志框架

slf4j-simple是slf4j内置的简单日志实现框架,功能比较简单

<!--slf4j 日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--slf4j 内置的简单实现-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-simple</artifactId>

<version>1.7.32</version>

</dependency>

运行上述代码,控制台打印的结果如下

[main] ERROR SLF4JTest - error test

[main] WARN SLF4JTest - warn test

[main] INFO SLF4JTest - info test

3、绑定其他日志实现 Binding

如前所述,SLF4J支持各种日志框架。SLF4J发行版附带了几个称为“SLF4J绑定”的jar文件,每个绑定对应一个受支持的框架。使用SLF4J的日志绑定流程**:**

- 添加slf4j-api的依赖

- 使用slf4j的API在项目中进行统一的日志记录

- 绑定具体的日志实现框架

- 绑定已经实现了slf4j的日志框架,直接添加对应依赖

- 绑定没有实现slf4j的日志框架,先添加日志的适配器,再添加实现类的依赖

- slf4j有且仅有一个日志实现框架的绑定(如果出现多个默认使用第一个依赖日志实现)

打开官网的用户手册查看流程图:https://www.slf4j.org/manual.html

1、绑定JUL日志实现

<!--slf4j 日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--JUL适配器依赖,因为JUL是JDK内置的,所以不需要额外导入JUL实现的依赖-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-jdk14</artifactId>

<version>1.7.32</version>

</dependency>

运行上述代码,控制台打印的结果如下

3月 31, 2022 10:07:14 上午 SLF4JTest main

严重: error test

3月 31, 2022 10:07:14 上午 SLF4JTest main

警告: warn test

3月 31, 2022 10:07:14 上午 SLF4JTest main

信息: info test

2、绑定Log4j日志框架

<!--slf4j 日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--导入log4j适配器依赖-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.32</version>

</dependency>

<!--导入log4j依赖-->

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

除此之外,还需要加上log4j的配置文件(main/resources目录下):log4j.properties

# 使用根节点的logger对象, 将日志信息输出到控制台

log4j.rootLogger = info,console

log4j.appender.console = org.apache.log4j.ConsoleAppender

log4j.appender.console.layout = org.apache.log4j.PatternLayout

log4j.appender.console.layout.conversionPattern = [%p]%r %c%t%d{yyyy-mm-dd HH:mm:ss:SSS} %m%n

运行上述代码,控制台打印的结果如下

[ERROR]0 SLF4JTestmain2022-16-31 10:16:50:961 error test

[WARN]0 SLF4JTestmain2022-16-31 10:16:50:961 warn test

[INFO]10 SLF4JTestmain2022-16-31 10:16:50:971 info test

3、日志实现框架切换

要切换日志框架,只需替换类路JUL切换到Log4j,只需将 slf4j-jdk14-1.7.32.jar 替换为 slf4j-log4j12-1.7.32.jar 即可。

SLF4J不依赖于任何特殊的类装载。实际上,每个SLF4J绑定在编译时都是硬连线的, 以使用一个且只有一个特定的日志记录框架。例如:slf4j-log4j12-1.7.32.jar绑定在编译时绑定以使用log4j。

4、桥接旧的日志框架 Bridging

通常,您依赖的某些组件依赖于SLF4J以外的日志记录API。您也可以假设这些组件在不久的将来不会切换到SLF4J。为了解决这种情况,SLF4J附带了几个桥接模块,这些模块将对log4j、JCL和java.util.loggingAPI的调用重定向,就好像它们是SLF4J的API一样。

桥接解决的是项目中日志的遗留问题,当系统中存在之前的日志API,可以通过桥接转换到slf4j的实现:

- 先去除之前老的日志框架的依赖,必须去掉

- 添加SLF4J提供的桥接组件,这个组件就是模仿之前老的日志写了一套相同的api,只不过这个api是在调用SLF4J的api

- 为项目添加SLF4J的具体实现(如Logback)

1、SLF4J桥接器介绍

旧日志迁移方式:

<!--slf4j 日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--桥接的组件,加上这个依赖后,虽然import上是log4j,但是底层调用的其实是logback的日志实现;-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>log4j-over-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

<!--Logback 日志实现依赖-->

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-classic</artifactId>

<version>1.2.5</version>

</dependency>

SLF4J提供的桥接器:

<!-- log4j-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>log4j-over-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

<!-- jul -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>jul-to-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

<!--jcl -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>jcl-over-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

注意问题:

- log4j-over-slf4j 桥接器 和 slf4j-jcl.jar 适配器 不能同时部署,否则会导致无限循环

前一个jar文件将导致JCL将日志系统的选择委托给SLF4J,后一个jar文件将导致SLF4J将日志系统的选择委托给JCL,从而导致无限循环 - log4j-over-slf4j 桥接器 和 slf4j-log4j 适配器 不能同时出现

- jul-to-slf4j.jar 桥接器和 slf4j-jdk14.jar 适配器 不能同时出现

- 所有的桥接器都只对Logger日志记录器对象有效,如果程序中调用了内部的配置类或者是Appender、Filter等对象,将无法产生效果

模拟同时导入log4j 适配器与桥接器 导致死循环 示例:

<!--slf4j日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--配置log4j的桥接器-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>log4j-over-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

<!--配置log4j的适配器-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.32</version>

</dependency>

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

public class SLF4JTest {

public static void main(String[] args) {

Logger logger = LoggerFactory.getLogger(SLF4JTest.class);

logger.error("error test");

logger.warn("warn test");

logger.info("info test");

logger.debug("debug test ");

logger.trace("trace test");

}

}

SLF4J: Detected both log4j-over-slf4j.jar AND bound slf4j-log4j12.jar on the class path, preempting StackOverflowError.

SLF4J: See also http://www.slf4j.org/codes.html#log4jDelegationLoop for more details.

Exception in thread "main" java.lang.ExceptionInInitializerError

at org.slf4j.impl.StaticLoggerBinder.<init>(StaticLoggerBinder.java:72)

at org.slf4j.impl.StaticLoggerBinder.<clinit>(StaticLoggerBinder.java:45)

at org.slf4j.LoggerFactory.bind(LoggerFactory.java:150)

at org.slf4j.LoggerFactory.performInitialization(LoggerFactory.java:124)

at org.slf4j.LoggerFactory.getILoggerFactory(LoggerFactory.java:417)

at org.slf4j.LoggerFactory.getLogger(LoggerFactory.java:362)

at org.apache.log4j.Category.<init>(Category.java:57)

at org.apache.log4j.Logger.<init>(Logger.java:37)

at org.apache.log4j.Log4jLoggerFactory.getLogger(Log4jLoggerFactory.java:43)

at org.apache.log4j.Logger.getLogger(Logger.java:41)

at org.apache.log4j.Logger.getLogger(Logger.java:49)

at SLF4JTest.main(SLF4JTest.java:6)

Caused by: java.lang.IllegalStateException: Detected both log4j-over-slf4j.jar AND bound slf4j-log4j12.jar on the class path, preempting StackOverflowError. See also http://www.slf4j.org/codes.html#log4jDelegationLoop for more details.

at org.slf4j.impl.Log4jLoggerFactory.<clinit>(Log4jLoggerFactory.java:54)

... 12 more

2、日志框架桥接示例

使用场景:老项目使用的日志框架是Log4j,现在想要使用Logback, 但是一大堆的Java文件中都有Log4j的导入,并且代码还是Log4j的api代码。因为要使用Logback,就一定要将Log4j相关的maven依赖删除,依赖删除后,这个import导入就一定会报错,一个个去改把,太麻烦了,搞不好改错了,更麻烦,于是就有了日志桥接器,只需要加上桥接器的maven依赖即可,代码一行都不需要改。

1、先模拟老项目使用Log4j日志框架,导入Log4j依赖,编写测试代码

<!--导入log4j依赖-->

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

import org.apache.log4j.BasicConfigurator;

import org.apache.log4j.Logger;

public class SLF4JTest {

public static void main(String[] args) {

BasicConfigurator.configure();

Logger logger = Logger.getLogger(SLF4JTest.class);

logger.error("error test");

logger.warn("warn test");

logger.info("info test");

logger.debug("debug test ");

logger.trace("trace test");

}

}

// 输出内容

0 [main] ERROR SLF4JTest - error test

0 [main] WARN SLF4JTest - warn test

0 [main] INFO SLF4JTest - info test

0 [main] DEBUG SLF4JTest - debug test

2、修改依赖为Logback的日志框架(先注释掉Log4j的依赖,增加Slf4j-api和Logback的依赖):

<!--配置slf4j日志门面-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.32</version>

</dependency>

<!--配置logback-->

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-classic</artifactId>

<version>1.2.5</version>

</dependency>

3、此时由于没有了log4j的依赖包,代码就会提示错误(如果整个项目各个地方用到,每个地方都去修改就会工作量很大)在原有的依赖配置上添加如下依赖:

<!--配置log4j的桥接器-->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>log4j-over-slf4j</artifactId>

<version>1.7.32</version>

</dependency>

4、报错消失,运行上面的代码结果如下(表面上看,导入的是log4j的包,实际上执行效果却是logback的日志打印)

12:14:36.179 [main] ERROR SLF4JTest - error test

12:14:36.179 [main] WARN SLF4JTest - warn test

12:14:36.179 [main] INFO SLF4JTest - info test

12:14:36.179 [main] DEBUG SLF4JTest - debug test

5、SLF4J注意事项与原理解析

1、maven依赖中,尽量保证只有一个日志实现,如果由多个日志实现的话默认使用第一个(maven依赖靠前的那个),并且在控制台会显示以下警告信息

# 提示有多个日志实现

SLF4J: Class path contains multiple SLF4J bindings.

# 第一个日志实现

SLF4J: Found binding in [jar:file:/D:/repository/org/slf4j/slf4j-simple/1.7.25/ slf4j-simple-1.7.25.jar!/org/slf4j/impl/StaticLoggerBin

# 第二个日志实现

SLF4J: Found binding in [jar:file:/D:/repository/org/slf4j/slf4j-log4j12/1.7.12/slf4j-log4j12-1.7.12.jar!/org/slf4j/impl/StaticLoggerBinder.class]

# 默认绑定第一个

SLF4J: Actual binding is of type [org.slf4j.impl.SimpleLoggerFactory]

2、SLF4J原理解析

SLF4J通过LoggerFactory加载日志具体的实现对象。

LoggerFactory在初始化的过程中,会通过performInitialization()方法绑定具体的日志实现。

在绑定具体实现的时候,通过类加载器,加载org/slf4j/impl/StaticLoggerBinder.class

所以只要是一个日志实现框架,在org.slf4j.impl包中提供一个自己的StaticLoggerBinder类,在其中提供具体日志实现的LoggerFactory就可以被SLF4J所加载

6、参考文献 & 鸣谢

- java日志:四、slf4j使用【CSDN:小徐也要努力鸭】https://blog.csdn.net/a232884c/article/details/121160183

- java日志(三)–slf4j和logback使用【CSDN:panda-star】https://blog.csdn.net/chinabestchina/article/details/104743907

3、日志门面JCL

1、JCL简单入门

1、JCL简介

JCL全称为Jakarta Commons Logging,是Apache提供的一个通用日志API。 该日志门面的使用并不是很广泛。它是为 “所有的Java日志实现”提供一个统一的接口,它自身也提供一个日志的实现(SimpleLog)但是功能非常常弱 。所以一般不会单独使用它。它允许开发人员使用不同的具体日志实现工具:Log4j,JDK自带的日志(JUL)

JCL 有两个基本的抽象类:Log(基本记录器)和LogFactory(负责创建Log实例)

APP(Java应用)=> JCL => Log4j、JUL、SimpleLog

日志实现优先级排列:JCL门面技术在获取Log实现时会按照以下顺序依次获取Logger的实现,可以看到优先使用Log4j,如果匹配就不会继续找了

- log4j: 优先使用log4j

- jdk14Logger:jdk自带logger

- jdk13LumberjackLogger:也是jdk自带logger

- SimpleLog: jcl自带的日志框架,功能比较简单

2、JCL示例

1、先添加apache门面的pom依赖

<!--配置JCL日志门面-->

<dependency>

<groupId>commons-logging</groupId>

<artifactId>commons-logging</artifactId>

<version>1.2</version>

</dependency>

2、测试代码打印日志

import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory;

public class JCLTest {

public static void main(String[] args) {

// 创建日志对象

Log log = LogFactory.getLog(JCLTest.class);

// 日志记录输出

log.fatal("fatal");

log.error("error");

log.warn("warn");

log.info("info");

log.debug("debug");

}

}

3、打印结果如下,发现默认情况下使用的是jdk(jdk14)自带的日志框架

3月 31, 2022 9:44:45 下午 JCLTest main

严重: fatal

3月 31, 2022 9:44:45 下午 JCLTest main

严重: error

3月 31, 2022 9:44:45 下午 JCLTest main

警告: warn

3月 31, 2022 9:44:45 下午 JCLTest main

信息: info

4、接下来我们加上Log4j的依赖

<!--配置JCL日志门面-->

<dependency>

<groupId>commons-logging</groupId>

<artifactId>commons-logging</artifactId>

<version>1.2</version>

</dependency>

<!--配置log4j日志实现-->

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

5、再加上Log4j的配置文件 log4j.properties,放在resources目录下